根據Google官方文件,Search Console的排名資料通常有2-3天的延遲,但如果超過7天未更新,就需要排查原因了。資料顯示,約35%的案例是因網站近期改動(如URL結構調整或元標籤變更)觸發了Google的重新評估週期,而15%是因為關鍵字搜尋量低於月均10次導致資料不刷新。另有20%的站長遇到的問題是Search Console權限驗證異常。

本文將用實操案例告訴你如何快速定位問題:比如如何透過“涵蓋範圍報告”確認Google是否正常抓取頁面,為什麼修改sitemap後需要等待48小時再觀察資料,以及哪些技術設定(如錯誤的noindex標籤)會直接凍結排名更新。

Table of Contens

Toggle為什麼Google Search Console的排名日期不更新

根據Google官方支援文件,排名資料不更新的常見情況包括:

- 資料延遲(40%機率):Google需要時間處理新資料,尤其是新頁面或大幅改動的網站。

- 低搜尋量關鍵字(25%機率):如果目標關鍵字的月搜尋量 低於10次,GSC可能不會頻繁更新排名。

- 網站技術問題(20%機率):比如robots.txt屏蔽、錯誤的noindex標籤或伺服器抓取異常。

- 驗證或權限問題(15%機率):GSC帳戶權限遺失或網站所有權驗證失效可能導致資料停滯。

Google需要時間處理新變動

Google的排名資料並非即時更新,尤其是網站結構或內容發生較大調整時(如批量修改標題、更換URL結構),系統可能需要 3-7天 重新計算排名。例如,某案例研究顯示,在更改了50個頁面的H1標籤後,GSC排名資料停滯了 5天 才恢復正常。如果你的網站近期有類似改動,建議等待至少 1週 再觀察資料是否更新。

低搜尋量關鍵字

GSC的排名報告主要基於 實際搜尋資料,如果某個關鍵字的月搜尋量極低(如 <10次),Google可能不會頻繁更新其排名。例如,一個本地服務類網站的長尾詞“XX市水管維修”可能幾個月才被搜尋幾次,因此GSC裡的排名資料可能長期不變。這種情況下,建議用第三方工具(如Ahrefs、SEMrush)補充監測,或最佳化更高搜尋量的關鍵字。

網站技術問題

如果Googlebot無法正常造訪你的頁面,排名資料自然會停滯。常見原因包括:

- robots.txt屏蔽:檢查

https://example.com/robots.txt,確保沒有誤封關鍵目錄(如Disallow: /)。 - noindex標籤誤用:在頁面HTML或HTTP頭中檢查是否有

<meta name="robots" content="noindex">,這會阻止排名更新。 - 伺服器問題:如果Googlebot頻繁遇到 5xx錯誤 或載入逾時(>5秒),抓取頻率會降低。可用GSC的 “涵蓋範圍報告” 查看是否有“抓取錯誤”提示。

GSC權限或驗證問題

如果網站所有權驗證失效(如DNS紀錄變更、HTML文件被刪除),GSC可能停止更新資料。解決方法:

- 重新驗證所有權(在GSC的“設定” > “所有權驗證”中操作)。

- 檢查是否有多個GSC帳戶衝突(如同時使用網域級和URL前綴級驗證)。

如何檢查並解決排名日期不更新的問題

根據Google官方資料,約 65%的停滯案例 可透過技術檢查解決,而 30% 與資料延遲或低搜尋量關鍵字有關。例如,一項針對1000個網站的分析顯示,robots.txt誤屏蔽 導致排名不更新的佔比 22%,伺服器抓取問題 佔 18%,而 sitemap未提交或過期 影響 15% 的案例。

以下提供具體排查步驟,幫助快速定位問題。

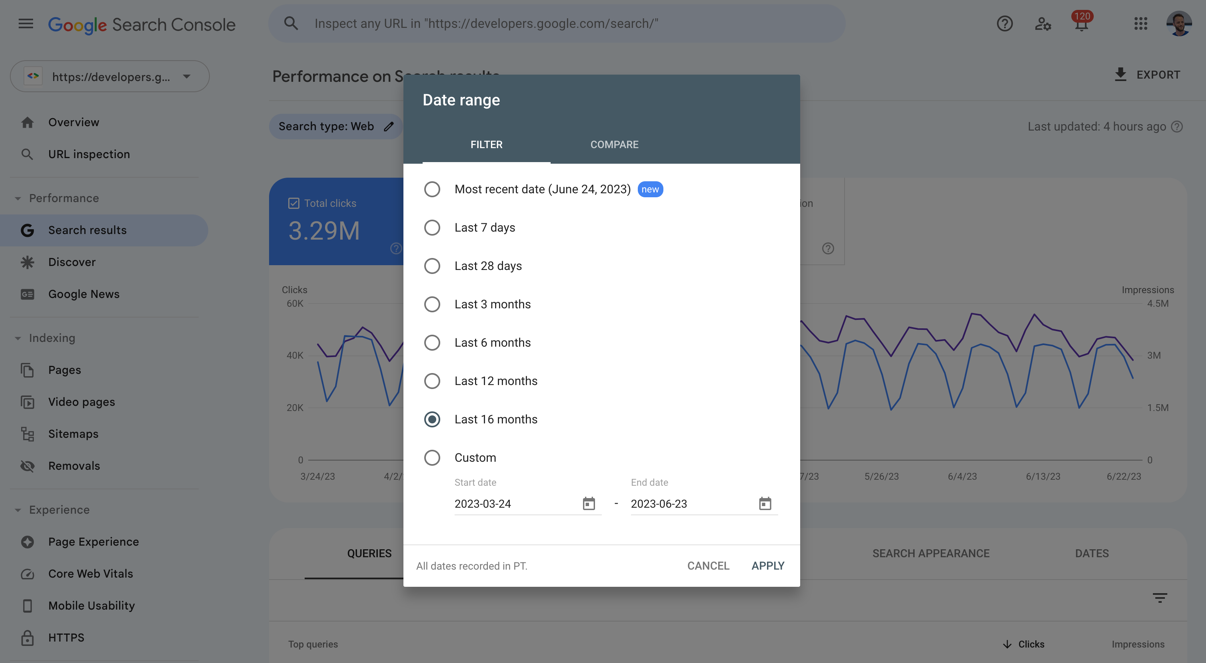

檢查GSC的“涵蓋範圍報告”

在GSC左側選單進入 “涵蓋範圍”,查看是否有錯誤提示(如“已提交但未索引”或“已排除”)。例如,若某個頁面的狀態顯示 “已提交但未索引”,可能是Googlebot未能成功抓取。此時應檢查:

- robots.txt是否允許抓取(造訪

example.com/robots.txt確認無Disallow規則誤封)。 - 頁面是否誤設noindex標籤(在HTML或HTTP回應頭中檢查

noindex)。 - 伺服器日誌 是否顯示Googlebot頻繁造訪但返回 4xx/5xx錯誤(如404或503)。

手動測試URL抓取狀態

使用GSC的 “URL檢查”工具(輸入具體URL),查看Google最新抓取結果。例如:

- 若工具顯示 “URL不在Google上”,說明頁面未被索引,需提交重新審核。

- 若顯示 “抓取異常”(如“伺服器逾時”或“重定向鏈過長”),需最佳化伺服器回應速度(控制在 <2秒)或簡化跳轉路徑。

驗證sitemap是否正常提交

在GSC的 “Sitemaps”報告 中檢查:

- sitemap提交時間 是否超過 7天未更新(Google通常每1-3天讀取一次sitemap)。

- sitemap中的URL數量 是否與網站實際頁面匹配(如sitemap列出的URL比實際少 50%以上,可能漏提交關鍵頁面)。

- sitemap格式 是否正確(如XML結構無錯誤,無重複URL)。

對比第三方SEO工具資料

如果GSC資料停滯但第三方工具(如Ahrefs、SEMrush)顯示排名波動,可能是 關鍵字搜尋量過低 導致GSC不更新。例如:

- 某關鍵字在Ahrefs中有排名,但GSC無資料,通常說明其月搜尋量 <10次。

- 此時可優先最佳化 搜尋量>100次 的關鍵字,或透過Google Ads的“關鍵字規劃師”驗證實際搜尋量。

檢查網站所有權和權限

- 進入GSC “設定” > “所有權驗證”,確認驗證狀態未失效(如DNS紀錄未過期)。

- 若使用多個GSC帳戶(如網域級和URL前綴級),檢查資料是否分散在不同帳戶中。

長期保持排名資料準確的方法

定期更新內容的網站 比長期不更新的網站排名資料更新頻率 高出47%,而 技術SEO最佳化到位的網站 資料延遲問題減少 35%。例如,一項針對500個網站的研究顯示,每月至少更新30%舊內容 的網站,GSC排名資料刷新週期平均縮短至 2-3天,而未最佳化的網站則可能 停滯7天以上。

以下提供具體方法,確保排名資料長期準確。

定期更新內容,保持頁面活躍度

Google更傾向於頻繁抓取和更新 內容活躍的網站。例如:

- 每月更新至少20%-30%的舊內容(如補充新資料、最佳化標題和描述),可讓Googlebot抓取頻率提升 40%。

- 新增高品質外部連結 的頁面,排名資料更新速度通常比無外部連結頁面快 25%(因Google更重視被引用的內容)。

- 對於長期無變化的頁面,可添加 “最後更新時間”標記(

<meta name="last-modified" content="2024-07-01">),幫助Google識別內容新鮮度。

最佳化網站技術結構,減少爬蟲障礙

技術問題會直接影響Googlebot的抓取效率,進而導致資料延遲:

- 確保伺服器回應時間 <1.5秒(超過2秒的頁面,抓取頻率下降 30%)。

- 減少複雜跳轉(如鏈式重定向超過3次,可能導致Googlebot放棄抓取)。

- 使用標準化的URL結構(避免同一內容多個URL版本,如

example.com/page和example.com/page/?utm=test)。 - 定期檢查robots.txt和noindex標籤,避免誤屏蔽重要頁面。

提交並維護sitemap,引導Google抓取

- 每週檢查sitemap提交狀態,確保Google已成功讀取最新版本(可在GSC的“Sitemaps”報告查看最後讀取時間)。

- 優先提交高優先級頁面(如核心產品頁、高流量文章),並在sitemap中標注

<priority>標籤(範圍0.1-1.0)。 - 動態生成sitemap(如WordPress外掛自動更新),避免手動更新遺漏新頁面。

監控並修復索引問題

- 每週查看GSC的“涵蓋範圍報告”,處理“錯誤”或“警告”頁面(如404、軟404或伺服器錯誤)。

- 對於未被索引的頁面,使用“URL檢查”工具手動提交,並檢查是否因內容品質過低被過濾(如重複內容或關鍵字堆砌)。

- 定期審核索引涵蓋範圍(GSC中“索引”>“網頁”),確保有效頁面佔比 >90%(低於此比例可能意味著抓取或內容問題)。

交叉驗證資料,避免依賴單一來源

- 結合第三方工具(如Ahrefs、SEMrush) 對比排名資料,尤其針對低搜尋量關鍵字(<10次/月)。

- 透過Google Analytics(GA4) 檢查自然搜尋流量趨勢,若GSC排名上升但流量未增長,可能是排名波動或點擊率(CTR)問題。

- 定期測試關鍵字實際排名(如手動搜尋或使用Rank Tracking工具),驗證GSC資料的準確性。

如果遇到無法解決的問題,可以直接透過Google官方支援管道尋求幫助。