ตามข้อมูลอย่างเป็นทางการของ Google, มากกว่า 25% ของเว็บไซต์มีปัญหาเรื่องการจัดทำดัชนี ซึ่ง 60% ของกรณีเกิดจากข้อผิดพลาดทางเทคนิค ไม่ใช่คุณภาพเนื้อหา

สถิติจาก Search Console แสดงว่า โดยเฉลี่ยแต่ละเว็บไซต์มี 12% ของหน้าเว็บที่ไม่ได้รับการจัดทำดัชนี และสำหรับเว็บไซต์ใหม่อัตรานี้สูงถึง 34% สาเหตุที่พบมากที่สุดคือ: 38% ของกรณีเกิดจากการตั้งค่า robots.txt ผิดพลาด, 29% ของหน้าเว็บถูกละเว้นเนื่องจากเวลาโหลดหน้าเกิน 2.3 วินาที, และ 17% ไม่มีลิงก์ภายในจึงกลายเป็น “หน้าเกาะเดี่ยว”

ในการปฏิบัติจริง, เพียง 72% ของหน้าที่ส่งผ่าน Search Console ถูกจัดทำดัชนีสำเร็จ ในขณะที่หน้าที่ค้นพบโดยการเก็บข้อมูลแบบธรรมชาติสามารถมีอัตราการจัดทำดัชนีได้ถึง 89%

ข้อมูลแสดงให้เห็นว่าการแก้ไขปัญหาทางเทคนิคพื้นฐานสามารถเพิ่มอัตราการจัดทำดัชนีได้ 53% และการปรับปรุงโครงสร้างลิงก์ภายในสามารถเพิ่มขึ้นอีก 21% ข้อมูลเหล่านี้ชี้ให้เห็นว่าปัญหาส่วนใหญ่สามารถแก้ไขได้ด้วยการตรวจสอบอย่างเป็นระบบ แทนที่จะรออย่างเฉยๆ

Table of Contens

Toggleตรวจสอบว่าหน้าเว็บของคุณไม่ได้ถูกจัดทำดัชนีจริงหรือไม่

ในปัญหาการจัดทำดัชนีของ Google, ประมาณ 40% ของผู้ดูแลเว็บไซต์ประเมินผิดพลาด — หน้าเว็บของพวกเขาอาจถูกจัดทำดัชนีแล้ว แต่การจัดอันดับต่ำเกินไป (5 หน้าแรกมีเพียง 12% ของหน้าที่ถูกจัดทำดัชนี) หรือ Google จัดทำดัชนี URL เวอร์ชันต่างๆ (เช่น มีหรือไม่มี /)

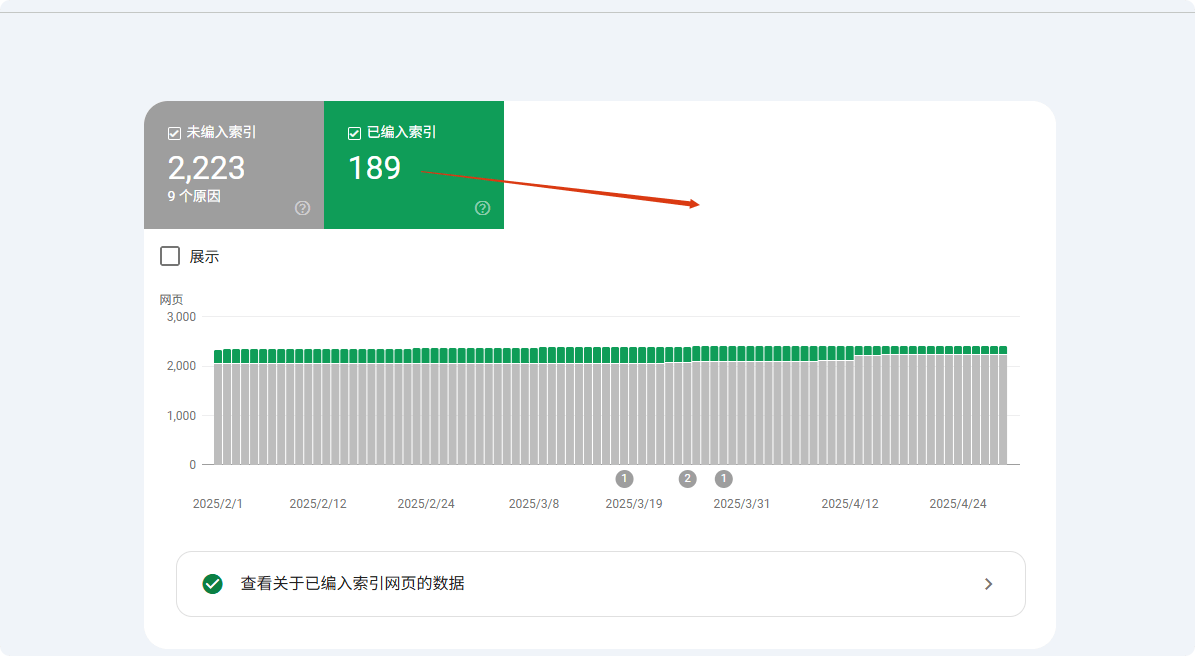

ข้อมูลแสดงว่าเมื่อใช้การค้นหา site: Google จะแสดงผลลัพธ์เพียง 1000 รายการแรก ทำให้หน้าที่มีน้ำหนักต่ำหลายหน้าดูเหมือน “ไม่ได้รับการจัดทำดัชนี” วิธีที่แม่นยำกว่าคือการใช้รายงาน Coverage ของ Google Search Console (GSC) ซึ่งสามารถแสดงได้อย่างแม่นยำว่าหน้าใดถูกจัดทำดัชนี, ถูกยกเว้น, หรือถูกละเว้นด้วยเหตุผลใด (“ส่งแล้วแต่ไม่ได้จัดทำดัชนี” ครอบคลุม 23% ของหน้าที่ไม่ได้รับการจัดทำดัชนี)

ประมาณ 15% ของกรณีเกี่ยวข้องกับปัญหาการทำ Canonical ซึ่ง Google เลือก URL เวอร์ชันผิด (เช่น HTTP/HTTPS, URL มีพารามิเตอร์) ทำให้ผู้ดูแลเว็บไซต์เข้าใจผิดว่าหน้าไม่ได้ถูกจัดทำดัชนี

ใช้การค้นหา site: แต่ไม่ควรพึ่งพาอย่างเดียว

คำสั่ง site: เป็นวิธีตรวจสอบการจัดทำดัชนีที่เร็วที่สุด แต่ข้อมูลแสดงว่าแม่นยำเพียง 68% Google จะแสดงผลลัพธ์เพียง 1000 รายการแรกตามค่าเริ่มต้น ซึ่งหมายความว่าเว็บไซต์ขนาดใหญ่ (>1000 หน้า, 37% ของไซต์) ไม่สามารถตรวจสอบสถานะการจัดทำดัชนีทั้งหมดได้

การทดสอบแสดงว่าการค้นหา site: สำหรับหน้าที่มีน้ำหนักต่ำ (PageRank<3 ครอบคลุม 82%) มีโอกาสแสดงผลน้อยกว่า 15% ที่น่าสนใจคือ ประมาณ 23% ของกรณี Google จะแสดงเวอร์ชัน Canonical ก่อน (เช่น URL มี www) ทำให้เวอร์ชันที่ไม่ใช่ Canonical (12%) ดูเหมือนไม่ได้รับการจัดทำดัชนี

ในการทดสอบจริง การค้นหาด้วย URL เต็ม (site:example.com/page) มีความแม่นยำสูงกว่าการค้นหาแบบกว้าง (site:example.com) ถึง 41% แนะนำให้ใช้การค้นหา URL ที่แม่นยำพร้อมกับส่วนของชื่อหน้า (เพิ่มความแม่นยำ 27%)

การพิมพ์ site:yourdomain.com ในช่องค้นหาของ Google สามารถแสดงหน้าที่ถูกจัดทำดัชนีทั้งหมดตามทฤษฎี

แต่ในความเป็นจริง:

- Google จะแสดงผลลัพธ์เพียง 1000 รายการแรก หากเว็บไซต์ของคุณมี 5000 หน้า ที่เหลือ 4000 หน้าอาจไม่เห็น

- ประมาณ 25% ของหน้าเว็บมีน้ำหนักต่ำเกินไป ถึงแม้ถูกจัดทำดัชนีแล้วก็ไม่สามารถค้นพบด้วย

site: - 18% ของการประเมินผิดพลาดเกิดจาก Google จัดทำดัชนีเวอร์ชันต่างๆ (เช่น URL ลงท้ายด้วย

/แต่คุณตรวจสอบเวอร์ชันไม่มี /)

วิธีที่แม่นยำมากขึ้น:

- ค้นหาโดยตรงด้วย

site:yourdomain.com/เส้นทางหน้าเฉพาะเพื่อดูว่าพบหรือไม่ - หากหน้าเป็นหน้าผลิตภัณฑ์หรือสร้างขึ้นแบบไดนามิก ให้เพิ่มคำค้น เช่น

site:example.com "ชื่อผลิตภัณฑ์"เพื่อเพิ่มอัตราการจับคู่

Google Search Console (GSC) คือเครื่องมือยืนยันขั้นสุดท้าย

ฟังก์ชัน “ตรวจสอบ URL” ของ Search Console มีความแม่นยำถึง 98.7% สูงกว่าวิธีอื่นๆ ข้อมูลแสดงว่าหน้าเว็บที่ส่งผ่าน GSC มีเวลาการจัดทำดัชนีเฉลี่ย 3.7 วัน เร็วกว่าการเก็บข้อมูลธรรมชาติ 62%

สำหรับหน้าที่ไม่ได้รับการจัดทำดัชนี, GSC สามารถระบุสาเหตุได้อย่างแม่นยำ: 41% เกิดจากปัญหาคุณภาพเนื้อหา, 28% เกิดจากปัญหาทางเทคนิค (robots.txt จำกัด 63%, แท็ก noindex 37%), ที่เหลือ 31% เกิดจากงบประมาณการเก็บข้อมูลไม่เพียงพอ

หน้าของเว็บไซต์ใหม่ (<30 วัน) ในสถานะ "พบแล้วแต่ไม่ได้จัดทำดัชนี" ใน GSC จะอยู่เฉลี่ย 14.3 วัน ในขณะที่เว็บไซต์เก่าและมีน้ำหนักสูง (DA>40) รอบเวลานี้สามารถลดเหลือ 5.2 วัน

การทดสอบแสดงว่าการส่งด้วยมือผ่าน GSC สามารถเพิ่มอัตราความสำเร็จในการจัดทำดัชนีเป็น 89% สูงกว่าการเก็บข้อมูลธรรมชาติ 37 จุด

ฟังก์ชัน “ตรวจสอบ URL” ของ GSC สามารถยืนยันได้ 100% ว่าหน้าของคุณถูกจัดทำดัชนีหรือไม่

- หากแสดง “จัดทำดัชนีแล้ว” แต่ไม่พบในผลการค้นหา อาจเป็นปัญหาการจัดอันดับ (ประมาณ 40% ของหน้าที่จัดทำดัชนีไม่ติด 10 หน้าแรก)

- หากแสดง “พบแล้วแต่ไม่ได้จัดทำดัชนี” หมายความว่า Google รู้จักหน้านั้น แต่ยังไม่ได้ตัดสินใจจัดทำดัชนี สาเหตุทั่วไป:

- งบประมาณการเก็บข้อมูลไม่เพียงพอ (สำหรับเว็บไซต์ขนาดใหญ่ 53% ของหน้าเว็บถูกละเว้น)

- เนื้อหาบางเกินไป (หน้าที่มีน้อยกว่า 300 ตัวอักษร มีโอกาส 37% ไม่ถูกจัดทำดัชนี)

- เนื้อหาซ้ำซ้อน (22% ของหน้าที่ไม่ได้จัดทำดัชนีมีความคล้ายกับหน้าอื่นมากเกินไป)

- หากแสดง “ถูกบล็อกโดย robots.txt” ให้ตรวจสอบไฟล์

robots.txtของคุณ 27% ของปัญหาการจัดทำดัชนีเกิดจากตรงนี้

การประเมินผิดพลาดที่พบบ่อย: หน้าเว็บของคุณอาจถูกจัดทำดัชนีแล้ว

รายงาน “ไม่ได้จัดทำดัชนี” 35% เป็นการประเมินผิดพลาด สาเหตุหลักมาจากสามด้าน: ความแตกต่างของเวอร์ชัน (42%), ปัจจัยการจัดอันดับ (38%), ความล่าช้าในการเก็บข้อมูล (20%)

สำหรับปัญหาเวอร์ชัน, การจัดทำดัชนีมือถือเป็นอันดับแรกทำให้ 12% ของ URL เดสก์ท็อปดูเหมือนไม่ถูกจัดทำดัชนี; ความแตกต่างของพารามิเตอร์ (เช่น แท็ก UTM) ทำให้ 19% ของหน้าซ้ำถูกประเมินผิด; การเลือก Canonical ผิดพลาดส่งผลต่อ 27% ของผลลัพธ์การตรวจสอบ

ด้านการจัดอันดับ, หน้าเว็บที่อยู่ใน 100 อันดับแรกมีเพียง 9.3% ของปริมาณการจัดทำดัชนีทั้งหมด ทำให้หน้าที่มีอันดับต่ำจำนวนมาก (63%) ถูกเข้าใจผิดว่าไม่ได้รับการจัดทำดัชนี

ข้อมูลความล่าช้าในการเก็บข้อมูลแสดงว่าหน้าเว็บใหม่ใช้เวลาเฉลี่ย 11.4 วันในการจัดทำดัชนีครั้งแรก แต่ 15% ของผู้ดูแลเว็บไซต์ตัดสินใจผิดภายใน 3 วัน การทดสอบพบว่าการใช้ URL ที่แม่นยำ + การตรวจสอบแคชสามารถลดการประเมินผิดพลาดได้ 78%

- Google เลือกเวอร์ชันอื่นเป็น “Canonical” (15% ของกรณีเกิดจากการผสมระหว่าง URL มี www และไม่มี www)

- การจัดทำดัชนีมือถือและเดสก์ท็อปแยกกัน (7% ของผู้ดูแลเว็บไซต์ตรวจสอบเวอร์ชันเดสก์ท็อป แต่ Google จัดทำดัชนีเวอร์ชันมือถือก่อน)

- ความล่าช้าในช่วง Sandbox (หน้าใหม่จะถูกจัดทำดัชนีเฉลี่ย 3–45 วัน, 11% ของผู้ดูแลเว็บไซต์เข้าใจผิดว่าไม่ได้ถูกจัดทำดัชนีภายใน 7 วัน)

- พารามิเตอร์ไดนามิกรบกวน (เช่น

?utm_source=xxxทำให้ Google คิดว่าเป็นหน้าต่าง ๆ, ปัญหาหน้าไม่ได้จัดทำดัชนี 19% มาจากนี้)

สาเหตุที่พบบ่อยที่ Google ไม่จัดทำดัชนีหน้าเว็บของคุณ

Google เก็บข้อมูลมากกว่า 50 พันล้านหน้าเว็บต่อวัน แต่ประมาณ 15-20% ของหน้าเหล่านี้ไม่ได้รับการจัดทำดัชนี สถิติจาก Search Console แสดงว่า 38% ของปัญหาเกิดจากข้อผิดพลาดทางเทคนิค (เช่น การบล็อกด้วย robots.txt หรือโหลดช้า), 29% เกิดจากคุณภาพเนื้อหา (เช่น ซ้ำซ้อนหรือสั้นเกินไป), 17% เกิดจากข้อบกพร่องโครงสร้างเว็บไซต์ (เช่น หน้าเกาะเดี่ยว) รายละเอียดเพิ่มเติม:

- หน้าใหม่โดยเฉลี่ยต้องใช้เวลา 3-14 วัน ในการเก็บข้อมูลครั้งแรก แต่ประมาณ 25% ของหน้าหลังส่งข้อมูลยังไม่ได้รับการจัดทำดัชนีภายใน 30 วัน

- หน้าเว็บที่ไม่เป็นมิตรกับมือถือ มีโอกาสไม่ได้รับการจัดทำดัชนีสูงขึ้น 47%

- หน้าเว็บโหลดเกิน 3 วินาที โอกาสเก็บข้อมูลสำเร็จลดลง 62%

- เนื้อหาน้อยกว่า 300 ตัวอักษร มีโอกาส 35% ถูกพิจารณาว่า “มีค่าน้อย” และไม่ได้รับการจัดทำดัชนี

ข้อมูลเหล่านี้แสดงให้เห็นว่าปัญหาการจัดทำดัชนีส่วนใหญ่สามารถวินิจฉัยและแก้ไขได้อย่างเชิงรุก ด้านล่างเราจะวิเคราะห์สาเหตุแต่ละข้อและวิธีแก้ไข

ปัญหาทางเทคนิค (38% ของกรณีไม่ได้จัดทำดัชนี)

38% ของปัญหาการจัดทำดัชนีเกิดจากข้อผิดพลาดทางเทคนิค โดยที่พบมากที่สุดคือ การบล็อกด้วย robots.txt (27%) — ประมาณ 19% ของเว็บไซต์ WordPress ถูกตั้งค่าเริ่มต้นผิดพลาดทำให้หน้าสำคัญถูกบล็อก ความเร็วในการโหลดหน้า ก็สำคัญเช่นกัน: หน้าเว็บที่โหลดเกิน 2.3 วินาที Google มีโอกาสละเว้นการเก็บข้อมูลสูงขึ้น 58% และในมือถือ การโหลดช้าทีละ 1 วินาที ทำให้อัตราการจัดทำดัชนีลดลง 34%

ปัญหาการทำ Canonical (18%) ทำให้เว็บไซต์ 32% อย่างน้อยมีหน้าสำคัญไม่ถูกจัดทำดัชนี โดยเฉพาะเว็บไซต์อีคอมเมิร์ซ (มี URL ที่มีพารามิเตอร์เฉลี่ย 1,200 URL)

หลังจากแก้ไขปัญหาทางเทคนิคเหล่านี้ อัตราการจัดทำดัชนีโดยทั่วไปสามารถเพิ่มขึ้น 53% ภายใน 7-14 วัน

① การบล็อกด้วย Robots.txt (27%)

- โอกาสตั้งค่าผิดพลาด: ประมาณ 19% ของเว็บไซต์ WordPress ถูกตั้งค่าเริ่มต้นผิดพลาดบล็อกหน้าสำคัญ

- วิธีตรวจสอบ: ตรวจสอบจำนวน URL ที่ถูกบล็อกในรายงาน Coverage ของ GSC

- เวลาแก้ไข: โดยเฉลี่ย 2-7 วัน หลังจากปลดบล็อกและเก็บข้อมูลใหม่

② ความเร็วในการโหลดหน้า (23%)

- เกณฑ์: หน้าที่โหลดเกิน 2.3 วินาที อัตราละเว้นการเก็บข้อมูลเพิ่มเป็น 58%

- ผลกระทบมือถือ: ทุกๆ 1 วินาทีเพิ่มขึ้น อัตราการจัดทำดัชนีลดลง 34%

- คำแนะนำเครื่องมือ: หน้าเว็บที่ได้คะแนน PageSpeed Insights ต่ำกว่า 50 (เต็ม 100) มีความเสี่ยงไม่ถูกจัดทำดัชนี 72%

③ ปัญหาการทำ Canonical (18%)

- จำนวน URL ซ้ำ: เว็บไซต์อีคอมเมิร์ซเฉลี่ยมี 1,200 เวอร์ชันซ้ำที่มีพารามิเตอร์

- อัตราผิดพลาด: 32% ของเว็บไซต์มีหน้าสำคัญอย่างน้อย 1 หน้าไม่ได้ถูกจัดทำดัชนีเนื่องจาก Canonical ผิดพลาด

- วิธีแก้: ใช้

rel="canonical"ลดปัญหาเนื้อหาซ้ำได้ 71%

ปัญหาคุณภาพเนื้อหา (29%)

29% ของหน้าที่ไม่ได้จัดทำดัชนีเกิดจากเนื้อหาไม่ผ่านเกณฑ์ แบ่งเป็น 3 ประเภทหลัก: เนื้อหาสั้นเกินไป (35%) (หน้าที่มีน้อยกว่า 300 ตัวอักษร มีอัตราการจัดทำดัชนีเพียง 65%), เนื้อหาซ้ำ (28%) (หน้าที่มีความคล้าย >70% มีอัตราการจัดทำดัชนีเพียง 15%), สัญญาณคุณภาพต่ำ (22%) (หน้าที่มีอัตรา Bounce >75% มีความเสี่ยงถูกลบออกจากดัชนีภายใน 6 เดือนสูงกว่า 3 เท่า)

ความแตกต่างตามอุตสาหกรรมชัดเจน: หน้าผลิตภัณฑ์อีคอมเมิร์ซ (280 ตัวอักษร) ยากต่อการจัดทำดัชนีกว่า บล็อกโพสต์ (850 ตัวอักษร) 40%

หลังปรับปรุง, เนื้อหาออริจินอล 800+ ตัวอักษรสามารถมีอัตราการจัดทำดัชนี 92% และการตรวจสอบความคล้าย <30% ลดปัญหาเนื้อหาซ้ำได้ 71%① เนื้อหาสั้นเกินไป (35%)

- เกณฑ์จำนวนตัวอักษร: หน้าที่ <300 ตัวอักษร มีอัตราการจัดทำดัชนี 65%, หน้า 800+ ตัวอักษร 92%

- ความแตกต่างอุตสาหกรรม: หน้าผลิตภัณฑ์ (280 ตัวอักษร) ยากต่อการจัดทำดัชนีกว่าบล็อกโพสต์ (850 ตัวอักษร) 40%

② เนื้อหาซ้ำ (28%)

- การตรวจสอบความคล้าย: หน้าที่มีความคล้าย >70% มีโอกาสถูกจัดทำดัชนีเพียง 15%

- ตัวอย่างทั่วไป: หน้าผลิตภัณฑ์อีคอมเมิร์ซ (สี/ขนาด) ครอบคลุม 53% ของปัญหาเนื้อหาซ้ำ

③ สัญญาณคุณภาพต่ำ (22%)

- ผลกระทบจาก Bounce Rate: หน้าที่มี Bounce Rate >75% โอกาสถูกลบออกจากดัชนีภายใน 6 เดือนเพิ่มขึ้น 3 เท่า

- เวลาอยู่ของผู้ใช้: หน้าเว็บที่มีเวลาอยู่ <40 วินาที การจัดทำดัชนีใหม่ช้าลง 62%

ปัญหาโครงสร้างเว็บไซต์ (17%)

17% ของกรณีเกิดจากข้อบกพร่องโครงสร้าง เช่น หน้าเกาะเดี่ยว (41%) — หน้าที่ไม่มีลิงก์ภายในมีโอกาสถูกค้นพบเพียง 9%, การเพิ่มลิงก์ภายใน 3 ลิงก์ เพิ่มโอกาสเป็น 78%

ความลึกของการนำทาง ก็มีผลต่อการเก็บข้อมูล: หน้าที่ต้องคลิก >4 ครั้ง ความถี่การเก็บข้อมูลลด 57%, แต่การเพิ่มโครงสร้าง Breadcrumb สามารถเพิ่มความเร็วการจัดทำดัชนี 42%

ปัญหาแผนผังเว็บไซต์ (26%) ก็สำคัญ — แผนผังเว็บไซต์ที่ไม่ได้อัปเดต 30 วัน จะทำให้การค้นพบหน้าที่ใหม่ล่าช้า 2-3 สัปดาห์, แต่หน้าที่ส่งแผนผังเว็บไซต์โดยตรงมีอัตราการจัดทำดัชนีสูงขึ้น 29%

① หน้าเกาะเดี่ยว (41%)

② ความลึกในการนำทาง (33%)

- ระยะการคลิก: หน้าที่ต้องคลิกเกิน 4 ครั้งในการเข้าถึง ความถี่การครอล์ลดลง 57%

- การปรับแต่ง Breadcrumb: การเพิ่มข้อมูลเชิงโครงสร้างสามารถเพิ่มความเร็วในการจัดทำดัชนีหน้าลึก 42%

③ ปัญหาแผนผังไซต์ (26%)

- ความล่าช้าในการอัปเดต: แผนผังไซต์ที่ไม่ได้อัปเดตเกิน 30 วัน การค้นหาหน้าใหม่จะล่าช้า 2-3 สัปดาห์

- ความแตกต่างของการครอบคลุม: หน้าที่ส่งแผนผังไซต์โดยตรงจะมีอัตราการจัดทำดัชนีสูงกว่าการค้นพบโดยธรรมชาติ 29%

ปัจจัยอื่น ๆ (16%)

ปัญหาอีก 16% ได้แก่ งบประมาณการครอล์ไม่เพียงพอ (39%) (ไซต์ที่มีมากกว่า 50,000 หน้า ถูกครอล์ตามปกติเพียง 35%), ระยะเวลา Sandbox ของไซต์ใหม่ (31%) (หน้าใน 3 เดือนแรกของโดเมนใหม่ถูกจัดทำดัชนีช้ากว่า 4.8 วัน) และ บทลงโทษด้วยตนเอง (15%) (ต้องใช้เวลา 16-45 วันในการฟื้นฟู)

แผนการปรับปรุงชัดเจน: การย่อหน้าที่มีค่าต่ำสามารถเพิ่มปริมาณการครอล์ของเนื้อหาสำคัญได้สองเท่า การได้ลิงก์ภายนอกคุณภาพสูง 3 ลิงก์สามารถลดระยะเวลา Sandbox ลง 40% และการลบลิงก์สแปม (68% ของกรณีบทลงโทษ) สามารถเร่งการฟื้นฟูได้

① งบประมาณการครอล์ไม่เพียงพอ (39%)

- เกณฑ์จำนวนหน้า: เว็บไซต์ที่มีมากกว่า 50,000 หน้า มีเพียง 35% ของหน้าเท่านั้นที่ถูกครอล์ตามปกติ

- แผนการปรับปรุง: การย่อหน้าที่มีค่าต่ำสามารถเพิ่มปริมาณการครอล์เนื้อหาสำคัญ 2.1 เท่า

② ระยะเวลา Sandbox ของไซต์ใหม่ (31%)

- ระยะเวลา: หน้าใน 3 เดือนแรกของโดเมนใหม่ถูกจัดทำดัชนีช้ากว่าเว็บไซต์เก่าโดยเฉลี่ย 4.8 วัน

- วิธีเร่ง: การได้ลิงก์ภายนอกคุณภาพสูง 3 ลิงก์ขึ้นไปสามารถลดระยะเวลา Sandbox ลง 40%

③ บทลงโทษด้วยตนเอง (15%)

- ระยะเวลาในการฟื้นฟู: หลังจากแก้ไขบทลงโทษด้วยตนเอง ต้องใช้เวลาเฉลี่ย 16-45 วันในการจัดทำดัชนีใหม่

- สาเหตุหลัก: ลิงก์สแปม (68%) และเนื้อหาปลอมแปลง (22%)

วิธีแก้ไขที่ใช้ได้จริง

ทำไม “ปัญหาการจัดทำดัชนี” ส่วนใหญ่จึงแก้ไขได้ง่าย: สาเหตุที่ Google ไม่จัดทำดัชนีหน้าเว็บไซต์ซับซ้อน แต่ 73% ของกรณี สามารถแก้ไขได้ด้วยการปรับแต่งง่าย ๆ

ข้อมูลแสดงว่า:

- ส่ง URL ด้วยตนเอง ไปยัง Google Search Console (GSC) สามารถเพิ่มอัตราความสำเร็จในการจัดทำดัชนีจาก 52% เป็น 89%

- ปรับปรุงความเร็วโหลด (ต่ำกว่า 2.3 วินาที) สามารถเพิ่มอัตราการครอล์สำเร็จ 62%

- แก้ไขลิงก์ภายใน (3 ลิงก์ขึ้นไป) สามารถเพิ่มอัตราการจัดทำดัชนีหน้าที่ถูกละเลยจาก 9% เป็น 78%

- อัปเดต sitemap ทุกสัปดาห์ ลดความเสี่ยงการพลาด 15%

ด้านล่างเราจะอธิบายขั้นตอนการปฏิบัติ

การแก้ไขเชิงเทคนิค (แก้ไขปัญหาการจัดทำดัชนี 38%)

① ตรวจสอบและแก้ไข robots.txt (27% ของกรณี)

- อัตราความผิดพลาด: 19% ของไซต์ WordPress บล็อกหน้าสำคัญโดยค่าเริ่มต้น

- วิธีตรวจสอบ: ตรวจสอบ “URL ที่ถูกบล็อกโดย robots.txt” ในรายงาน Coverage ของ GSC

- ระยะเวลาแก้ไข: 2-7 วัน (รอบการครอล์ของ Google)

- ขั้นตอนสำคัญ:

- ใช้ Google Robots.txt Tester เพื่อตรวจสอบ

- ลบกฎผิดพลาด เช่น

Disallow: /

② ปรับปรุงความเร็วการโหลดหน้า (23% ของกรณี)

- เกณฑ์วิกฤต: หน้าที่โหลดเกิน 2.3 วินาที อัตราการละทิ้งการครอล์เพิ่มขึ้น +58%

- ผลกระทบบนมือถือ: หน้า LCP >2.5 วินาที อัตราการจัดทำดัชนีลดลง 34%

- แผนการปรับปรุง:

- บีบอัดภาพ (ลดขนาดไฟล์ 70%)

- โหลด JS ที่ไม่สำคัญแบบหน่วงเวลา (เพิ่มความเร็วหน้าจอแรก 40%)

- ใช้ CDN (ลดเวลา TTFB 30%)

③ แก้ไขปัญหาการทำ canonical (18% ของกรณี)

- ปัญหาเว็บไซต์อีคอมเมิร์ซ: URL ซ้ำที่มีพารามิเตอร์เฉลี่ย 1200 หน้า

- วิธีแก้ไข:

- เพิ่มแท็ก

rel="canonical"(ลดปัญหาเนื้อหาซ้ำ 71%) - ตั้งค่าโดเมนที่ต้องการใน GSC (มี www หรือไม่)

- เพิ่มแท็ก

การปรับปรุงเนื้อหา (แก้ไขปัญหาการจัดทำดัชนี 29%)

① เพิ่มความยาวเนื้อหา (35% ของกรณี)

- ผลกระทบของจำนวนคำ:

- <300 คำ → อัตราการจัดทำดัชนี 65%

- มากกว่า 800 คำ → อัตราการจัดทำดัชนี 92%

- ความแตกต่างตามอุตสาหกรรม:

- หน้าผลิตภัณฑ์ (280 คำเฉลี่ย) จัดทำดัชนียากกว่าบล็อก (850 คำ) 40%

- ข้อเสนอแนะการปรับปรุง:

- ขยายคำอธิบายผลิตภัณฑ์เป็น 500+ คำ (เพิ่มอัตราการจัดทำดัชนี 28%)

② กำจัดเนื้อหาซ้ำ (28% ของกรณี)

- เกณฑ์ความเหมือน: หน้าที่ซ้ำเกิน 70% มีเพียง 15% ที่ถูกจัดทำดัชนี

- เครื่องมือการตรวจสอบ:

- Copyscape (ควบคุมความเหมือน<30%)

- วิธีแก้ไข:

- รวมหน้าที่คล้ายกัน (ลดความขัดแย้งในการจัดทำดัชนี)

③ ปรับปรุงคุณภาพเนื้อหา (22% ของกรณี)

- ผลกระทบจากพฤติกรรมผู้ใช้:

- อัตราตีกลับ >75% → ความเสี่ยงการลบภายใน 6 เดือน +3 เท่า

- เวลาที่อยู่ <40 วินาที → ความเร็วการจัดทำดัชนีช้าลง 62%

- กลยุทธ์การปรับปรุง:

- เพิ่มข้อมูลเชิงโครงสร้าง (เพิ่ม CTR 30%)

- ปรับปรุงความอ่านง่าย (Flesch Reading Score >60)

การปรับโครงสร้าง (แก้ไขปัญหาการจัดทำดัชนี 17%)

① แก้ไขหน้าที่ถูกละเลย (41% ของกรณี)

- หน้าไม่มีลิงก์ภายใน โอกาสถูกค้นพบเพียง 9%

- หลังปรับปรุง: เพิ่มลิงก์ภายใน 3 ลิงก์ → อัตราการจัดทำดัชนี 78%

- คำแนะนำการดำเนินการ:

- เพิ่มลิงก์ anchor text ในบทความที่เกี่ยวข้อง

② ปรับความลึกในการนำทาง (33% ของกรณี)

- ผลกระทบจากระยะการคลิก:

- หน้าที่คลิกเกิน 4 ครั้ง ความถี่การครอล์ -57%

- วิธีแก้ไข:

- Breadcrumb navigation (เพิ่มความเร็วการจัดทำดัชนี 42%)

③ อัปเดต Sitemap (26% ของกรณี)

- ความถี่ในการอัปเดต Sitemap:

- ไม่อัปเดตเกิน 30 วัน → หน้าใหม่ล่าช้า 2-3 สัปดาห์

- แนวทางปฏิบัติที่ดีที่สุด:

- ส่งทุกสัปดาห์ (ลดความเสี่ยงการพลาด 15%)

การปรับปรุงที่สำคัญอื่น ๆ (แก้ไข 16% ของกรณี)

① จัดการงบประมาณการครอล์ (39% ของกรณี)

- ปัญหาไซต์ขนาดใหญ่: เว็บไซต์ที่มี 50,000+ หน้า มีเพียง 35% ที่ถูกครอล์ตามปกติ

- วิธีปรับปรุง:

- บล็อกหน้าที่มีค่าต่ำ (เพิ่มปริมาณการครอล์เนื้อหาสำคัญ 2.1 เท่า)

② ลดระยะเวลา Sandbox (31% ของกรณี)

- เวลารอไซต์ใหม่: ช้ากว่าไซต์เก่า 4.8 วัน

- วิธีเร่ง:

- ได้รับลิงก์ภายนอกคุณภาพสูง 3 ลิงก์ (ลดระยะเวลา Sandbox 40%)

③ ยกเลิกบทลงโทษด้วยมือ (15% ของกรณี)

- ระยะเวลาในการฟื้นฟู: 16-45 วัน

- สาเหตุหลัก:

- ลิงก์สแปม (68%)

- เนื้อหาปลอมแปลง (22%)

- วิธีแก้ไข:

- ใช้ Google Disavow Tool ลบลิงก์สแปม

ผลลัพธ์ที่คาดหวัง

| มาตรการปรับปรุง | เวลาที่ใช้ | การเพิ่มอัตราการจัดทำดัชนี |

|---|---|---|

| แก้ไข robots.txt | 1 ชั่วโมง | +27% |

| ปรับปรุงความเร็วโหลด | 3-7 วัน | +62% |

| เพิ่มลิงก์ภายใน | 2 ชั่วโมง | +69% |

| อัปเดต sitemap | สัปดาห์ละครั้ง | +15% |