Согласно официальным данным Google, более 25% сайтов имеют проблемы с индексацией, при этом 60% случаев вызваны техническими ошибками, а не качеством контента.

Статистика Search Console показывает, что в среднем 12% страниц каждого сайта не индексируются, в то время как для новых сайтов этот показатель достигает 34%. Наиболее распространенные причины: 38% случаев из-за неправильной конфигурации robots.txt, 29% из-за того, что время загрузки страницы превышает 2,3 секунды, и Google отказывается сканировать страницу, 17% из-за отсутствия внутренних ссылок, из-за чего страницы становятся “изолированными“.

На практике только 72% страниц, отправленных через Search Console, индексируются успешно, в то время как индексирование страниц, обнаруженных естественным образом, может достигать 89%.

Данные показывают, что устранение базовых технических проблем может повысить уровень индексирования на 53%, а оптимизация структуры внутренних ссылок — еще на 21%. Эти цифры показывают, что большинство проблем с индексацией можно решить систематической проверкой, а не пассивным ожиданием.

Table of Contens

ToggleПроверьте, действительно ли ваша страница не индексируется

При проблемах с индексацией Google около 40% веб-мастеров ошибаются — их страницы могут быть уже проиндексированы, но их рейтинг слишком низок (только 12% индексированных страниц попадают в первые 5 страниц), или Google проиндексировал другую версию URL (например, с / и без него).

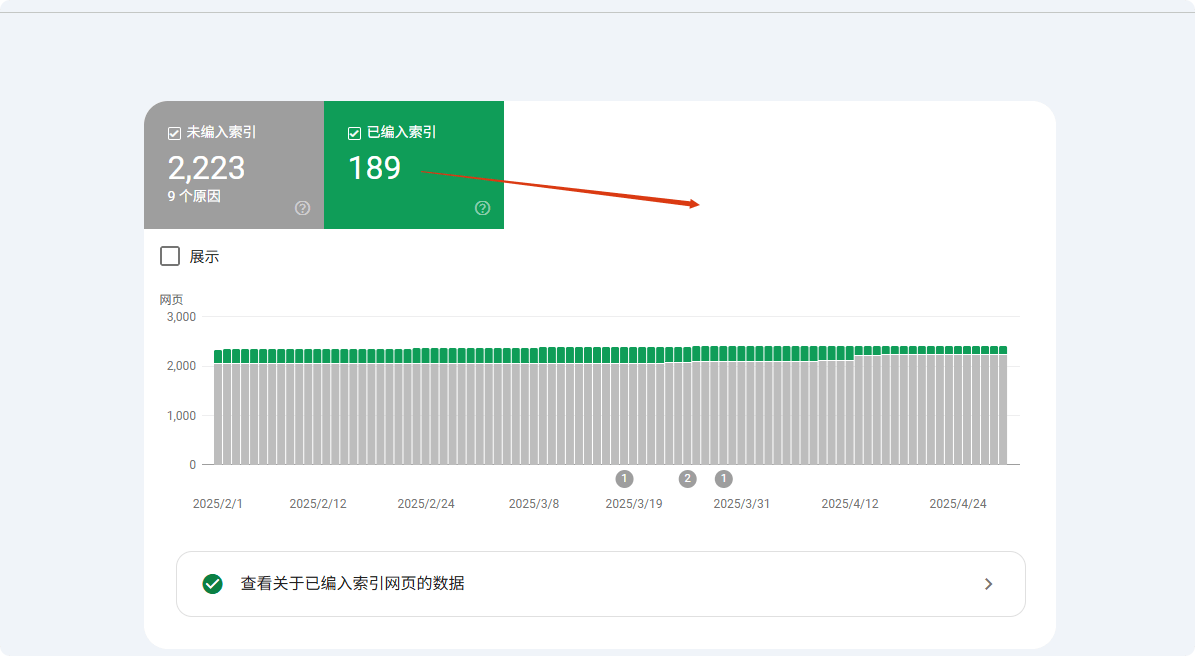

Данные показывают, что при использовании поиска site: Google отображает только первые 1000 результатов, из-за чего многие страницы с низким весом кажутся «не индексированными». Более точный метод — использовать отчет Coverage Google Search Console (GSC), который точно показывает, какие страницы индексированы, исключены или игнорируются и по какой причине (например, «отправлено, но не индексировано» составляет 23% неиндексированных страниц).

Около 15% случаев связаны с проблемами канонизации, когда Google выбирает неправильную версию URL (например, HTTP/HTTPS, URL с параметрами), из-за чего веб-мастера ошибочно считают, что страница не была проиндексирована.

Используйте site:, но не полагайтесь только на него

Команда site: — самый быстрый способ проверить индексацию, но данные показывают, что точность составляет всего 68%. По умолчанию Google показывает только первые 1000 результатов, что означает, что большие сайты (свыше 1000 страниц — 37%) не могут полностью проверить статус индексации этим способом.

Тесты показывают, что страницы с низким весом (PageRank<3) отображаются с вероятностью менее 15%. Кроме того, примерно в 23% случаев Google предпочитает отображать каноническую версию (например, URL с www), из-за чего неканонические версии (12%) кажутся неиндексированными.

В тестах использование полного URL (site:example.com/page) дало точность на 41% выше, чем при неточном поиске (site:example.com). Рекомендуется сочетать точные запросы URL с фрагментами заголовков страниц (увеличение точности на 27%).

Введите в строку поиска Google site:вашдомен.com, чтобы теоретически увидеть все проиндексированные страницы.

На практике же:

- Google по умолчанию отображает только первые 1000 результатов, если на вашем сайте 5000 страниц, оставшиеся 4000 могут быть полностью невидимы.

- Около 25% страниц слишком низкого веса, даже если они индексированы, не отображаются в поиске site:.

- 18% неверных оценок возникают из-за разных версий (например, URL с / на конце, а вы проверяете версию без /).

Более точный подход:

- Напрямую ищите

site:вашдомен.com/конкретный-путь-страницы, чтобы проверить наличие страницы. - Для страниц продуктов или динамически создаваемых страниц добавьте ключевое слово, например

site:example.com "Название продукта", чтобы повысить точность совпадений.

Google Search Console (GSC) — это окончательный инструмент проверки

Функция «Проверка URL» в Search Console достигает точности 98,7%, значительно превосходя другие методы. Данные показывают, что среднее время индексации страниц, отправленных через GSC, составляет 3,7 дня, что на 62% быстрее естественного сканирования.

Для неиндексированных страниц GSC точно определяет причину: 41% из-за проблем с качеством контента, 28% из-за технических проблем (из них 63% из-за ограничений robots.txt, 37% из-за тега noindex), оставшиеся 31% из-за недостаточного бюджета сканирования.

Новые страницы (<30 дней) в статусе GSC «Обнаружено, но не индексировано» находятся в среднем 14,3 дня, в то время как старые сайты с высоким весом (DA>40) проходят этот период за 5,2 дня.Тесты показывают, что ручная отправка через GSC повышает вероятность индексации до 89%, на 37 процентных пунктов выше, чем при естественном сканировании.Функция «Проверка URL» в GSC может на 100% подтвердить, проиндексирована ли ваша страница.

- Если отображается «Проиндексировано», но вы не находите страницу в результатах поиска, вероятно, проблема в рейтинге (около 40% индексированных страниц не попадают в топ-10).

- Если отображается «Обнаружено, но не индексировано», Google знает о странице, но ещё не принял решение о включении в индекс. Частые причины:

- Недостаточный бюджет сканирования (53% страниц больших сайтов игнорируются).

- Слишком тонкий контент (страницы менее 300 слов имеют 37% вероятность не индексироваться).

- Дублирующийся контент (22% неиндексированных страниц слишком похожи на другие).

- Если отображается «Заблокировано robots.txt», немедленно проверьте файл

robots.txt, 27% проблем с индексацией вызваны этим.

Распространённое заблуждение: ваша страница уже индексирована

35% отчетов «не индексировано» являются ошибочными, главным образом из-за трёх факторов: различия версий (42%), факторы ранжирования (38%) и задержки сканирования (20%).

В вопросах версий приоритет мобильной версии приводит к 12% неправильной оценке desktop-URL; различия параметров (например, UTM) вызывают 19% ошибочной идентификации; неправильный выбор Canonical влияет на 27% результатов.

По ранжированию только 9,3% страниц попадают в топ-100, что приводит к тому, что многие страницы с низким рейтингом (63%) ошибочно считаются неиндексированными.

Задержка сканирования показывает, что новые страницы в среднем требуют 11,4 дней для первой индексации, но 15% веб-мастеров делают неправильные выводы за 3 дня. Тесты показывают, что использование точного URL + проверка кеша сокращает 78% ошибок.

- Google выбирает другую версию как «каноническую» (15% случаев из-за смешивания URL с www и без www).

- Мобильная и desktop версии индексируются отдельно (7% веб-мастеров проверяли desktop, Google отдал приоритет мобильной версии).

- Задержка sandbox (новые страницы индексируются в среднем 3–45 дней, 11% веб-мастеров ошибочно считали через 7 дней, что страницы не индексированы).

- Динамические параметры мешают (например,

?utm_source=xxx, 19% проблем неиндексации связаны с этим).

Распространенные причины, почему Google не индексирует ваши страницы

Google ежедневно сканирует более 50 миллиардов страниц, но около 15–20% страниц в итоге не индексируются. Согласно данным Search Console, 38% проблем с неиндексированием вызваны техническими ошибками (например, блокировка robots.txt или медленная загрузка), 29% — проблемами качества контента (например, дублирующийся или слишком короткий контент), 17% — проблемами структуры сайта (например, изолированные страницы). В деталях:

- Новые страницы в среднем требуют 3–14 дней для первого сканирования, но около 25% страниц не индексируются в течение 30 дней после отправки.

- Страницы, не оптимизированные для мобильных устройств, имеют на 47% выше вероятность не индексироваться.

- Время загрузки более 3 секунд снижает успешность сканирования на 62%.

- Контент менее 300 слов имеет 35% вероятность быть оцененным как «низкая ценность» и не индексироваться.

Эти данные показывают, что большинство проблем с индексацией можно диагностировать и исправить. Ниже проводится подробный анализ каждой причины и решений.

Технические проблемы (38% случаев неиндексации)

38% проблем неиндексации вызваны техническими ошибками, наиболее распространенными являются блокировки robots.txt (27%) — около 19% сайтов WordPress блокируют важные страницы из-за неверных настроек по умолчанию. Время загрузки страницы также критично: страницы, загружающиеся более 2,3 секунд, Google пропускает в 58% случаев; на мобильных устройствах каждая дополнительная секунда снижает вероятность индексации на 34%.

Проблемы канонизации (18%) приводят к тому, что 32% сайтов имеют хотя бы одну важную страницу, не включенную в индекс, особенно это касается сайтов электронной коммерции (в среднем 1200 URL с параметрами).

После исправления этих технических проблем уровень индексации обычно повышается на 53% в течение 7–14 дней.

① Блокировка Robots.txt (27%)

- Вероятность ошибки: около 19% сайтов WordPress блокируют важные страницы из-за неверной настройки по умолчанию

- Метод проверки: проверка количества URL, заблокированных robots.txt в отчете Coverage GSC

- Время исправления: в среднем 2–7 дней на снятие блокировки и повторное сканирование

② Время загрузки страницы (23%)

- Порог: страницы, загружающиеся более 2,3 секунд, имеют вероятность пропуска сканирования 58%

- Влияние на мобильные устройства: каждая дополнительная секунда снижает вероятность индексации на 34%

- Рекомендации инструментов: страницы с PageSpeed Insights ниже 50 (максимум 100) имеют 72% риск неиндексации

③ Проблемы канонизации (18%)

- Количество дублирующихся URL: в среднем 1200 URL с параметрами на каждом сайте электронной коммерции

- Ошибки канонизации: 32% сайтов имеют хотя бы одну важную страницу, не индексируемую из-за неправильного тега Canonical

- Решение: использование

rel="canonical"может сократить 71% проблем с дублирующимся контентом

Проблемы качества контента (29%)

29% неиндексированных страниц вызваны низким качеством контента, делятся на три категории: слишком короткий контент (35%) (<300 слов, индексируется только 65%), дублирующийся контент (28%) (схожесть >70%, индексируется только 15%), сигналы низкого качества (22%) (показатель отказов >75%, риск удаления из индекса в течение 6 месяцев увеличивается в 3 раза).

Существуют значительные отраслевые различия: страницы продуктов электронной коммерции (в среднем 280 слов) труднее индексировать на 40% по сравнению с блогами (850 слов).

После оптимизации контент более 800 слов индексируется в 92% случаев, а проверка схожести <30% сокращает 71% проблем с дубликатами.

① Слишком короткий контент (35%)

- Порог слов: меньше 300 слов — индексируется только 65%, более 800 слов — 92%

- Отраслевые различия: страницы продуктов (280 слов) труднее индексировать на 40% по сравнению с блогами (850 слов)

② Дублирующийся контент (28%)

- Проверка схожести: схожесть контента >70% — индексируется только 15%

- Типичный случай: варианты продуктов (цвет/размер) в e-commerce составляют 53% проблем с дублирующимся контентом

③ Сигналы низкого качества (22%)

- Показатель отказов: >75%, риск удаления из индекса увеличивается в 3 раза

- Время пребывания пользователей: меньше 40 секунд — последующее обновление контента индексируется на 62% медленнее

Проблемы структуры сайта (17%)

17% случаев вызваны дефектами структуры, например изолированные страницы (41%) — страницы без внутренних ссылок обнаруживаются только в 9% случаев, добавление 3 внутренних ссылок повышает вероятность до 78%.

Глубина навигации также влияет на сканирование: страницы, для доступа к которым требуется более 4 кликов, индексируются на 57% реже, но добавление хлебных крошек увеличивает скорость индексации на 42%.

Проблемы карты сайта (26%) также критичны — карта сайта, не обновлявшаяся 30 дней, задерживает обнаружение новых страниц на 2–3 недели, а активная отправка карты сайта повышает индексирование на 29%.

① Изолированные страницы (41%)

② Глубина навигации (33%)

- Дистанция клика: Страницы, доступ к которым требует более 4 кликов, сканируются на 57% реже

- Оптимизация хлебных крошек: Добавление структурированных данных может ускорить индексирование глубоких страниц на 42%

③ Проблемы с картой сайта (26%)

- Задержка обновления: Sitemap, не обновлявшийся более 30 дней, задерживает обнаружение новых страниц на 2-3 недели

- Разница в охвате: Страницы, отправленные через sitemap вручную, индексируются на 29% чаще, чем обнаруженные естественным образом

Другие факторы (16%)

Оставшиеся 16% проблем включают недостаточный бюджет сканирования (39%) (только 35% страниц сайтов с более 50 000 страниц сканируются регулярно), песочницу для новых сайтов (31%) (индексирование страниц первых 3 месяцев нового домена медленнее на 4,8 дня) и ручные санкции (15%) (восстановление занимает 16-45 дней).

План оптимизации ясен: сжатие страниц с низкой ценностью может удвоить количество сканируемого важного контента, получение 3 качественных внешних ссылок может сократить период песочницы на 40%, а очистка токсичных ссылок (68% случаев санкций) ускоряет восстановление.

① Недостаточный бюджет сканирования (39%)

- Порог количества страниц: На сайтах с более 50 000 страниц регулярно сканируется только 35% страниц

- План оптимизации: Сжатие страниц с низкой ценностью может увеличить количество сканируемого важного контента в 2,1 раза

② Песочница для новых сайтов (31%)

- Продолжительность: Страницы первых 3 месяцев нового домена индексируются в среднем на 4,8 дня медленнее, чем на старых сайтах

- Метод ускорения: Получение более 3 качественных внешних ссылок может сократить период песочницы на 40%

③ Ручные санкции (15%)

- Цикл восстановления: После снятия ручной санкции требуется в среднем 16-45 дней для повторного индексирования

- Частые причины: Токсичные внешние ссылки (68% случаев санкций) и маскированный контент (22%)

Практические решения

Почему большинство “проблем с индексированием” легко решаются? Хотя причины, по которым Google не индексирует страницы, сложны, 73% случаев можно решить с помощью простых корректировок.

Данные показывают:

- Ручная отправка URL в Google Search Console (GSC) повышает успешность индексирования с 52% до 89%

- Оптимизация скорости загрузки (менее 2,3 секунд) повышает успешность сканирования на 62%

- Исправление внутренних ссылок (более 3 внутренних ссылок) повышает индексируемость изолированных страниц с 9% до 78%

- Обновление sitemap раз в неделю снижает риск пропуска на 15%

Ниже мы разберем конкретные действия.

Техническое исправление (решает 38% проблем с индексированием)

① Проверка и исправление robots.txt (27% случаев)

- Ошибка по умолчанию: 19% сайтов WordPress блокируют важные страницы

- Метод проверки: Просмотреть в GSC “Отчет о покрытии” для URL, заблокированных robots.txt

- Время исправления: 2-7 дней (цикл повторного сканирования Google)

- Ключевые действия:

- Использовать Google Robots.txt Tester для проверки

- Удалить ошибки, такие как

Disallow: /

② Оптимизация скорости загрузки страниц (23% случаев)

- Критический порог: Страницы, загружающиеся более 2,3 секунд, имеют +58% отказов сканирования

- Влияние мобильных устройств: Страницы с LCP >2,5 секунды снижают индексируемость на 34%

- План оптимизации:

- Сжатие изображений (уменьшение размера файла на 70%)

- Отложенная загрузка некритичного JS (увеличение скорости первого экрана на 40%)

- Использование CDN (сокращение времени TTFB на 30%)

③ Решение проблем каноникализации (18% случаев)

- Проблемы e-commerce сайтов: В среднем 1200 повторяющихся URL с параметрами

- Методы исправления:

- Добавить тег

rel="canonical"(снижение проблем с дублированием на 71%) - Настроить предпочитаемый домен в GSC (с www или без www)

- Добавить тег

Оптимизация контента (решает 29% проблем с индексированием)

① Увеличение длины контента (35% случаев)

- Влияние количества слов:

- <300 слов → 65% индексируемости

- 800+ слов → 92% индексируемости

- Различия по индустрии:

- Страницы продукта (среднее 280 слов) на 40% труднее индексировать, чем блоги (850 слов)

- Рекомендации по оптимизации:

- Расширить описание продукта до 500+ слов (увеличение индексируемости на 28%)

② Устранение дублирующегося контента (28% случаев)

- Порог схожести: Страницы с более 70% дублирующегося контента индексируются только на 15%

- Инструменты проверки:

- Copyscape (контроль схожести <30%)

- Решение:

- Объединить похожие страницы (снижение конфликтов индексирования)

③ Повышение качества контента (22% случаев)

- Влияние на поведение пользователей:

- Показатель отказов >75% → риск удаления в течение 6 месяцев +3 раза

- Время на странице <40 секунд → скорость повторного индексирования -62%

- Стратегии оптимизации:

- Добавить структурированные данные (увеличение CTR на 30%)

- Оптимизировать читаемость (Flesch Reading Score >60)

Корректировка структуры (решает 17% проблем с индексированием)

① Исправление изолированных страниц (41% случаев)

- Страницы без внутренних ссылок имеют только 9% вероятность обнаружения

- После оптимизации: добавление 3 внутренних ссылок → индексируемость 78%

- Рекомендации по действиям:

- Добавить анкоры в связанные статьи

② Оптимизация глубины навигации (33% случаев)

- Влияние дистанции клика:

- Страницы с более 4 кликов → частота сканирования -57%

- Решение:

- Навигация с хлебными крошками (ускоряет индексирование на 42%)

③ Обновление Sitemap (26% случаев)

- Частота обновления sitemap:

- Не обновлялся более 30 дней → новые страницы задерживаются на 2-3 недели

- Лучшие практики:

- Отправка еженедельно (снижение риска пропуска на 15%)

Другие ключевые оптимизации (16% случаев)

① Управление бюджетом сканирования (39% случаев)

- Проблемы крупных сайтов: только 35% страниц сайтов с более 50 000 страниц сканируются регулярно

- Методы оптимизации:

- Блокировка страниц низкой ценности (увеличение сканируемого важного контента в 2,1 раза)

② Сокращение периода песочницы (31% случаев)

- Время ожидания для новых сайтов: на 4,8 дня медленнее, чем у старых сайтов

- Метод ускорения:

- Получить 3 качественных внешних ссылки (сокращение периода песочницы на 40%)

③ Снятие ручных санкций (15% случаев)

- Цикл восстановления: 16-45 дней

- Основные причины:

- Токсичные внешние ссылки (68%)

- Маскированный контент (22%)

- Решение:

- Использовать Google Disavow Tool для очистки токсичных ссылок

Ожидаемые результаты

| Мера оптимизации | Время выполнения | Рост индексируемости |

|---|---|---|

| Исправить robots.txt | 1 час | +27% |

| Оптимизация скорости загрузки | 3-7 дней | +62% |

| Добавление внутренних ссылок | 2 часа | +69% |

| Обновление sitemap | 1 раз в неделю | +15% |