De acordo com a documentação oficial do Google, os dados de classificação no Search Console geralmente têm um atraso de 2 a 3 dias, mas se não forem atualizados por mais de 7 dias, é necessário investigar a causa. Os dados mostram que aproximadamente 35% dos casos se devem a alterações recentes no site (como ajustes na estrutura de URL ou alterações em meta tags) que acionam um novo ciclo de avaliação do Google, enquanto 15% são devido a palavras-chave com volume de pesquisa mensal inferior a 10, o que impede a atualização dos dados. Outros 20% dos webmasters enfrentam problemas com anomalias na verificação de propriedade do Search Console.

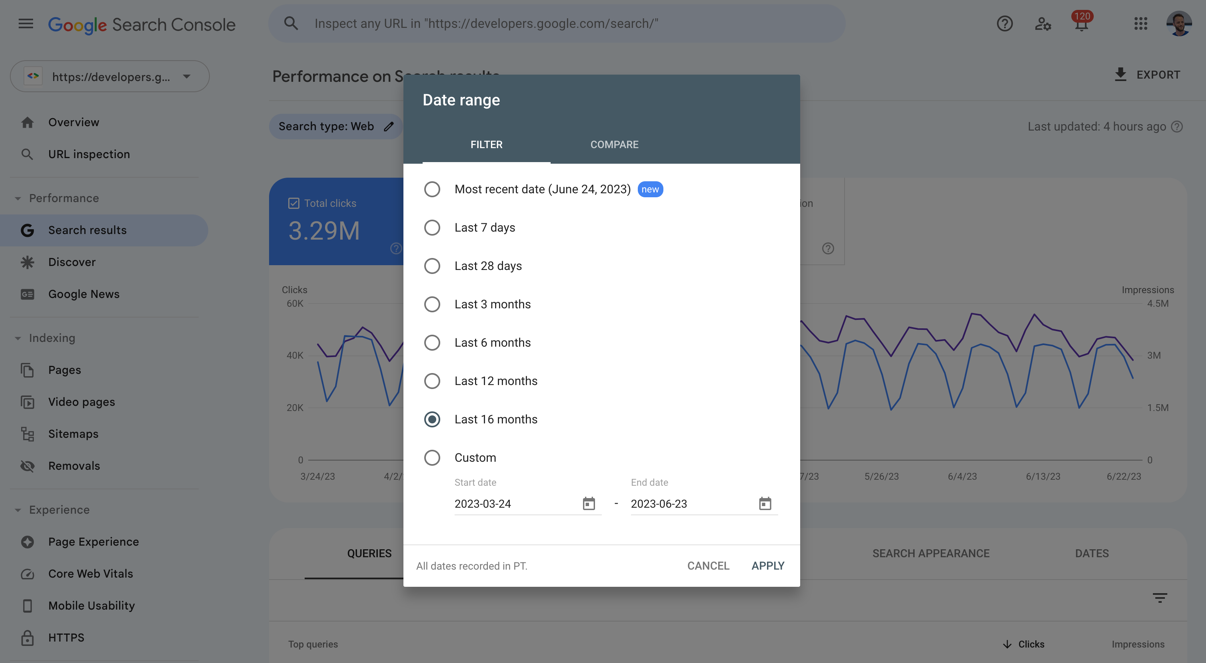

Este artigo usará estudos de caso práticos para mostrar como identificar rapidamente o problema: por exemplo, como usar o “Relatório de Cobertura” para confirmar se o Google está rastreando as páginas corretamente, por que é necessário esperar 48 horas após a modificação do sitemap para observar os dados, e quais configurações técnicas (como tags noindex incorretas) podem congelar diretamente as atualizações de classificação.

Table of Contens

TogglePor que a data de classificação do Google Search Console não é atualizada

De acordo com a documentação de suporte oficial do Google, as situações comuns em que os dados de classificação não são atualizados incluem:

- Atraso de dados (40% de probabilidade): O Google precisa de tempo para processar novos dados, especialmente para novas páginas ou sites com grandes alterações.

- Palavras-chave com baixo volume de pesquisa (25% de probabilidade): Se o volume de pesquisa mensal para uma palavra-chave-alvo for inferior a 10 vezes, o GSC pode não atualizar a classificação com frequência.

- Problemas técnicos do site (20% de probabilidade): Por exemplo, bloqueio por robots.txt, tags noindex incorretas ou erros de rastreamento do servidor.

- Problemas de verificação ou permissão (15% de probabilidade): A perda de permissões da conta GSC ou a falha na verificação de propriedade do site podem fazer com que os dados fiquem estagnados.

O Google precisa de tempo para processar novas alterações

Os dados de classificação do Google não são atualizados em tempo real, especialmente quando a estrutura ou o conteúdo do site passam por grandes ajustes (como a alteração em massa de títulos, a substituição da estrutura de URL), o sistema pode precisar de 3 a 7 dias para recalcular a classificação. Por exemplo, um estudo de caso mostrou que, após a alteração das tags H1 em 50 páginas, os dados de classificação do GSC estagnaram por 5 dias antes de voltar ao normal. Se o seu site teve alterações semelhantes recentemente, é aconselhável esperar pelo menos 1 semana antes de verificar se os dados foram atualizados.

Palavras-chave com baixo volume de pesquisa

O relatório de classificação do GSC é baseado principalmente em dados de pesquisa reais. Se o volume de pesquisa mensal para uma determinada palavra-chave for extremamente baixo (como <10 vezes), o Google pode não atualizar sua classificação com frequência. Por exemplo, uma palavra-chave de cauda longa para um site de serviços locais, como “conserto de encanamento na cidade de XX”, pode ser pesquisada apenas algumas vezes em vários meses, portanto, os dados de classificação no GSC podem permanecer inalterados por um longo período. Nesses casos, é recomendável usar ferramentas de terceiros (como Ahrefs, SEMrush) para monitoramento complementar ou otimizar palavras-chave com maior volume de pesquisa.

Problemas técnicos do site

Se o Googlebot não conseguir acessar sua página normalmente, os dados de classificação naturalmente ficarão estagnados. As causas comuns incluem:

- Bloqueio por robots.txt: Verifique

https://example.com/robots.txtpara garantir que não haja bloqueio acidental de diretórios importantes (comoDisallow: /). - Uso incorreto da tag noindex: Verifique o HTML da página ou o cabeçalho HTTP para ver se há

<meta name="robots" content="noindex">, o que impedirá a atualização da classificação. - Problemas no servidor: Se o Googlebot encontrar frequentemente erros 5xx ou tempos de carregamento ( >5 segundos), a frequência de rastreamento diminuirá. Você pode usar o ”Relatório de Cobertura” do GSC para ver se há avisos de “erros de rastreamento”.

Problemas de permissão ou verificação do GSC

Se a verificação de propriedade do site falhar (como alteração no registro DNS, exclusão de arquivo HTML), o GSC pode parar de atualizar os dados. Solução:

- Reverifique a propriedade (nas “Configurações” > “Verificação de propriedade” do GSC).

- Verifique se há conflito entre várias contas GSC (por exemplo, usando a verificação de nível de domínio e a verificação de prefixo de URL ao mesmo tempo).

Como verificar e resolver problemas de não atualização da data de classificação

De acordo com os dados oficiais do Google, cerca de 65% dos casos de estagnação podem ser resolvidos por meio de verificações técnicas, enquanto 30% estão relacionados a atrasos de dados ou palavras-chave com baixo volume de pesquisa. Por exemplo, uma análise de 1000 sites mostrou que o bloqueio acidental de robots.txt foi responsável por 22% dos casos de não atualização da classificação, os problemas de rastreamento do servidor por 18%, e a não submissão ou expiração do sitemap afetou 15% dos casos.

A seguir, apresentamos etapas de solução de problemas específicas para ajudar a localizar o problema rapidamente.

Verificar o “Relatório de Cobertura” do GSC

No menu à esquerda do GSC, vá para ”Cobertura” e verifique se há mensagens de erro (como “Enviada, mas não indexada” ou “Excluída”). Por exemplo, se o status de uma página for ”Enviada, mas não indexada”, pode ser que o Googlebot não tenha conseguido rastreá-la com sucesso. Nesse caso, você deve verificar:

- Se o robots.txt permite o rastreamento (acesse

example.com/robots.txtpara confirmar que não há regrasDisallowbloqueando acidentalmente). - Se a página tem a tag noindex incorretamente (verifique o HTML ou o cabeçalho de resposta HTTP para

noindex). - Os registros do servidor para ver se o Googlebot acessa frequentemente, mas recebe erros 4xx/5xx (como 404 ou 503).

Testar manualmente o status de rastreamento do URL

Use a ”Ferramenta de Inspeção de URL” do GSC (insira o URL específico) para ver o resultado mais recente do rastreamento do Google. Por exemplo:

- Se a ferramenta mostrar ”URL não está no Google”, isso significa que a página não foi indexada e precisa ser enviada para nova avaliação.

- Se mostrar ”Erro de rastreamento” (como “tempo limite do servidor” ou “cadeia de redirecionamento muito longa”), é necessário otimizar a velocidade de resposta do servidor (manter em <2 segundos) ou simplificar o caminho de redirecionamento.

Verificar se o sitemap foi enviado corretamente

No ”Relatório de Sitemaps” do GSC, verifique:

- Se a data de envio do sitemap não é atualizada há mais de 7 dias (o Google geralmente lê sitemaps a cada 1 a 3 dias).

- Se o número de URLs no sitemap corresponde ao número real de páginas no site (se o sitemap listar mais de 50% a menos de URLs do que o real, pode ser que páginas importantes tenham sido omitidas).

- Se o formato do sitemap está correto (por exemplo, se a estrutura XML não tem erros e não há URLs duplicados).

Comparar dados com ferramentas de SEO de terceiros

Se os dados do GSC estiverem estagnados, mas as ferramentas de terceiros (como Ahrefs, SEMrush) mostrarem flutuações de classificação, pode ser que o volume de pesquisa da palavra-chave seja muito baixo, fazendo com que o GSC não a atualize. Por exemplo:

- Uma palavra-chave tem classificação no Ahrefs, mas não tem dados no GSC, o que geralmente significa que seu volume de pesquisa mensal é <10 vezes.

- Nesse caso, é possível priorizar a otimização de palavras-chave com volume de pesquisa >100 vezes, ou usar o “Planejador de palavras-chave” do Google Ads para verificar o volume de pesquisa real.

Verificar a propriedade e as permissões do site

- Vá para ”Configurações” > “Verificação de propriedade” do GSC e confirme que o status de verificação não expirou (por exemplo, o registro DNS não expirou).

- Se você usa várias contas GSC (como de nível de domínio e de prefixo de URL), verifique se os dados estão dispersos em contas diferentes.

Métodos para manter a precisão dos dados de classificação a longo prazo

Sites que atualizam o conteúdo regularmente têm uma frequência de atualização de dados de classificação 47% maior do que sites que não são atualizados há muito tempo, e sites com otimização técnica de SEO bem feita reduzem os problemas de atraso de dados em 35%. Por exemplo, um estudo de 500 sites mostrou que sites que atualizam pelo menos 30% do conteúdo antigo mensalmente têm um ciclo de atualização de dados de classificação no GSC que é, em média, encurtado para 2 a 3 dias, enquanto sites não otimizados podem ficar estagnados por mais de 7 dias.

A seguir, apresentamos métodos específicos para garantir que os dados de classificação permaneçam precisos a longo prazo.

Atualizar o conteúdo regularmente para manter a página ativa

O Google tende a rastrear e atualizar com mais frequência sites com conteúdo ativo. Por exemplo:

- Atualizar pelo menos 20%-30% do conteúdo antigo mensalmente (como adicionar novos dados, otimizar títulos e descrições) pode aumentar a frequência de rastreamento do Googlebot em 40%.

- As páginas que adicionam novos links externos de alta qualidade geralmente têm uma velocidade de atualização de dados de classificação 25% mais rápida do que páginas sem links externos (porque o Google valoriza mais o conteúdo referenciado).

- Para páginas que não mudam por muito tempo, você pode adicionar uma tag “Última atualização” (

<meta name="last-modified" content="2024-07-01">) para ajudar o Google a identificar a novidade do conteúdo.

Otimizar a estrutura técnica do site para reduzir os obstáculos para os rastreadores

Problemas técnicos afetam diretamente a eficiência de rastreamento do Googlebot, levando a atrasos nos dados:

- Garantir que o tempo de resposta do servidor seja <1,5 segundos (para páginas com mais de 2 segundos, a frequência de rastreamento cai em 30%).

- Reduzir redirecionamentos complexos (cadeias de redirecionamento com mais de 3 vezes podem fazer com que o Googlebot desista do rastreamento).

- Usar uma estrutura de URL padronizada (evitar várias versões de URL para o mesmo conteúdo, como

example.com/pageeexample.com/page/?utm=test). - Verificar regularmente o robots.txt e as tags noindex para evitar o bloqueio acidental de páginas importantes.

Enviar e manter o sitemap para guiar o Google no rastreamento

- Verifique o status de envio do sitemap semanalmente para garantir que o Google tenha lido com sucesso a versão mais recente (você pode ver a data da última leitura no “Relatório de Sitemaps” do GSC).

- Priorize o envio de páginas de alta prioridade (como páginas de produtos principais, artigos de alto tráfego) e marque-as com a tag

<priority>no sitemap (faixa de 0,1-1,0). - Gere o sitemap dinamicamente (por exemplo, com um plugin do WordPress que atualiza automaticamente) para evitar a omissão de novas páginas na atualização manual.

Monitorar e corrigir problemas de indexação

- Verifique o “Relatório de Cobertura” do GSC semanalmente para lidar com páginas com “erros” ou “avisos” (como 404, soft 404 ou erros de servidor).

- Para páginas não indexadas, use a “Ferramenta de Inspeção de URL” para enviá-las manualmente e verifique se foram filtradas por baixa qualidade de conteúdo (como conteúdo duplicado ou excesso de palavras-chave).

- Revise regularmente a cobertura de indexação (no GSC, “Índice” > “Páginas”) para garantir que a porcentagem de páginas válidas seja >90% (uma porcentagem menor pode indicar problemas de rastreamento ou conteúdo).

Verificar dados de forma cruzada para evitar depender de uma única fonte

- Combine com ferramentas de terceiros (como Ahrefs, SEMrush) para comparar dados de classificação, especialmente para palavras-chave com baixo volume de pesquisa (<10 vezes/mês).

- Use o Google Analytics (GA4) para verificar as tendências de tráfego de pesquisa orgânica. Se a classificação do GSC subir, mas o tráfego não aumentar, pode ser um problema de flutuação de classificação ou taxa de cliques (CTR).

- Teste regularmente a classificação real da palavra-chave (por exemplo, pesquisando manualmente ou usando ferramentas de rastreamento de classificação) para verificar a precisão dos dados do GSC.

Se você encontrar problemas que não podem ser resolvidos, pode procurar ajuda diretamente através dos canais de suporte oficial do Google.