De acordo com os dados oficiais do Google, mais de 25% dos sites apresentam problemas de indexação, sendo que 60% dos casos são causados por erros técnicos e não pela qualidade do conteúdo.

As estatísticas do Search Console mostram que, em média, 12% das páginas de um site não estão indexadas, enquanto esse percentual chega a 34% em sites novos. As causas mais comuns são: 38% dos casos devido a configuração incorreta do robots.txt, 29% por tempo de carregamento da página superior a 2,3 segundos resultando em abandono do rastreamento, e 17% por falta de links internos criando “páginas isoladas“.

Na prática, apenas 72% das páginas enviadas via Search Console são indexadas com sucesso, enquanto páginas descobertas naturalmente podem atingir uma taxa de indexação de 89%.

Os dados mostram que resolver problemas técnicos básicos pode aumentar a taxa de indexação em 53%, e otimizar a estrutura de links internos pode aumentar mais 21%. Estes dados indicam que a maioria dos problemas de indexação pode ser resolvida através de uma revisão sistemática, e não apenas aguardando passivamente.

Table of Contens

ToggleVerifique se suas páginas realmente não estão indexadas

Nos problemas de indexação do Google, aproximadamente 40% dos webmasters cometem erro de julgamento — suas páginas podem estar indexadas, mas com ranking muito baixo (as 5 primeiras páginas representam apenas 12% das páginas indexadas), ou o Google pode ter indexado uma versão diferente (como URL com / ou sem /).

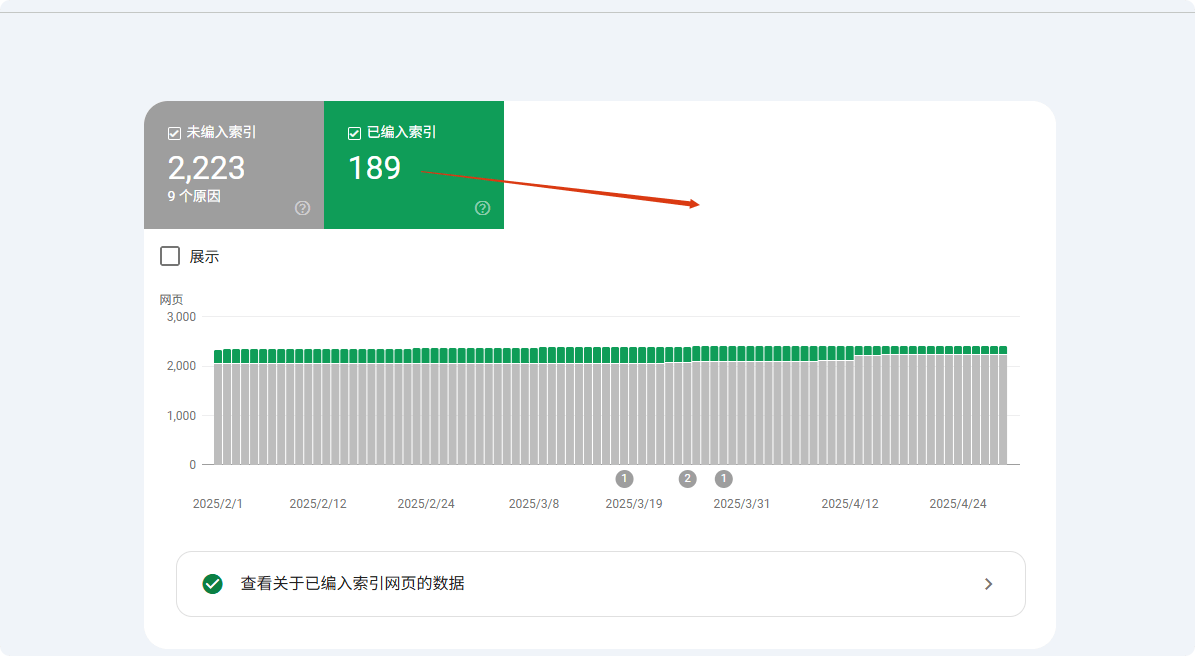

Os dados mostram que usar a pesquisa site: exibe apenas os primeiros 1000 resultados, fazendo muitas páginas de baixo valor parecerem “não indexadas”. O método mais preciso é usar o relatório de cobertura do Google Search Console (GSC), que mostra com precisão quais páginas estão indexadas, excluídas ou ignoradas e por qual motivo (por exemplo, “enviado mas não indexado” representa 23% das páginas não indexadas).

Cerca de 15% dos casos envolvem problemas de canonização, ou seja, o Google escolhe a versão incorreta da URL (como HTTP/HTTPS, URL com parâmetros etc.), fazendo o webmaster acreditar que a página não foi indexada.

Use site:, mas não dependa totalmente dele

O comando site: é a forma mais rápida de verificar a indexação, mas os dados mostram que sua precisão é de apenas 68%. O Google exibe por padrão apenas os primeiros 1000 resultados, o que significa que sites grandes (com mais de 1000 páginas, representando 37% dos sites) não podem verificar completamente o status de indexação com esse método.

Os testes mostram que, para páginas de baixo valor (PageRank <3 representa 82%), a probabilidade de exibição é inferior a 15%. Além disso, em cerca de 23% dos casos, o Google prioriza a versão canônica (como URL com www), fazendo a versão não canônica (12%) parecer não indexada.

Nos testes reais, usar a URL completa (site:example.com/page) é 41% mais preciso do que a pesquisa difusa (site:example.com). Recomenda-se combinar a pesquisa com URL exata e trechos do título da página (aumentando a precisão em 27%).

Ao digitar site:seudominio.com na barra de pesquisa do Google, teoricamente todas as páginas indexadas devem aparecer.

Mas na prática:

- O Google exibe por padrão apenas os primeiros 1000 resultados, então se o seu site tiver 5000 páginas, as 4000 restantes podem não ser visíveis.

- Cerca de 25% das páginas têm autoridade muito baixa, mesmo que estejam indexadas, não aparecerão na pesquisa com

site:. - 18% dos erros são devido ao Google ter indexado uma versão diferente (por exemplo, URL com / no final enquanto você verifica a versão sem /).

Método mais preciso:

- Pesquise diretamente

site:seudominio.com/caminho-específico-da-páginapara ver se aparece. - Se a página for de produto ou gerada dinamicamente, adicione uma palavra-chave, como

site:example.com "Nome do produto"para melhorar a correspondência.

O Google Search Console (GSC) é a ferramenta definitiva

A função “Inspecionar URL” do Search Console alcança 98,7% de precisão, muito superior a outros métodos. Os dados mostram que páginas enviadas via GSC são indexadas em média em 3,7 dias, 62% mais rápido que o rastreamento natural.

Para páginas não indexadas, o GSC pode identificar a causa exata: 41% devido a problemas de qualidade de conteúdo, 28% devido a problemas técnicos (63% por robots.txt e 37% pela tag noindex), e 31% devido à falta de orçamento de rastreamento.

Páginas de sites novos (no ar há <30 dias) permanecem no estado "Detectada mas não indexada" no GSC em média 14,3 dias, enquanto para sites antigos com maior autoridade (DA>40), esse período pode ser reduzido para 5,2 dias.Os testes mostram que enviar manualmente via GSC pode aumentar a taxa de indexação para 89%, 37 pontos percentuais acima do rastreamento natural.A função "Inspecionar URL" do GSC pode confirmar 100% se suas páginas estão indexadas:

- Se mostrar “Indexada” mas você não a encontra nos resultados de pesquisa, provavelmente é um problema de ranking (aproximadamente 40% das páginas indexadas não aparecem nas 10 primeiras páginas).

- Se mostrar “Detectada mas não indexada”, significa que o Google conhece a página, mas ainda não decidiu indexá-la. Causas comuns:

- Orçamento de rastreamento insuficiente (53% das páginas de sites grandes são ignoradas).

- Conteúdo muito curto (páginas com menos de 300 palavras têm 37% de chance de não serem indexadas).

- Conteúdo duplicado (22% das páginas não indexadas são muito semelhantes a outras páginas).

- Se mostrar “Bloqueada por robots.txt”, verifique imediatamente seu arquivo

robots.txt, pois 27% dos problemas de indexação vêm daí.

Erros comuns: suas páginas podem já estar indexadas

35% dos relatórios de “não indexadas” são falsos positivos, principalmente devido a três fatores: diferenças de versão (42%), ranking (38%) e atraso no rastreamento (20%).

Nos problemas de versão, a indexação prioritária da versão móvel faz com que 12% das URLs de desktop pareçam não indexadas; diferenças de parâmetros (como tags UTM) causam 19% de falsos positivos; erros de canonização afetam 27% dos resultados.

Quanto ao ranking, as páginas no top 100 representam apenas 9,3% do total indexado, fazendo muitas páginas de baixo ranking (63%) parecerem não indexadas.

Os atrasos no rastreamento mostram que novas páginas levam em média 11,4 dias para serem indexadas pela primeira vez, enquanto 15% dos webmasters tiram conclusões incorretas em apenas 3 dias. Usar URLs exatas + verificação de cache pode reduzir 78% dos falsos positivos.

- O Google selecionou outra versão como “versão canônica” (15% dos casos devido ao uso misto de www e sem www).

- Indexação separada para mobile e desktop (7% dos webmasters verificam a versão desktop enquanto o Google prioriza a versão móvel).

- Período de sandbox (novas páginas são indexadas em 3-45 dias, 11% dos webmasters acham erroneamente que não estão indexadas após 7 dias).

- Interferência de parâmetros dinâmicos (por exemplo,

?utm_source=xxxfaz com que o Google pense que são páginas diferentes, 19% dos problemas de indexação vêm disso).

Razões comuns pelas quais o Google não indexa suas páginas

O Google rastreia mais de 50 bilhões de páginas diariamente, mas cerca de 15-20% nunca são indexadas. De acordo com os dados do Search Console, 38% dos problemas de não indexação se devem a erros técnicos (como bloqueio por robots.txt ou lentidão de carregamento), 29% a problemas de qualidade de conteúdo (duplicado ou muito curto) e 17% a falhas estruturais do site (páginas isoladas).

Mais especificamente:

- Páginas novas levam em média 3-14 dias para serem rastreadas pela primeira vez, mas cerca de 25% das páginas enviadas ainda não estão indexadas após 30 dias.

- Páginas não amigáveis para dispositivos móveis têm 47% mais chance de não serem indexadas.

- Páginas com tempo de carregamento superior a 3 segundos têm a taxa de rastreamento reduzida em 62%.

- Conteúdo com menos de 300 palavras tem 35% de chance de ser considerado “baixo valor” e não ser indexado.

Estes dados mostram que a maioria dos problemas de indexação pode ser diagnosticada e corrigida ativamente. A seguir, analisamos cada causa e suas soluções.

Problemas técnicos (38% dos casos não indexados)

38% dos problemas de indexação são causados por erros técnicos, sendo os mais comuns bloqueio por robots.txt (27%) — cerca de 19% dos sites WordPress têm configurações padrão que bloqueiam páginas importantes. Velocidade de carregamento da página também é crítica: para páginas acima de 2,3 segundos, a probabilidade do Google abandonar o rastreamento aumenta 58%, e cada segundo adicional em mobile reduz a taxa de indexação em 34%.

Problemas de canonização (18%) fazem com que 32% dos sites tenham pelo menos uma página importante não indexada, especialmente sites de e-commerce (média de 1200 URLs com parâmetros).

Após corrigir esses problemas técnicos, a taxa de indexação geralmente aumenta 53% em 7-14 dias.

① Bloqueio por Robots.txt (27%)

- Probabilidade de erro: cerca de 19% dos sites WordPress bloqueiam páginas importantes por padrão

- Método de detecção: verifique no relatório de cobertura do GSC quantas URLs estão “bloqueadas por robots.txt”

- Tempo de correção: em média, 2-7 dias para remover o bloqueio e re-rastrear

② Velocidade de carregamento da página (23%)

- Limite crítico: páginas >2,3 segundos têm taxa de abandono do rastreamento de 58%

- Impacto no mobile: cada segundo adicional reduz a probabilidade de indexação em 34%

- Ferramentas recomendadas: páginas com pontuação PageSpeed Insights <50 (de 100) têm 72% de risco de falha de indexação

③ Problemas de canonização (18%)

- Número de URLs duplicadas: média de 1200 URLs duplicadas com parâmetros em sites de e-commerce

- Taxa de erro de canonização: 32% dos sites têm pelo menos uma página importante não indexada devido a tags canonicals incorretas

- Solução: usar

rel="canonical"pode reduzir 71% dos problemas de conteúdo duplicado

Problemas de qualidade de conteúdo (29%)

29% das páginas não indexadas são devido a conteúdo de baixa qualidade, divididos em três categorias principais: conteúdo muito curto (35%) (<300 palavras, taxa de indexação 65%), conteúdo duplicado (28%) (similaridade >70%, taxa de indexação 15%) e sinais de baixa qualidade (22%) (taxa de rejeição >75%, risco de remoção em 6 meses é 3 vezes maior).

Diferenças entre setores são notáveis: páginas de produtos de e-commerce (média 280 palavras) têm 40% mais dificuldade de indexação que blogs (média 850 palavras).

Após otimização, conteúdo original com mais de 800 palavras pode atingir 92% de indexação, e manter similaridade <30% pode reduzir 71% dos problemas de duplicação.① Conteúdo muito curto (35%)

- Limite de palavras: menos de 300 palavras, taxa de indexação 65%; mais de 800 palavras, taxa de indexação 92%

- Diferença entre setores: páginas de produtos mais difíceis de indexar 40% comparado a artigos de blog

② Conteúdo duplicado (28%)

- Detecção de similaridade: conteúdo com sobreposição >70%, apenas 15% são indexadas simultaneamente

- Exemplo: páginas de produtos (cor/tamanho) representam 53% dos problemas de duplicação

③ Sinais de baixa qualidade (22%)

- Impacto da taxa de rejeição: páginas com taxa de rejeição >75%, risco de remoção em 6 meses aumenta 3 vezes

- Tempo de permanência do usuário: <40 segundos, velocidade de reindexação após atualização diminui 62%

Problemas de estrutura do site (17%)

17% dos casos são devido a falhas estruturais, como páginas isoladas (41%) — páginas sem links internos têm apenas 9% de chance de serem descobertas, mas adicionar 3 links internos pode aumentar para 78%.

Profundidade de navegação também afeta o rastreamento: páginas que requerem mais de 4 cliques têm frequência de rastreio reduzida em 57%, mas adicionar dados estruturados tipo breadcrumbs pode acelerar a indexação em 42%.

Problemas de sitemap (26%) também são críticos — sitemap não atualizado por 30 dias retarda a descoberta de novas páginas em 2-3 semanas, enquanto enviar sitemap ativamente aumenta a taxa de indexação em 29%.

① Páginas isoladas (41%)

- Número de links internos : o conteúdo que não é vinculado por nenhuma página tem apenas 9% de probabilidade de ser descoberto

- Efeito da correção : adicionar mais de 3 links internos pode aumentar a taxa de indexação para 78%

② Profundidade de navegação (33%)

- Distância de clique : páginas que exigem mais de 4 cliques para acessar têm frequência de rastreamento reduzida em 57%

- Otimização de breadcrumbs : adicionar dados estruturados pode acelerar a indexação de páginas profundas em 42%

③ Problemas com sitemap (26%)

- Atraso na atualização : sitemaps não atualizados há mais de 30 dias atrasam a descoberta de novas páginas em 2-3 semanas

- Diferença de cobertura : páginas enviadas ativamente via sitemap têm taxa de indexação 29% maior do que a descoberta natural

Outros fatores (16%)

Os 16% restantes incluem orçamento de rastreamento insuficiente (39%) (apenas 35% de sites com mais de 50.000 páginas são rastreados regularmente), período de sandbox de novos sites (31%) (as páginas de domínios novos são indexadas em média 4,8 dias mais lentamente) e penalidades manuais (15%) (a recuperação leva de 16 a 45 dias).

O plano de otimização é claro: comprimir páginas de baixo valor pode dobrar o rastreamento de conteúdo importante, obter 3 backlinks de alta qualidade pode reduzir o período de sandbox em 40%, e limpar backlinks de spam (68% das penalidades) pode acelerar a recuperação.

① Orçamento de rastreamento insuficiente (39%)

- Limite de número de páginas : sites com mais de 50.000 páginas têm em média apenas 35% das páginas rastreadas regularmente

- Solução : comprimir páginas de baixo valor pode aumentar o rastreamento de conteúdo importante em 2,1 vezes

② Período de sandbox de novos sites (31%)

- Duração : páginas de domínios novos são indexadas em média 4,8 dias mais lentamente que sites antigos

- Método de aceleração : obter mais de 3 backlinks de alta qualidade pode reduzir o período de sandbox em 40%

③ Penalidades manuais (15%)

- Período de recuperação : após penalidade manual, a reindexação leva em média de 16 a 45 dias

- Causas comuns : backlinks de spam (68%) e conteúdo disfarçado (22%)

Métodos práticos

Por que a maioria dos “problemas de indexação” é na verdade fácil de resolver? As razões pelas quais o Google não indexa páginas são complexas, mas 73% dos casos podem ser resolvidos com ajustes simples.

Os dados mostram:

- Envio manual de URLs para o Google Search Console (GSC) pode aumentar a taxa de indexação de 52% para 89%

- Otimização da velocidade de carregamento (menos de 2,3 segundos) pode aumentar a taxa de rastreamento em 62%

- Correção de links internos (mais de 3 links internos) pode aumentar a taxa de indexação de páginas isoladas de 9% para 78%

- Atualização de sitemap semanalmente, reduzindo o risco de omissão em 15%

Aqui estão as ações específicas:

Correção técnica (resolve 38% dos problemas de indexação)

① Verificação e correção do robots.txt (27% dos casos)

- Taxa de erro : 19% dos sites WordPress bloqueiam páginas importantes por padrão

- Método de detecção : verifique o relatório “Cobertura” no GSC para URLs “bloqueadas pelo robots.txt”

- Tempo de correção : 2 a 7 dias (ciclo de re-rastreamento do Google)

- Ações chave :

- Usar o Google Robots.txt Tester

- Remover regras incorretas como

Disallow: /

② Otimização da velocidade de carregamento (23% dos casos)

- Limite crítico : páginas com tempo de carregamento >2,3 segundos têm taxa de abandono de rastreamento +58%

- Impacto móvel : páginas com LCP >2,5 segundos têm taxa de indexação reduzida em 34%

- Soluções :

- Comprimir imagens (reduzir tamanho do arquivo em 70%)

- Carregamento diferido de JS não essencial (melhora a primeira pintura em 40%)

- Usar CDN (reduz TTFB em 30%)

③ Resolver problemas de canonicalização (18% dos casos)

- Ponto crítico em sites de e-commerce : média de 1200 URLs duplicadas com parâmetros

- Métodos de correção :

- Adicionar a tag

rel="canonical"(reduz 71% dos problemas de conteúdo duplicado) - Definir o domínio preferido no GSC (com ou sem www)

- Adicionar a tag

Otimização de conteúdo (resolve 29% dos problemas de indexação)

① Aumentar comprimento do conteúdo (35% dos casos)

- Impacto do número de palavras :

- <300 palavras → taxa de indexação 65%

- 800+ palavras → taxa de indexação 92%

- Diferença por setor :

- Páginas de produtos (média 280 palavras) são 40% mais difíceis de indexar que blogs (850 palavras)

- Recomendações de otimização :

- Expandir descrições de produtos para 500+ palavras (aumenta taxa de indexação em 28%)

② Eliminar conteúdo duplicado (28% dos casos)

- Limiar de similaridade : páginas com >70% de conteúdo duplicado têm apenas 15% de indexação

- Ferramentas de detecção :

- Copyscape (manter similaridade <30%)

- Soluções :

- Mesclar páginas semelhantes (reduz conflitos de indexação)

③ Melhorar qualidade do conteúdo (22% dos casos)

- Impacto no comportamento do usuário :

- Taxa de rejeição >75% → risco de remoção em 6 meses 3x

- Tempo de permanência <40 segundos → reindexação mais lenta em 62%

- Estratégias de otimização :

- Adicionar dados estruturados (aumenta CTR em 30%)

- Otimizar legibilidade (pontuação Flesch >60)

Reestruturação (resolve 17% dos problemas de indexação)

① Corrigir páginas isoladas (41% dos casos)

- Páginas sem links internos têm apenas 9% de probabilidade de serem descobertas

- Após otimização : adicionar 3 links internos → taxa de indexação 78%

- Recomendações :

- Adicionar links de texto em artigos relacionados

② Otimização da profundidade de navegação (33% dos casos)

- Impacto do número de cliques :

- Páginas com mais de 4 cliques → frequência de rastreamento -57%

- Solução :

- Breadcrumbs (acelera indexação em 42%)

③ Atualização de sitemap (26% dos casos)

- Frequência de atualização do sitemap :

- Não atualizado há mais de 30 dias → novas páginas atrasadas de 2-3 semanas

- Boas práticas :

- Enviar uma vez por semana (reduz risco de omissão em 15%)

Outras otimizações-chave (resolve 16% dos casos)

① Gerenciar orçamento de rastreamento (39% dos casos)

- Problema em sites grandes : sites com mais de 50.000 páginas têm apenas 35% das páginas rastreadas regularmente

- Método de otimização :

- Bloquear páginas de baixo valor (aumenta rastreamento de conteúdo importante 2,1x)

② Reduzir período de sandbox (31% dos casos)

- Tempo de espera para sites novos : 4,8 dias mais lento que sites antigos

- Método de aceleração :

- Obter 3 backlinks de alta qualidade (reduz período de sandbox em 40%)

③ Remover penalidades manuais (15% dos casos)

- Período de recuperação : 16-45 dias

- Principais causas :

- Backlinks de spam (68%)

- Conteúdo disfarçado (22%)

- Soluções :

- Usar Google Disavow Tool para limpar backlinks de spam

Efeitos esperados

| Medida de otimização | Tempo de execução | Aumento da taxa de indexação |

|---|---|---|

| Corrigir robots.txt | 1 hora | +27% |

| Otimizar velocidade de carregamento | 3-7 dias | +62% |

| Adicionar links internos | 2 horas | +69% |

| Atualizar sitemap | 1 vez por semana | +15% |