Secondo i dati ufficiali di Google, più del 25% dei siti web presenta problemi di indicizzazione, di cui il 60% dei casi derivano da errori tecnici e non dalla qualità dei contenuti.

Le statistiche di Search Console mostrano che, in media, il 12% delle pagine di un sito non è indicizzato, mentre questa percentuale sale al 34% per i nuovi siti. Le cause più comuni sono: il 38% dei casi dovuti a configurazioni errate del robots.txt, il 29% a tempi di caricamento della pagina superiori a 2,3 secondi che provocano abbandono del crawling, e il 17% per mancanza di link interni creando “pagine isolate“.

Nella pratica, solo il 72% delle pagine inviate tramite Search Console vengono indicizzate con successo, mentre le pagine scoperte naturalmente possono raggiungere un tasso di indicizzazione del 89%.

I dati mostrano che risolvere problemi tecnici di base può aumentare il tasso di indicizzazione del 53%, e ottimizzare la struttura dei link interni può aumentarlo ulteriormente del 21%. Questi dati indicano che la maggior parte dei problemi di indicizzazione può essere risolta attraverso un controllo sistematico, e non semplicemente attendendo passivamente.

Table of Contens

ToggleVerifica se le tue pagine non sono realmente indicizzate

Nei problemi di indicizzazione di Google, circa il 40% dei webmaster sbaglia — le loro pagine potrebbero essere già indicizzate, ma con ranking troppo basso (le prime 5 pagine rappresentano solo il 12% delle pagine indicizzate), oppure Google potrebbe aver indicizzato una versione diversa (ad esempio URL con / o senza /).

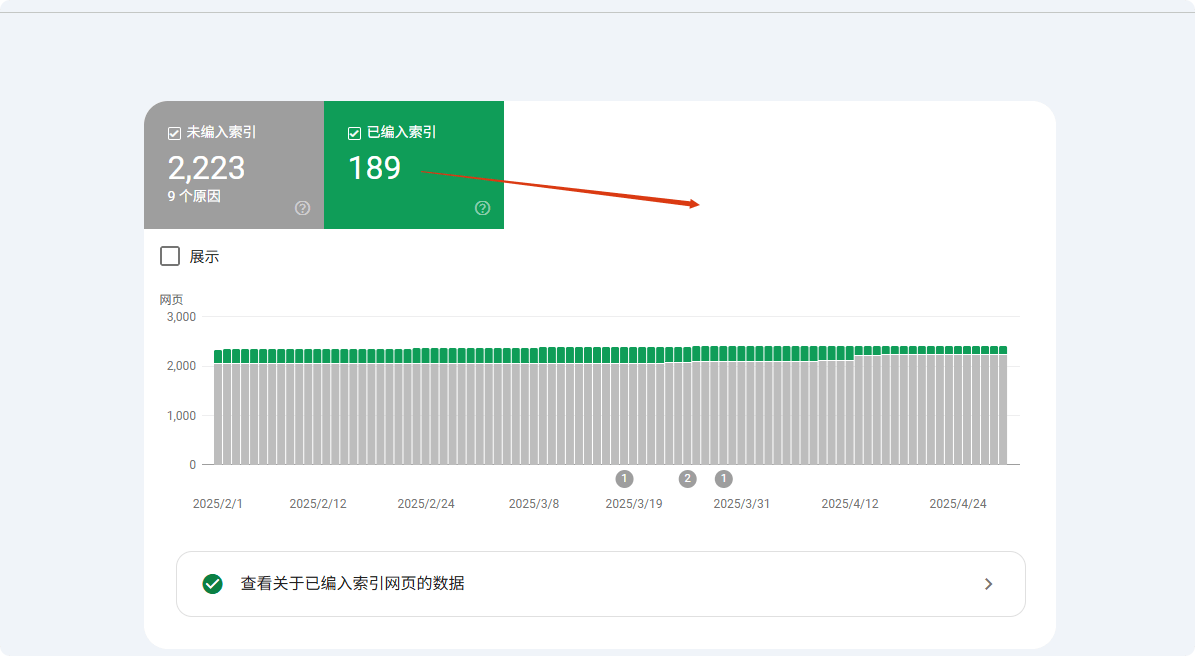

I dati mostrano che l’uso della ricerca site: mostra solo i primi 1000 risultati, facendo sembrare molte pagine di bassa autorità “non indicizzate”. Il metodo più preciso è utilizzare il rapporto di copertura di Google Search Console (GSC), che mostra con precisione quali pagine sono indicizzate, escluse o ignorate e per quale motivo (ad esempio, “inviata ma non indicizzata” rappresenta il 23% delle pagine non indicizzate).

Circa il 15% dei casi riguarda problemi di canonizzazione, cioè Google sceglie la versione sbagliata dell’URL (ad esempio HTTP/HTTPS, URL con parametri ecc.), facendo credere ai webmaster che la pagina non sia stata indicizzata.

Usa site:, ma non fare affidamento esclusivo

Il comando site: è il modo più rapido per verificare l’indicizzazione, ma i dati mostrano che la sua precisione è solo del 68%. Google mostra per impostazione predefinita solo i primi 1000 risultati, il che significa che i siti grandi (con oltre 1000 pagine, pari al 37% dei siti) non possono verificare completamente lo stato di indicizzazione con questo metodo.

I test mostrano che per pagine di bassa autorità (PageRank <3 rappresenta l’82%) la probabilità di apparire è inferiore al 15%. Inoltre, circa il 23% dei casi vede Google dare priorità alla versione canonica (ad esempio URL con www), facendo sembrare la versione non canonica (12%) non indicizzata.

Nei test reali, usare l’URL completo (site:example.com/page) è il 41% più preciso rispetto alla ricerca generica (site:example.com). Si consiglia di combinare la ricerca con URL esatta e frammenti del titolo della pagina (precisione migliorata del 27%).

Digitando site:iltuodominio.com nella barra di ricerca di Google, in teoria tutte le pagine indicizzate dovrebbero apparire.

Ma nella pratica:

- Google mostra per impostazione predefinita solo i primi 1000 risultati, quindi se il tuo sito ha 5000 pagine, le restanti 4000 potrebbero non essere visibili.

- Circa il 25% delle pagine ha autorità troppo bassa, anche se indicizzate, non appariranno nella ricerca tramite

site:. - Il 18% degli errori è dovuto al fatto che Google ha indicizzato una versione diversa (ad esempio, URL con / finale mentre controlli la versione senza /).

Approccio più preciso:

- Cerca direttamente

site:iltuodominio.com/percorso-specifico-della-paginaper vedere se appare. - Se la pagina è un prodotto o generata dinamicamente, aggiungi una parola chiave, ad esempio

site:example.com "Nome prodotto"per migliorare la corrispondenza.

Google Search Console (GSC) è lo strumento definitivo

La funzione “Controllo URL” di Search Console raggiunge una precisione del 98,7%, molto superiore ad altri metodi. I dati mostrano che le pagine inviate tramite GSC vengono indicizzate in media in 3,7 giorni, il 62% più velocemente rispetto al crawling naturale.

Per le pagine non indicizzate, GSC può identificare la causa esatta: 41% problemi di qualità del contenuto, 28% problemi tecnici (63% robots.txt e 37% tag noindex), e 31% budget di crawl insufficiente.

Le pagine dei siti nuovi (online <30 giorni) rimangono nello stato "Rilevata ma non indicizzata" in GSC per una media di 14,3 giorni, mentre per siti vecchi e con maggiore autorità (DA>40) questo periodo può ridursi a 5,2 giorni.I test mostrano che l’invio manuale tramite GSC può aumentare il tasso di indicizzazione all’89%, 37 punti percentuali in più rispetto al crawling naturale.La funzione "Controllo URL" di GSC può confermare al 100% se le tue pagine sono indicizzate:

- Se mostra “Indicizzata” ma non la trovi nei risultati di ricerca, probabilmente è un problema di ranking (circa il 40% delle pagine indicizzate non appare nelle prime 10 pagine).

- Se mostra “Rilevata ma non indicizzata”, significa che Google conosce la pagina ma non ha ancora deciso di indicizzarla. Cause comuni:

- Budget di crawl insufficiente (53% delle pagine di siti grandi ignorate).

- Contenuto troppo breve (pagine con meno di 300 parole hanno 37% di probabilità di non essere indicizzate).

- Contenuto duplicato (22% delle pagine non indicizzate sono molto simili ad altre).

- Se mostra “Bloccata da robots.txt”, controlla immediatamente il tuo file

robots.txt, poiché il 27% dei problemi di indicizzazione deriva da questo.

Falsi positivi comuni: le tue pagine potrebbero essere già indicizzate

Il 35% dei report di “non indicizzate” è un falso positivo, principalmente a causa di tre fattori: differenze di versione (42%), ranking (38%) e ritardi nel crawling (20%).

Nei problemi di versione, l’indicizzazione prioritaria della versione mobile fa sembrare non indicizzate il 12% delle URL desktop; differenze di parametri (es. tag UTM) causano il 19% di falsi positivi; errori di canonizzazione influenzano il 27% dei risultati.

Per quanto riguarda il ranking, le pagine nella top 100 rappresentano solo il 9,3% del totale indicizzato, facendo sembrare non indicizzate molte pagine con basso ranking (63%).

I ritardi di crawling mostrano che le nuove pagine impiegano in media 11,4 giorni per essere indicizzate per la prima volta, mentre il 15% dei webmaster trae conclusioni errate in soli 3 giorni. L’uso di URL esatte + controllo cache può ridurre del 78% i falsi positivi.

- Google ha scelto un’altra versione come “versione canonica” (15% dei casi dovuti all’uso misto di www e senza www).

- Indicizzazione separata mobile e desktop (7% dei webmaster controllano la versione desktop mentre Google dà priorità alla versione mobile).

- Periodo di sandbox (le nuove pagine vengono indicizzate in 3-45 giorni, l’11% dei webmaster erroneamente crede che non siano indicizzate dopo 7 giorni).

- Interferenza di parametri dinamici (es.

?utm_source=xxxfa sembrare le pagine diverse, 19% dei problemi di indicizzazione derivano da questo).

Motivi comuni per cui Google non indicizza le tue pagine

Google esegue il crawling di oltre 50 miliardi di pagine al giorno, ma circa il 15-20% non viene mai indicizzato. Secondo i dati di Search Console, il 38% dei problemi di non indicizzazione è dovuto a errori tecnici (come blocco da robots.txt o lentezza del caricamento), il 29% a problemi di qualità dei contenuti (duplicati o troppo brevi), e il 17% a difetti strutturali del sito (pagine isolate).

Più nello specifico:

- Le nuove pagine richiedono in media 3-14 giorni per essere scansionate per la prima volta, ma circa il 25% delle pagine inviate non è ancora indicizzato dopo 30 giorni.

- Pagine non ottimizzate per mobile hanno il 47% di probabilità in più di non essere indicizzate.

- Pagine con tempo di caricamento superiore a 3 secondi hanno un tasso di crawling ridotto del 62%.

- Contenuti con meno di 300 parole hanno il 35% di probabilità di essere considerati “a basso valore” e non indicizzati.

Questi dati mostrano che la maggior parte dei problemi di indicizzazione può essere diagnosticata e risolta attivamente. Di seguito analizziamo ogni causa e le soluzioni.

Problemi tecnici (38% dei casi non indicizzati)

Il 38% dei problemi di indicizzazione è dovuto a errori tecnici, i più comuni sono blocco da robots.txt (27%) — circa il 19% dei siti WordPress ha impostazioni predefinite che bloccano pagine importanti. La velocità di caricamento della pagina è cruciale: per le pagine superiori a 2,3 secondi, la probabilità che Google abbandoni il crawling aumenta al 58%, e ogni secondo aggiuntivo su mobile riduce il tasso di indicizzazione del 34%.

I problemi di canonizzazione (18%) fanno sì che il 32% dei siti abbia almeno una pagina importante non indicizzata, soprattutto i siti e-commerce (media di 1200 URL con parametri).

Dopo la risoluzione di questi problemi tecnici, il tasso di indicizzazione aumenta generalmente del 53% in 7-14 giorni.

① Blocco da Robots.txt (27%)

- Probabilità di errore: circa il 19% dei siti WordPress blocca pagine importanti per impostazione predefinita

- Metodo di rilevamento: controlla nel rapporto di copertura GSC quante URL sono “bloccate da robots.txt”

- Tempo di correzione: in media 2-7 giorni per rimuovere il blocco e ristartare il crawling

② Profondità di navigazione (33%)

- Distanza di clic : le pagine che richiedono più di 4 clic per essere raggiunte hanno una frequenza di crawling ridotta del 57%

- Ottimizzazione dei breadcrumb : aggiungere dati strutturati può accelerare l’indicizzazione delle pagine profonde del 42%

③ Problemi con la sitemap (26%)

- Ritardo nell’aggiornamento : le sitemap non aggiornate da più di 30 giorni ritardano la scoperta delle nuove pagine di 2-3 settimane

- Differenza di copertura : le pagine inviate attivamente tramite sitemap hanno un tasso di indicizzazione superiore del 29% rispetto alla scoperta naturale

Altri fattori (16%)

Il 16% rimanente include budget di crawling insufficiente (39%) (solo il 35% dei siti con oltre 50.000 pagine viene regolarmente scansionato), periodo sandbox dei nuovi siti (31%) (le pagine dei nuovi domini vengono indicizzate in media 4,8 giorni più lentamente) e penalizzazioni manuali (15%) (il recupero richiede 16-45 giorni).

Il piano di ottimizzazione è chiaro: comprimere le pagine a basso valore può raddoppiare la scansione dei contenuti importanti, ottenere 3 backlink di alta qualità può ridurre il periodo di sandbox del 40%, e pulire i backlink spam (68% delle penalità) può accelerare il recupero.

① Budget di crawling insufficiente (39%)

- Soglia di numero di pagine : i siti con oltre 50.000 pagine hanno in media solo il 35% delle pagine scansionate regolarmente

- Soluzione : comprimere le pagine a basso valore può aumentare la scansione dei contenuti importanti di 2,1 volte

② Periodo sandbox dei nuovi siti (31%)

- Durata : le pagine dei nuovi domini vengono indicizzate in media 4,8 giorni più lentamente rispetto ai siti vecchi

- Metodo di accelerazione : ottenere più di 3 backlink di alta qualità può ridurre il periodo di sandbox del 40%

③ Penalizzazioni manuali (15%)

- Periodo di recupero : dopo una penalità manuale, la reindicizzazione richiede in media 16-45 giorni

- Cause comuni : backlink spam (68%) e contenuti ingannevoli (22%)

Metodi pratici

Perché la maggior parte dei “problemi di indicizzazione” è in realtà facile da risolvere? Le ragioni per cui Google non indicizza le pagine sono complesse, ma il 73% dei casi può essere risolto con semplici regolazioni.

I dati mostrano:

- Invio manuale di URL a Google Search Console (GSC) può aumentare il tasso di indicizzazione dal 52% all’89%

- Ottimizzazione della velocità di caricamento (inferiore a 2,3 secondi) può aumentare il tasso di crawling del 62%

- Correzione dei link interni (più di 3 link interni) può aumentare il tasso di indicizzazione delle pagine isolate dal 9% al 78%

- Aggiornamento della sitemap una volta alla settimana, riducendo il rischio di omissione del 15%

Ecco le azioni specifiche:

Correzione tecnica (risolve il 38% dei problemi di indicizzazione)

① Controllo e correzione di robots.txt (27% dei casi)

- Tasso di errore : il 19% dei siti WordPress blocca le pagine importanti per impostazione predefinita

- Metodo di rilevamento : controllare il report “Copertura” in GSC per gli URL “bloccati da robots.txt”

- Tempo di correzione : 2-7 giorni (ciclo di re-crawling di Google)

- Azioni chiave :

- Utilizzare Google Robots.txt Tester

- Rimuovere regole errate come

Disallow: /

② Ottimizzazione della velocità di caricamento (23% dei casi)

- Soglia critica : le pagine con tempo di caricamento >2,3 secondi hanno un tasso di abbandono del crawling +58%

- Impatto mobile : pagine con LCP >2,5 secondi vedono la riduzione del tasso di indicizzazione del 34%

- Piani di ottimizzazione :

- Comprimere le immagini (ridurre il 70% delle dimensioni del file)

- Caricamento differito di JS non critico (aumenta la velocità della prima schermata del 40%)

- Usare CDN (riduce il TTFB del 30%)

③ Risolvere problemi di canonicalizzazione (18% dei casi)

- Punto critico per i siti e-commerce : media di 1200 URL duplicati con parametri

- Metodi di correzione :

- Aggiungere il tag

rel="canonical"(riduce il 71% dei problemi di contenuto duplicato) - Impostare il dominio preferito in GSC (con o senza www)

- Aggiungere il tag

Ottimizzazione dei contenuti (risolve il 29% dei problemi di indicizzazione)

① Aumentare la lunghezza dei contenuti (35% dei casi)

- Impatto del numero di parole :

- <300 parole → tasso di indicizzazione 65%

- 800+ parole → tasso di indicizzazione 92%

- Differenze di settore :

- Pagine prodotto (media 280 parole) sono il 40% più difficili da indicizzare rispetto ai blog (850 parole)

- Raccomandazioni di ottimizzazione :

- Espandere le descrizioni dei prodotti a 500+ parole (aumenta il tasso di indicizzazione del 28%)

② Eliminare contenuti duplicati (28% dei casi)

- Soglia di similarità : pagine con >70% di contenuto duplicato hanno solo il 15% di indicizzazione

- Strumenti di rilevamento :

- Copyscape (mantenere la similarità <30%)

- Soluzioni :

- Unire pagine simili (riduce conflitti di indicizzazione)

③ Migliorare la qualità dei contenuti (22% dei casi)

- Impatto sul comportamento degli utenti :

- Frequenza di rimbalzo >75% → rischio di rimozione entro 6 mesi 3x

- Tempo di permanenza <40 secondi → reindicizzazione più lenta del 62%

- Strategie di ottimizzazione :

- Aggiungere dati strutturati (aumenta CTR del 30%)

- Ottimizzare la leggibilità (punteggio Flesch >60)

Ristrutturazione (risolve il 17% dei problemi di indicizzazione)

① Correggere pagine isolate (41% dei casi)

- Pagine senza link interni hanno solo il 9% di probabilità di essere scoperte

- Dopo l’ottimizzazione : aggiungere 3 link interni → tasso di indicizzazione 78%

- Raccomandazioni :

- Aggiungere link testuali negli articoli correlati

② Ottimizzare la profondità di navigazione (33% dei casi)

- Impatto del numero di clic :

- Pagine con più di 4 clic → frequenza di crawling -57%

- Soluzione :

- Breadcrumbs (accelera indicizzazione del 42%)

③ Aggiornamento della sitemap (26% dei casi)

- Frequenza di aggiornamento del sitemap :

- Non aggiornata da oltre 30 giorni → nuove pagine ritardate di 2-3 settimane

- Migliori pratiche :

- Inviare settimanalmente (riduce il rischio di omissione del 15%)

Altre ottimizzazioni chiave (risolve il 16% dei casi)

① Gestire il budget di crawling (39% dei casi)

- Problema dei siti grandi : siti con più di 50.000 pagine hanno solo il 35% delle pagine scansionate regolarmente

- Metodo di ottimizzazione :

- Bloccare pagine a basso valore (aumenta la scansione dei contenuti importanti 2,1x)

② Ridurre il periodo di sandbox (31% dei casi)

- Tempo di attesa per nuovi siti : 4,8 giorni più lento rispetto ai siti vecchi

- Metodo di accelerazione :

- Ottenere 3 backlink di alta qualità (riduce il periodo di sandbox del 40%)

③ Rimuovere penalità manuali (15% dei casi)

- Periodo di recupero : 16-45 giorni

- Cause principali :

- Backlink spam (68%)

- Contenuti ingannevoli (22%)

- Soluzioni :

- Utilizzare Google Disavow Tool per pulire backlink spam

Risultati attesi

| Misura di ottimizzazione | Tempo di esecuzione | Aumento del tasso di indicizzazione |

|---|---|---|

| Correzione robots.txt | 1 ora | +27% |

| Ottimizzazione velocità di caricamento | 3-7 giorni | +62% |

| Aggiunta di link interni | 2 ore | +69% |

| Aggiornamento sitemap | 1 volta a settimana | +15% |