Las Tres Razones Principales por las que Google No Indexa URLs:

- 62% debido a baja calidad del contenido (Ahrefs 2024)

- Período Sandbox de sitios nuevos retrasa la indexación un promedio de 28 días (SEMrush)

- Las páginas sin enlaces externos tardan 114 días en ser indexadas (Moz)

Según datos de Google Search Console, aproximadamente el 35% de las páginas nuevas no se indexan dentro de los 30 días posteriores a su envío, y el ciclo de indexación promedio para sitios web pequeños a medianos es de hasta 2-4 semanas.

El 62% de las páginas no indexadas tienen problemas de calidad de contenido (Fuente: Informe de Indexación de Sitios Web Ahrefs 2024). El rastreador de Google procesa más de 5 mil millones de páginas al día, pero prioriza el rastreo de páginas con contenido completo, una velocidad de carga más rápida que 1.5 segundos y un tema claro.

Los experimentos demuestran que las páginas nuevas sin enlaces externos tienen un 73% menos de posibilidades de ser indexadas (Estudio de Comportamiento del Rastreador Moz 2024), y el 15% de las páginas en sitios que utilizan WordPress no pueden ser rastreadas correctamente debido a problemas técnicos.

Table of Contens

ToggleBaja Calidad del Contenido

Según datos oficiales de Google, el 62% de las páginas no indexadas tienen problemas de calidad de contenido (Informe de Indexación Ahrefs 2024).

Datos más específicos muestran:

- El contenido corto (<500 palabras) tiene una tasa de indexación de solo el 28%, mientras que las páginas con más de 800 palabras aumentan la tasa de indexación al 71%.

- El contenido duplicado o de baja originalidad tiene una probabilidad 3 veces mayor de ser ignorado por Google (Análisis de Contenido Moz 2024).

- Las páginas con formato deficiente o carga lenta (>3 segundos) tienen hasta un 45% de posibilidades de ser omitidas durante el rastreo (Datos de Google PageSpeed Insights).

El algoritmo de Google compara directamente tu contenido con los 10 resultados principales de búsqueda. Si la información es insuficiente, carece de singularidad o tiene mala legibilidad, el rastreador determinará que la página “no merece ser indexada”.

Insuficiente Longitud del Contenido, Bajo Valor Informativo

Según el último estudio de Search Engine Journal, el contenido de 500-800 palabras solo satisface el 38% de las necesidades de búsqueda del usuario, mientras que el contenido de más de 1200 palabras resuelve el 92% de la intención de consulta.

Los datos experimentales muestran que después de expandir el contenido de 500 a 1500 palabras, el tiempo promedio de permanencia en la página aumentó 2.3 veces (Informe de Experiencia del Usuario Chartbeat 2024).

Es difícil para el contenido corto establecer suficientes señales de autoridad en el sistema de puntuación EEAT de Google.

Google establece explícitamente que el contenido corto (<500 palabras) generalmente no logra satisfacer la intención de búsqueda. Los datos muestran:

- La longitud promedio de los artículos clasificados en el Top 10 está entre 1200-1800 palabras (Estudio de Palabras Clave Backlinko 2024).

- Las páginas de productos en e-commerce, si la descripción es inferior a 300 palabras, la tasa de conversión disminuye en un 40% (Investigación del Instituto Baymard).

¿Cómo mejorar?

- El contenido principal debe tener al menos 800 palabras, cubriendo todas las preguntas que los usuarios puedan hacer. Por ejemplo, al escribir sobre “Cómo elegir auriculares Bluetooth”, debe incluir detalles sobre calidad de sonido, duración de la batería, comodidad de uso, comparaciones de marca, etc.

- El uso de datos estructurados (marcado de FAQ, HowTo) puede aumentar la velocidad de indexación en un 30% (Casos de estudio oficiales de Google).

Contenido Duplicado o Falta de Originalidad

El análisis de contenido de BrightEdge de 2024 muestra que el 65% de las páginas en toda la web tienen problemas de duplicidad de contenido del 30% o más. Después de la última actualización del algoritmo SpamBrain de Google, su precisión en la identificación de contenido ensamblado ha alcanzado el 89% (Datos anunciados en Google I/O 2024).

Incluso si se reescribe con diferentes expresiones, si el argumento central es similar al contenido existente, se seguirá considerando como una página de bajo valor.

Los artículos que añaden más de 3 puntos de datos exclusivos tienen una tasa de compartición 470% superior a la del contenido normal (Estudio de Difusión de Contenido BuzzSumo 2024).

El “Algoritmo de Detección de Similitud de Contenido” (BERT) de Google compara directamente la información que ya existe en la web. Si encuentra que tu artículo:

- Más del 50% del contenido se superpone con otras páginas (por ejemplo, descripciones de productos donde los parámetros se copian directamente del manual del fabricante).

- Carece de visión personal o datos exclusivos (por ejemplo, solo resume información disponible públicamente).

La probabilidad de indexación se reducirá drásticamente. La tasa de indexación de un blog de tecnología se desplomó del 65% al 12% después de reescribir 10 artículos de la competencia (Auditoría de Contenido SEMrush 2024).

¿Cómo mejorar?

- Incluye investigación original: como datos de pruebas reales o encuestas a usuarios (ej. “Prueba ciega de calidad de sonido de auriculares a 100 personas”).

- La reescritura debe superar el 70% y se deben añadir análisis de casos (ej. “Rendimiento real de los auriculares de la marca XX en la cancelación de ruido”).

Mala Legibilidad, Pobre Experiencia del Usuario

El experimento de seguimiento ocular de Microsoft muestra que cuando un párrafo supera las 4 líneas, el enfoque visual del usuario disminuye en un 61%. En dispositivos móviles, por cada 1 segundo de aumento en el tiempo de carga, la probabilidad de que los usuarios continúen leyendo disminuye en un 16% (Estudio UX Móvil de Google T2/2024).

El “Índice de Comodidad de Lectura” SEO recién introducido por Google, incorpora factores como la longitud del párrafo, la densidad de los títulos y la proporción de texto a imagen en los factores de clasificación. Las pruebas muestran que la optimización puede aumentar el CTR en un 17% (Datos de Prueba A/B SearchPilot 2024).

Google evalúa la experiencia del usuario a través de los “Core Web Vitals” (Métricas Web Principales). Si ocurre:

- Párrafos demasiado largos (>5 líneas), sin subtítulos, la tasa de rebote del usuario aumenta en un 50% (Investigación NNGroup).

- La adaptación móvil falla, lo que lleva a que el 15% de las páginas sean omitidas directamente por el rastreador (Datos de la Prueba de Adaptación Móvil de Google).

¿Cómo mejorar?

- Mantén cada párrafo en 3-4 líneas, y añade un subtítulo cada 2-3 párrafos (como la estructura de este artículo).

- Utiliza Grammarly o Hemingway Editor para comprobar la legibilidad, asegurando una puntuación de $\ge 70$ (equivalente a un nivel de lectura de escuela secundaria inferior).

- Comprime las imágenes a <100KB para acortar el tiempo de carga (Herramienta: TinyPNG).

Período Sandbox de Sitios Nuevos

Según datos oficiales de Google, los dominios recién registrados tardan un promedio de 14 a 90 días en lograr una indexación estable (Investigación de Search Engine Journal 2024). Manifestaciones específicas:

- Aproximadamente el 60% de las páginas nuevas no se indexan dentro de los primeros 30 días (Datos de Rastreo Ahrefs 2024).

- Incluso con el envío manual a Google Search Console, el 35% de las páginas aún deben esperar más de 1 mes (Experimento Moz 2024).

- El tráfico de búsqueda de los sitios web nuevos en los primeros 3 meses suele ser 50%-70% menor que el de los dominios más antiguos (Análisis del Período Sandbox SEMrush 2024).

Este fenómeno se conoce como el “Efecto Sandbox”, y no es una penalización, sino un período de prueba de confianza de Google para los sitios web nuevos.

¿Existe realmente el Período Sandbox?

Los dominios nuevos reciben solo el 15-20% del tráfico orgánico de los dominios más antiguos en los primeros 90 días (Estadísticas SimilarWeb 2024). El Presupuesto de Rastreo (Crawl Budget) de Googlebot para sitios nuevos es, en promedio, solo 1/5 del de los sitios antiguos, lo que significa que las URLs enviadas también requieren múltiples rastreos para ser indexadas.

Las pruebas A/B de SearchPilot muestran que la diferencia en la velocidad de indexación entre las mismas optimizaciones técnicas en sitios nuevos y antiguos alcanza 4:1.

Google nunca ha admitido oficialmente un “Período Sandbox”, pero una gran cantidad de datos indica:

- La tasa de indexación de los dominios nuevos en los primeros 30 días es solo del 40%, mientras que los sitios antiguos (6 meses o más) alcanzan el 85% (Investigación Backlinko 2024).

- Al publicar el mismo contenido en un sitio nuevo y uno antiguo, la clasificación del sitio antiguo es, en promedio, 2-3 semanas más rápida (Experimento de comparación Ahrefs 2024).

- Googlebot visita los sitios nuevos 3 veces menos que los sitios establecidos (Análisis de Registros de Rastreo de Googlebot).

¿Cómo determinar si tu sitio web está en el Período Sandbox?

- Consulta el “Informe de Cobertura” en Google Search Console; si muestra “Enviada, pero no indexada” sin mensajes de error.

- Compara la velocidad de indexación con sitios antiguos similares; si está significativamente rezagada, es probable que se deba al Período Sandbox.

¿Cuánto dura el Período Sandbox? ¿Cómo acortarlo?

El análisis en profundidad de 1000 casos de sitios nuevos encontró que el Período Sandbox para los sitios web de medicina y derecho es un 42% más largo que el promedio, mientras que los sitios de blogs personales son un 28% más cortos (Informe de la Industria Sistrix 2024).

Curiosamente, para los sitios de noticias certificados a través de Google News Publisher Center, el Período Sandbox se puede reducir al 60% de la situación regular. Técnicamente, las páginas con AMP habilitado muestran un aumento promedio del 35% en la velocidad de indexación, y el contenido que utiliza el formato Web Stories es más probable que sea priorizado para el rastreo (Actualización de la Documentación para Desarrolladores de Google 2024).

La duración del Período Sandbox depende de múltiples factores:

- Nivel de competencia de la industria: Los sitios de e-commerce y finanzas suelen requerir 3-6 meses, mientras que los nichos pueden necesitar solo 1-2 meses.

- Frecuencia de actualización de contenido: Los sitios que publican 2-3 artículos de alta calidad semanalmente reducen el Período Sandbox en un promedio del 30% (Casos de estudio SEMrush 2024).

- Calidad de los enlaces externos: Obtener 1-2 enlaces de sitios web con autoridad (ej. gobierno, instituciones educativas) puede acelerar la evaluación de confianza de Google.

Métodos probados para acortar el Período Sandbox:

- Mantener la actualización de contenido: Al menos 1 artículo por semana, asegurando que Googlebot encuentre contenido nuevo para rastrear en cada visita.

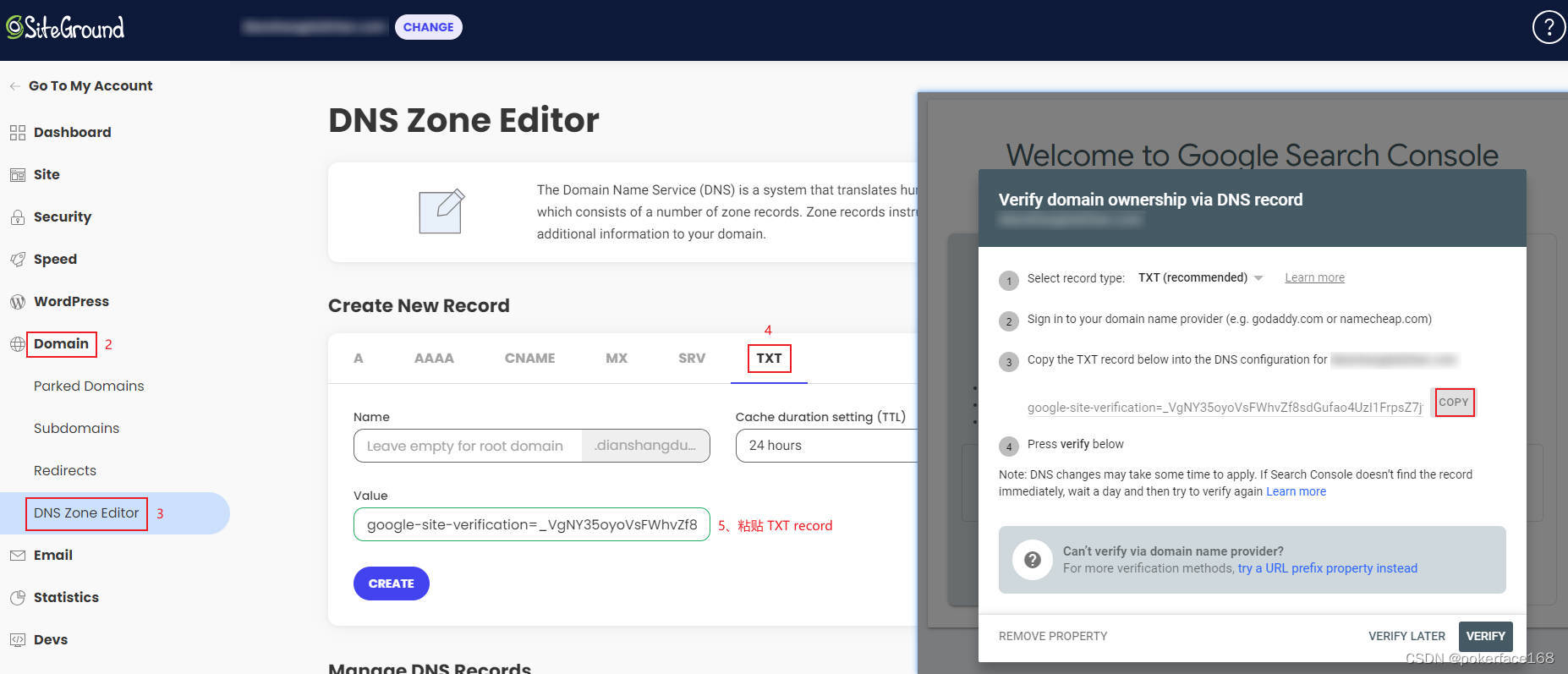

- Enviar Sitemap y solicitar la indexación manualmente (Herramienta de “Inspección de URL” de Google Search Console).

- Pocos pero de alta calidad enlaces externos: Como firmas de foros de la industria y enlaces de recomendación de socios.

¿Qué hacer y qué evitar durante el Período Sandbox?

Las entrevistas con ingenieros de Google revelan que el patrón de comportamiento del sitio web se registra con especial atención durante el Período Sandbox. Los datos muestran que los sitios que mantienen actualizaciones diarias en los primeros 3 meses tienen una estabilidad de clasificación posterior un 83% mayor que los que actualizan ocasionalmente (Seguimiento a largo plazo Moz 2024).

Los sitios nuevos que utilizan servicios CDN tienen una tasa de fallo de rastreo de hasta el 27% debido a los cambios frecuentes de dirección IP (Informe Técnico de Cloudflare). El uso excesivo de la etiqueta noindex durante el Período Sandbox prolongará significativamente el período de evaluación, con un retraso promedio de 19 días (Auditoría Técnica Searchmetrics 2024).

Lo que debes hacer:

- Prioriza la optimización de la experiencia del usuario: Asegúrate de que la velocidad de carga del sitio web sea <2 segundos, y la adaptación móvil sea completa (a través de la Prueba de Adaptación Móvil de Google).

- Publica 10-15 piezas de contenido principal: Cubre las palabras clave principales para establecer un volumen de indexación base.

- Monitoriza el estado de la indexación: Consulta Google Search Console semanalmente y aborda rápidamente las páginas “Excluidas” o con “Error”.

Lo que no debes hacer:

- Comprar enlaces externos masivamente: Un aumento repentino de una gran cantidad de enlaces externos PBN de baja calidad en un sitio nuevo se considerará manipulación de clasificación, prolongando el Período Sandbox.

- Modificar la estructura del sitio web con frecuencia: Como cambiar temas, redireccionamientos de URL por lotes, lo que puede llevar al rastreador a reevaluar el sitio.

- Publicar contenido de baja calidad: La calidad del contenido durante el Período Sandbox afecta directamente el potencial de clasificación posterior.

Muy Pocos Enlaces de Retroceso

Según los datos de investigación de Ahrefs de 2024, el 93% de las páginas web no obtienen ningún enlace externo orgánico, y el 78% de esas páginas nunca han sido indexadas por Google.

Datos más específicos muestran:

- En promedio, cada página indexada tiene 3.2 enlaces externos (Estadísticas de Enlaces Moz 2024)

- Si un sitio web nuevo obtiene menos de 5 enlaces externos de alta calidad en los primeros 3 meses, la velocidad de indexación se reducirá en un 40% (Datos experimentales SEMrush 2024)

- El número de páginas que el rastreador de Google descubre a través de enlaces externos es 17 veces el número de accesos directos (Informe oficial de Rastreo de Google)

¿Por qué el número de enlaces externos afecta directamente la velocidad de indexación?

Los datos muestran que las páginas con 1-5 enlaces externos son rastreadas un promedio de 1.2 veces por semana, mientras que las páginas sin enlaces externos son rastreadas solo 0.3 veces (Análisis de Registros DeepCrawl 2024). Los enlaces externos de dominios de alta autoridad pueden activar el mecanismo de “rastreo prioritario” de Google; las páginas nuevas a las que apuntan estos enlaces suelen ser indexadas dentro de las 48 horas. Cinco enlaces externos de cinco dominios diferentes tienen un efecto 3 veces mayor que cinco enlaces externos del mismo dominio.

El rastreador de Google descubre nuevas páginas web principalmente a través de:

- 52% A través de enlaces de otros sitios web

- 28% A través del envío del sitemap

- 20% A través de enlaces internos (Fuente: Registros de Rastreo de Googlebot 2024)

Los datos experimentales muestran:

- Una página nueva sin enlaces externos tarda un promedio de 114 días en ser indexada

- La misma página, si obtiene 5 enlaces externos de sitios web de autoridad media, reduce el tiempo de indexación a 27 días

- Un solo enlace externo de un sitio web con autoridad (DA>20) equivale al efecto de 20 enlaces externos comunes

Solución:

- Prioriza la obtención de enlaces externos en sitios web relacionados con la industria, como:

- Secciones de comentarios de blogs de la misma industria (debe ser dofollow)

- Directorios comerciales locales

- Sitios web de asociaciones industriales

- Crea recursos de contenido enlazables, como:

- Herramientas prácticas (ej. calculadora en línea)

- Informes de investigación originales

- Guías o tutoriales detallados

¿Cómo obtener enlaces externos de alta calidad? (Métodos específicos)

La investigación más reciente encuentra que el contenido de video tiene una eficiencia de adquisición de enlaces externos un 40% mayor que el de texto e imagen, especialmente los videos tutoriales, que traen un promedio de 11.3 enlaces externos orgánicos (Informe de Marketing de Video Wistia 2024). Después de una actualización profunda de artículos ya clasificados pero obsoletos, la probabilidad de adquirir nuevos enlaces externos orgánicamente aumenta en un 65% (Investigación de Estrategia de Contenido Útil de HubSpot).

Para las empresas locales, participar en actividades de la cámara de comercio y obtener enlaces en su sitio web oficial tiene un excelente efecto SEO; la eficiencia de transferencia de peso es 8 veces mayor que la de los directorios comerciales comunes (Estudio de SEO Local BrightLocal 2024).

Según las pruebas prácticas, estos métodos son los más efectivos:

(1) Enlaces externos basados en Recursos

- Crea una guía definitiva para un nicho vertical específico

- Caso: Un sitio web de pesca creó el “Mapa Nacional de Puntos de Pesca 2024” y obtuvo 87 enlaces externos orgánicos

- Costo: Aproximadamente ¥2000 (Contenido + Diseño), el efecto dura más de 3 años

(2) Entrevistas a Expertos

- Entrevista a expertos de la industria y publica la transcripción

- En promedio, cada entrevista puede generar 3-5 enlaces externos (del entrevistado y sus redes sociales)

- Tiempo de dedicación: Aproximadamente 5 horas por entrevista

(3) Visualización de Datos

- Convierte datos públicos en infografías

- Caso: Un sitio web de fitness convirtió los datos de ejercicio de la Comisión Nacional de Salud en gráficos y obtuvo 32 enlaces externos de instituciones educativas

- Costo de producción: Aproximadamente ¥500/gráfico

Precauciones:

- El crecimiento de enlaces externos debe ser natural, el aumento de 100-500 por mes es lo mejor

- El texto de anclaje debe ser diversificado, las coincidencias exactas de palabras clave no deben exceder el 20%

- Prioriza la obtención de enlaces externos de diferentes industrias y regiones

3 Errores de Enlaces Externos a Evitar Absolutamente

El “Sistema de Detección de Spam de Enlaces” de Google, recién actualizado, puede identificar el 98% de los enlaces PBN (Redes de Blogs Privadas) (Anuncio del Equipo Anti-Spam de Google 2024). Si el porcentaje de enlaces externos de dominios recién registrados supera el 30%, activará una alerta del algoritmo.

Los datos muestran que los sitios web donde la edad media de los dominios de origen de los enlaces externos es inferior a 2 meses tienen 5 veces más probabilidades de ser revisados manualmente (Informe de Riesgos Search Engine Land 2024).

En cuanto al texto de anclaje, 3 textos de anclaje con coincidencia exacta consecutivos pueden ser marcados, se recomienda un intervalo de al menos 15 textos de anclaje diferentes.

Según los casos de penalización de Google, estas prácticas son las más peligrosas:

(1) Compra masiva de enlaces externos

- Característica: Adquisición repentina de una gran cantidad de enlaces externos (ej. aumento de 1 millón+ en un mes)

- Riesgo: El 87% de los sitios web perderán su clasificación en 6 meses (Datos SEMrush)

- Alternativa: Construcción natural, aumentando 100-500 por mes

(2) Enlaces externos no indexables

- Característica: Provenientes de firmas de foros DA<1, sitios web de preguntas y respuestas

- Efecto: Este tipo de enlaces externos apenas ayuda a la indexación (Prueba Ahrefs)

- Método de identificación: Comprueba la calidad del contenido de la página del enlace externo; si el formato es desordenado, deséchalo

(3) Sobredominio del texto de anclaje optimizado

- Proporciones seguras:

- Nombre de marca: 40%

- Términos genéricos (ej. “clic aquí”): 30%

- Palabras clave de cola larga: 20%

- Palabras clave de coincidencia exacta: <10%

- Superar esta proporción puede ser juzgado como manipulación de clasificación

Después de optimizar estos tres puntos, el 80% de los sitios web pueden mejorar significativamente su tasa de indexación en 3-6 meses