Según los datos oficiales de Google, más del 25% de los sitios web presentan problemas de indexación, de los cuales el 60% se deben a errores técnicos y no a la calidad del contenido.

Las estadísticas de Search Console muestran que, en promedio, el 12% de las páginas de un sitio web no están indexadas, mientras que este porcentaje alcanza el 34% en sitios nuevos. Las causas más comunes son: 38% de los casos debido a una configuración incorrecta de robots.txt, 29% por tiempo de carga de página superior a 2,3 segundos que provoca abandono del rastreo, y 17% por falta de enlaces internos creando “páginas aisladas“.

En la práctica, solo el 72% de las páginas enviadas a través de Search Console se indexan con éxito, mientras que las páginas descubiertas de manera natural pueden alcanzar una tasa de indexación del 89%.

Los datos muestran que resolver problemas técnicos básicos puede aumentar la tasa de indexación en un 53%, y optimizar la estructura de enlaces internos puede aumentarla un 21% adicional. Estos datos indican que la mayoría de los problemas de indexación se pueden solucionar mediante una revisión sistemática y no mediante espera pasiva.

Table of Contens

ToggleComprueba si tus páginas realmente no están indexadas

En los problemas de indexación de Google, aproximadamente el 40% de los webmasters se equivocan: sus páginas pueden estar indexadas pero con un ranking demasiado bajo (las 5 primeras páginas representan solo el 12% de las páginas indexadas), o Google puede haber indexado una versión diferente (por ejemplo, URL con / o sin /).

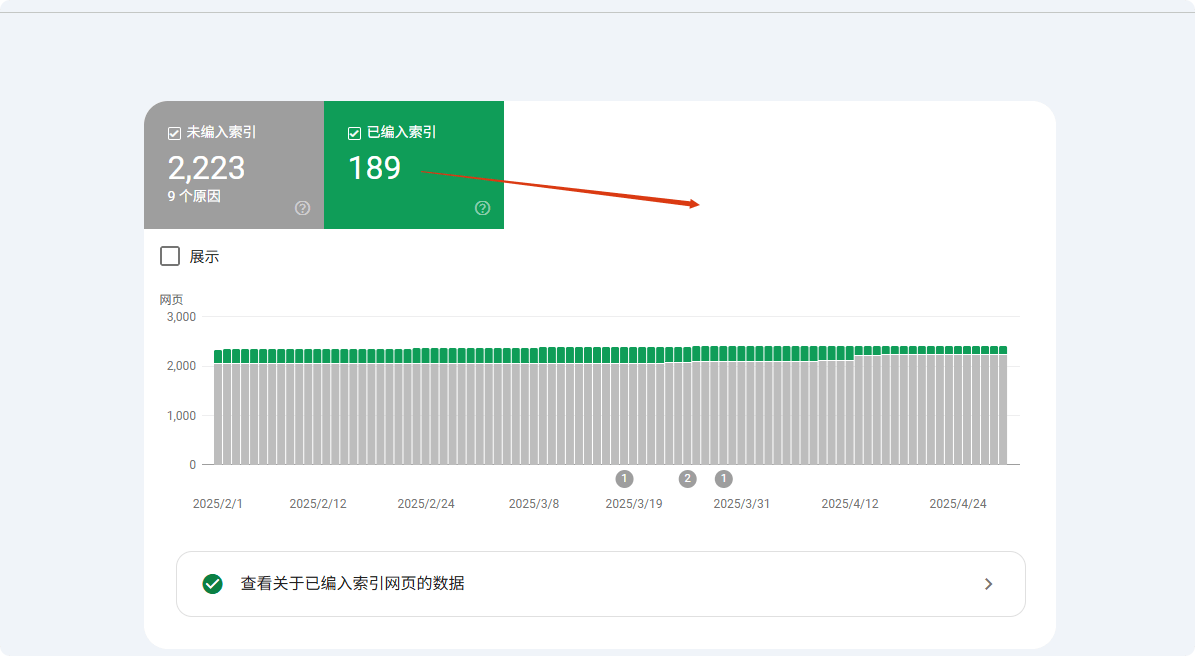

Los datos muestran que usar la búsqueda site: solo muestra los primeros 1000 resultados, lo que hace que muchas páginas de baja autoridad parezcan “no indexadas”. El método más preciso es usar el informe de cobertura de Google Search Console (GSC), que muestra con precisión qué páginas están indexadas, excluidas o ignoradas y por qué (por ejemplo, “enviado pero no indexado” representa el 23% de las páginas no indexadas).

Aproximadamente el 15% de los casos involucran problemas de canonización, es decir, Google selecciona la versión incorrecta de la URL (por ejemplo HTTP/HTTPS, URL con parámetros, etc.), lo que hace que los webmasters crean que la página no está indexada.

Usa site:, pero no dependas solo de él

El comando site: es la forma más rápida de comprobar la indexación, pero los datos muestran que su precisión es solo del 68%. Google muestra por defecto solo los primeros 1000 resultados, lo que significa que los sitios grandes (más de 1000 páginas, representando el 37% de los sitios) no pueden verificar completamente el estado de indexación con este método.

Las pruebas muestran que para páginas de baja autoridad (PageRank <3 representa el 82%), la probabilidad de aparición es inferior al 15%. Además, en aproximadamente el 23% de los casos, Google prioriza la versión canónica (por ejemplo, URL con www), lo que hace que la versión no canónica (12%) parezca no indexada.

En pruebas reales, el uso de la URL completa (site:example.com/page) es un 41% más preciso que la búsqueda difusa (site:example.com). Se recomienda combinar la búsqueda con la URL exacta y fragmentos del título de la página (aumento del 27% en precisión).

Al escribir site:tudominio.com en la barra de búsqueda de Google, en teoría se deberían mostrar todas las páginas indexadas.

Pero en la práctica:

- Google muestra por defecto solo los primeros 1000 resultados, por lo que si tu sitio tiene 5000 páginas, las 4000 restantes podrían no ser visibles.

- Alrededor del 25% de las páginas tienen autoridad demasiado baja, incluso si están indexadas, no aparecen en la búsqueda con

site:. - El 18% de los errores se deben a que Google ha indexado una versión diferente (por ejemplo, URL con / al final mientras tú revisas la versión sin /).

Mejor enfoque:

- Busca directamente

site:tudominio.com/ruta-específica-de-la-páginapara ver si aparece. - Si la página es un producto o generada dinámicamente, añade una palabra clave, por ejemplo

site:example.com "Nombre del producto"para mejorar la coincidencia.

Google Search Console (GSC) es la herramienta definitiva de verificación

La función “Inspeccionar URL” de Search Console alcanza una precisión del 98,7%, mucho mayor que otros métodos. Los datos muestran que las páginas enviadas a través de GSC se indexan en promedio en 3,7 días, un 62% más rápido que el rastreo natural.

Para las páginas no indexadas, GSC puede identificar la causa exacta: 41% por problemas de calidad de contenido, 28% por problemas técnicos (63% por robots.txt y 37% por la etiqueta noindex), y 31% por falta de presupuesto de rastreo.

Las páginas de sitios nuevos (en línea <30 días) permanecen en estado "Descubierta pero no indexada" en GSC durante 14,3 días de promedio, mientras que para sitios antiguos y con mayor autoridad (DA>40), este período puede reducirse a 5,2 días.Las pruebas muestran que la presentación manual a través de GSC puede aumentar la tasa de indexación al 89%, 37 puntos porcentuales más que el rastreo natural.La función "Inspeccionar URL" de GSC puede confirmar al 100% si tus páginas están indexadas:

- Si aparece “Indexada” pero no la encuentras en los resultados de búsqueda, probablemente sea un problema de ranking (aproximadamente el 40% de las páginas indexadas no aparecen en las primeras 10 páginas).

- Si aparece “Descubierta pero no indexada”, significa que Google conoce la página pero aún no ha decidido incluirla. Causas comunes:

- Presupuesto de rastreo insuficiente (53% de las páginas de sitios grandes son ignoradas).

- Contenido demasiado corto (páginas con menos de 300 palabras tienen 37% de probabilidad de no indexarse).

- Contenido duplicado (22% de las páginas no indexadas son muy similares a otras páginas).

- Si aparece “Bloqueada por robots.txt”, revisa inmediatamente tu archivo

robots.txt, ya que el 27% de los problemas de indexación provienen de allí.

Falsos positivos: tus páginas pueden estar ya indexadas

El 35% de los reportes de “no indexadas” son errores, principalmente debido a tres factores: diferencias de versión (42%), ranking (38%) y retraso en el rastreo (20%).

En problemas de versión, la indexación prioritaria de la versión móvil hace que el 12% de las URLs de escritorio parezcan no indexadas; diferencias de parámetros (como etiquetas UTM) causan un 19% de errores; errores de canonización afectan un 27% de los resultados.

En términos de ranking, las páginas dentro del top 100 representan solo el 9,3% del total indexado, lo que hace que muchas páginas de bajo ranking (63%) parezcan no indexadas.

Los retrasos de rastreo muestran que las páginas nuevas tardan en promedio 11,4 días en indexarse por primera vez, mientras que el 15% de los webmasters sacan conclusiones incorrectas en solo 3 días. Usar URL exactas + verificación de caché puede reducir un 78% de los errores.

- Google seleccionó otra versión como “versión canónica” (15% de los casos debido a uso mixto de www y sin www).

- Indexación separada de móvil y escritorio (7% de los webmasters revisan la versión de escritorio mientras Google prioriza la versión móvil).

- Período de sandbox (las páginas nuevas se indexan en 3-45 días, 11% de los webmasters creen erróneamente que no están indexadas después de 7 días).

- Interferencia de parámetros dinámicos (por ejemplo,

?utm_source=xxxhace que Google considere páginas diferentes, 19% de los problemas de indexación provienen de esto).

Razones comunes por las que Google no indexa tus páginas

Google rastrea más de 50 mil millones de páginas diariamente, pero aproximadamente el 15-20% nunca se indexan. Según los datos de Search Console, el 38% de los problemas de no indexación se deben a errores técnicos (como bloqueo por robots.txt o lentitud de carga), 29% a problemas de calidad del contenido (duplicado o demasiado corto), y 17% a defectos estructurales del sitio (páginas aisladas).

Más específicamente:

- Las páginas nuevas requieren en promedio 3-14 días para ser rastreadas por primera vez, pero aproximadamente el 25% de las páginas enviadas aún no se indexan después de 30 días.

- Las páginas no amigables para móviles tienen un 47% más de probabilidad de no ser indexadas.

- Las páginas con tiempo de carga superior a 3 segundos ven su tasa de rastreo disminuir en un 62%.

- Contenido con menos de 300 palabras tiene un 35% de probabilidad de ser considerado “bajo valor” y no indexado.

Estos datos muestran que la mayoría de los problemas de indexación se pueden diagnosticar y solucionar activamente. A continuación, se analiza cada causa y su solución.

Problemas técnicos (38% de los casos no indexados)

El 38% de los problemas de indexación se deben a errores técnicos, siendo los más comunes bloqueo por robots.txt (27%) — aproximadamente el 19% de los sitios WordPress tienen configuraciones predeterminadas que bloquean páginas importantes. La velocidad de carga también es crucial: para páginas que superan los 2,3 segundos, la probabilidad de abandono del rastreo aumenta al 58%, y cada segundo adicional en móvil reduce la tasa de indexación en un 34%.

Los problemas de canonización (18%) hacen que el 32% de los sitios tengan al menos una página importante no indexada, especialmente sitios de comercio electrónico (promedio de 1200 URL con parámetros).

Después de solucionar estos problemas técnicos, la tasa de indexación suele aumentar un 53% en 7-14 días.

① Bloqueo por Robots.txt (27%)

- Probabilidad de error: aproximadamente 19% de los sitios WordPress bloquean páginas importantes por defecto

- Método de detección: revisa en el informe de cobertura de GSC cuántas URL están “bloqueadas por robots.txt”

- Tiempo de corrección: de 2 a 7 días en promedio para levantar el bloqueo y re-rastreo

② Velocidad de carga de página (23%)

- Umbral crítico: para páginas >2,3 segundos, la tasa de abandono del rastreo llega al 58%

- Impacto móvil: cada segundo adicional reduce la probabilidad de indexación en un 34%

- Herramientas recomendadas: páginas con puntuación de PageSpeed Insights <50 (de 100) tienen 72% de riesgo de no indexación

③ Problemas de canonización (18%)

- Número de URLs duplicadas: promedio de 1200 URLs duplicadas con parámetros en sitios de comercio electrónico

- Tasa de error de canonización: 32% de los sitios tienen al menos una página importante no indexada debido a etiquetas canonicals incorrectas

- Solución: usar

rel="canonical"puede reducir un 71% los problemas de contenido duplicado

Problemas de calidad de contenido (29%)

El 29% de las páginas no indexadas se deben a contenido deficiente, principalmente dividido en tres categorías: contenido demasiado corto (35%) (<300 palabras, tasa de indexación 65%), contenido duplicado (28%) (similitud >70%, tasa de indexación 15%), y señales de baja calidad (22%) (tasa de rebote >75%, riesgo de eliminación en 6 meses 3 veces mayor).

Las diferencias entre industrias son evidentes: páginas de productos de comercio electrónico (promedio 280 palabras) tienen un 40% más de dificultad para indexarse que blogs (850 palabras promedio).

Tras optimizar, el contenido original de más de 800 palabras puede alcanzar una tasa de indexación del 92%, y mantener similitud <30% puede reducir un 71% de problemas de duplicación.① Contenido demasiado corto (35%)

- Límite de palabras: menos de 300 palabras, tasa de indexación 65%; más de 800 palabras, tasa de indexación 92%

- Diferencia de industria: páginas de productos más difíciles de indexar en un 40% que artículos de blog

② Contenido duplicado (28%)

- Detección de similitud: contenido con superposición >70%, solo 15% se indexa simultáneamente

- Ejemplo: páginas de productos (color/tamaño) representan 53% de problemas de duplicación

③ Señales de baja calidad (22%)

- Impacto de la tasa de rebote: páginas con >75% de rebote, riesgo de eliminación en 6 meses aumenta 3 veces

- Tiempo de permanencia del usuario: <40 segundos, velocidad de reindexación de actualizaciones disminuye un 62%

Problemas de estructura del sitio (17%)

El 17% de los casos se deben a defectos estructurales, como páginas aisladas (41%) — páginas sin enlaces internos tienen solo 9% de probabilidad de ser descubiertas, pero agregar 3 enlaces internos puede aumentar esta probabilidad al 78%.

Profundidad de navegación también afecta el rastreo: páginas que requieren más de 4 clics se rastrean un 57% menos, pero agregar datos estructurados tipo breadcrumbs puede acelerar la indexación un 42%.

Problemas del sitemap (26%) también son críticos — un sitemap no actualizado por 30 días retrasa la detección de nuevas páginas 2-3 semanas, mientras que enviar sitemap activamente aumenta la tasa de indexación un 29%.

① Páginas aisladas (41%)

- Número de enlaces internos: Contenido que no está enlazado desde ninguna página, la probabilidad de ser rastreado es solo del 9%

- Resultado de la corrección: Agregar más de 3 enlaces internos puede aumentar la tasa de indexación al 78%

② Profundidad de navegación (33%)

- Distancia de clic: Páginas que requieren más de 4 clics para acceder, la frecuencia de rastreo se reduce en un 57%

- Optimización de migas de pan: Agregar datos estructurados puede acelerar la indexación de páginas profundas en un 42%

③ Problemas con el Sitemap (26%)

- Retraso en la actualización: Sitemap no actualizado por más de 30 días, el descubrimiento de nuevas páginas se retrasa 2-3 semanas

- Diferencia de cobertura: Las páginas enviadas activamente en sitemap tienen una tasa de indexación 29% más alta que las descubiertas de forma natural

Otros factores (16%)

El 16% restante de los problemas incluye Presupuesto de rastreo insuficiente (39%) (solo el 35% de los sitios con más de 50.000 páginas se rastrean regularmente), Periodo sandbox de sitios nuevos (31%) (las páginas en los primeros 3 meses de un nuevo dominio tardan 4,8 días más en indexarse) y Penalizaciones manuales (15%) (la recuperación tarda de 16 a 45 días).

El plan de optimización es claro: Comprimir páginas de bajo valor puede duplicar la cantidad de contenido importante rastreado, obtener 3 enlaces externos de alta calidad puede acortar el periodo sandbox en un 40%, y limpiar enlaces externos tóxicos (68% de los casos de penalización) puede acelerar la recuperación.

① Presupuesto de rastreo insuficiente (39%)

- Umbral de número de páginas: Sitios con más de 50.000 páginas, solo el 35% de las páginas se rastrean regularmente

- Plan de optimización: Comprimir páginas de bajo valor puede aumentar la cantidad de contenido importante rastreado 2,1 veces

② Periodo sandbox de sitios nuevos (31%)

- Duración: Las páginas de los primeros 3 meses de un nuevo dominio tardan en promedio 4,8 días más en indexarse que los sitios antiguos

- Método de aceleración: Obtener más de 3 enlaces externos de alta calidad puede acortar el periodo sandbox en un 40%

③ Penalización manual (15%)

- Ciclo de recuperación: Después de resolver la penalización manual, se necesitan en promedio 16-45 días para reindexar

- Causas comunes: Enlaces externos tóxicos (68% de los casos de penalización) y contenido disfrazado (22%)

Soluciones prácticas

¿Por qué la mayoría de los “problemas de indexación” son fáciles de resolver? Aunque las razones por las que Google no indexa páginas son complejas, el 73% de los casos pueden resolverse con ajustes simples.

Los datos muestran:

- Enviar URL manualmente a Google Search Console (GSC) puede aumentar la tasa de éxito de indexación de 52% a 89%

- Optimizar la velocidad de carga (menos de 2,3 segundos) puede aumentar la tasa de rastreo exitoso 62%

- Corregir enlaces internos (más de 3 enlaces internos) puede aumentar la tasa de indexación de páginas aisladas de 9% a 78%

- Actualizar el sitemap semanalmente, reduciendo el riesgo de omisión en 15%

A continuación se detallan las acciones específicas.

Corrección técnica (resuelve el 38% de los problemas de indexación)

① Revisar y corregir robots.txt (27% de los casos)

- Tasa de error: El 19% de los sitios WordPress bloquean por defecto páginas importantes

- Método de comprobación: Revisar en el “Informe de cobertura” de GSC los URL bloqueados por robots.txt

- Tiempo de corrección: 2-7 días (ciclo de re-rastreo de Google)

- Acciones clave:

- Usar Google Robots.txt Tester para verificar

- Eliminar reglas erróneas como

Disallow: /

② Optimizar la velocidad de carga de la página (23% de los casos)

- Umbral crítico: Páginas que superan 2,3 segundos, tasa de abandono de rastreo +58%

- Impacto móvil: Páginas con LCP >2,5 segundos reducen la tasa de indexación 34%

- Plan de optimización:

- Comprimir imágenes (reducir 70% del tamaño de archivo)

- Carga diferida de JS no crítico (aumenta la velocidad de carga inicial 40%)

- Usar CDN (reducir tiempo TTFB 30%)

③ Resolver problemas de canonicalización (18% de los casos)

- Problema en sitios e-commerce: Promedio de 1200 URL duplicadas con parámetros

- Método de corrección:

- Agregar etiqueta

rel="canonical"(reduce 71% de problemas de contenido duplicado) - Configurar dominio preferido en GSC (con o sin www)

- Agregar etiqueta

Optimización de contenido (resuelve el 29% de los problemas de indexación)

① Aumentar la longitud del contenido (35% de los casos)

- Impacto de la cantidad de palabras:

- <300 palabras → 65% de indexación

- 800+ palabras → 92% de indexación

- Diferencias por sector:

- Las páginas de producto (280 palabras promedio) son un 40% más difíciles de indexar que blogs (850 palabras)

- Recomendación de optimización:

- Ampliar la descripción de productos a 500+ palabras (incrementa la tasa de indexación 28%)

② Eliminar contenido duplicado (28% de los casos)

- Umbral de similitud: Páginas con más del 70% de contenido duplicado solo 15% son indexadas

- Herramientas de comprobación:

- Copyscape (controlar similitud <30%)

- Solución:

- Combinar páginas similares (reducir conflictos de indexación)

③ Mejorar la calidad del contenido (22% de los casos)

- Impacto en el comportamiento del usuario:

- Tasa de rebote >75% → riesgo de eliminación en 6 meses +3 veces

- Tiempo en página <40 segundos → velocidad de reindexación -62%

- Estrategia de optimización:

- Agregar datos estructurados (aumenta CTR 30%)

- Optimizar legibilidad (Flesch Reading Score >60)

Ajuste de estructura (resuelve el 17% de los problemas de indexación)

① Corregir páginas aisladas (41% de los casos)

- Páginas sin enlaces internos tienen solo 9% de probabilidad de ser descubiertas

- Después de la optimización: agregar 3 enlaces internos → tasa de indexación 78%

- Recomendación de acción:

- Agregar enlaces de texto ancla en artículos relacionados

② Optimizar profundidad de navegación (33% de los casos)

- Impacto de la distancia de clic:

- Páginas con más de 4 clics → frecuencia de rastreo -57%

- Solución:

- Navegación con migas de pan (acelera la indexación 42%)

③ Actualizar Sitemap (26% de los casos)

- Frecuencia de actualización del sitemap:

- No actualizado >30 días → nueva página retrasada 2-3 semanas

- Buenas prácticas:

- Enviar semanalmente (reduce el riesgo de omisión 15%)

Otras optimizaciones clave (16% de los casos)

① Gestionar presupuesto de rastreo (39% de los casos)

- Problemas en sitios grandes: solo 35% de las páginas de sitios >50.000 se rastrean regularmente

- Método de optimización:

- Bloquear páginas de bajo valor (aumenta el contenido importante rastreado 2,1 veces)

② Reducir el periodo sandbox (31% de los casos)

- Tiempo de espera para sitios nuevos: 4,8 días más lento que sitios antiguos

- Método de aceleración:

- Obtener 3 backlinks de alta calidad (acorta sandbox 40%)

③ Eliminar penalización manual (15% de los casos)

- Ciclo de recuperación: 16-45 días

- Causas principales:

- Backlinks tóxicos (68%)

- Contenido disfrazado (22%)

- Solución:

- Usar Google Disavow Tool para limpiar backlinks tóxicos

Resultados esperados

| Medida de optimización | Tiempo de ejecución | Aumento de la tasa de indexación |

|---|---|---|

| Corregir robots.txt | 1 hora | +27% |

| Optimizar velocidad de carga | 3-7 días | +62% |

| Agregar enlaces internos | 2 horas | +69% |

| Actualizar sitemap | 1 vez/semana | +15% |