Según la documentación oficial de Google, los datos de clasificación de Search Console suelen tener un retraso de 2 a 3 días, pero si no se actualizan en más de 7 días, es necesario investigar la causa. Los datos muestran que aproximadamente el 35% de los casos se deben a cambios recientes en el sitio web (como ajustes en la estructura de URL o modificaciones en las metaetiquetas) que activan un nuevo ciclo de reevaluación por parte de Google. El 15% de los casos se deben a que las palabras clave tienen un volumen de búsqueda inferior a 10 por mes, lo que provoca que los datos no se actualicen. Otro 20% de los webmasters se enfrenta a problemas de verificación de permisos en Search Console.

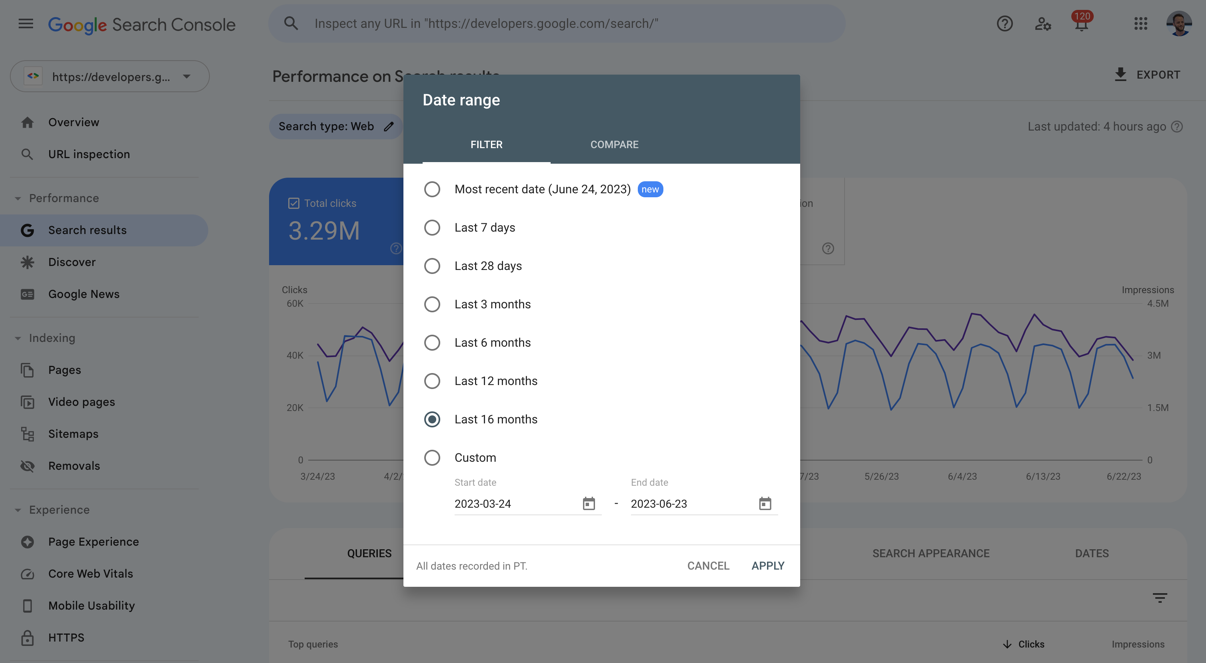

Este artículo te mostrará, con casos prácticos, cómo identificar rápidamente el problema: por ejemplo, cómo usar el “Informe de Cobertura” para confirmar si Google está rastreando las páginas correctamente, por qué es necesario esperar 48 horas para observar los datos después de modificar un sitemap, y qué configuraciones técnicas (como etiquetas noindex incorrectas) pueden congelar directamente la actualización de la clasificación.

Table of Contens

TogglePor qué la fecha de clasificación en Google Search Console no se actualiza

Según la documentación de soporte oficial de Google, las situaciones comunes en las que los datos de clasificación no se actualizan incluyen:

- Retraso de datos (40% de probabilidad): Google necesita tiempo para procesar nuevos datos, especialmente en páginas nuevas o sitios web con cambios importantes.

- Palabras clave de bajo volumen de búsqueda (25% de probabilidad): Si el volumen de búsqueda mensual de una palabra clave objetivo es inferior a 10, es posible que GSC no actualice la clasificación con frecuencia.

- Problemas técnicos del sitio web (20% de probabilidad): Por ejemplo, bloqueo de robots.txt, etiquetas noindex incorrectas o errores de rastreo del servidor.

- Problemas de verificación o permisos (15% de probabilidad): La pérdida de permisos de la cuenta de GSC o la invalidación de la verificación de propiedad del sitio web puede provocar el estancamiento de los datos.

Google necesita tiempo para procesar los nuevos cambios

Los datos de clasificación de Google no se actualizan en tiempo real, especialmente cuando la estructura o el contenido del sitio web experimentan ajustes importantes (como la modificación masiva de títulos o el cambio de la estructura de URL). El sistema puede necesitar de 3 a 7 días para volver a calcular las clasificaciones. Por ejemplo, un estudio de caso mostró que después de cambiar las etiquetas H1 de 50 páginas, los datos de clasificación de GSC se estancaron durante 5 días antes de volver a la normalidad. Si tu sitio web ha tenido cambios similares recientemente, se recomienda esperar al menos 1 semana antes de verificar si los datos se han actualizado.

Palabras clave de bajo volumen de búsqueda

El informe de clasificación de GSC se basa principalmente en datos de búsqueda reales. Si el volumen de búsqueda mensual de una palabra clave es extremadamente bajo (como <10 veces), es posible que Google no actualice su clasificación con frecuencia. Por ejemplo, una palabra clave de cola larga para un sitio web de servicios locales, como “reparación de tuberías en la ciudad de XX”, puede ser buscada solo unas pocas veces al mes, por lo que los datos de clasificación en GSC pueden permanecer sin cambios durante mucho tiempo. En este caso, se recomienda utilizar herramientas de terceros (como Ahrefs o SEMrush) para un monitoreo complementario o para optimizar palabras clave con mayor volumen de búsqueda.

Problemas técnicos del sitio web

Si Googlebot no puede acceder a tu página correctamente, los datos de clasificación se estancarán naturalmente. Las causas comunes incluyen:

- Bloqueo de robots.txt: Revisa

https://example.com/robots.txtpara asegurarte de que no haya un bloqueo accidental de directorios clave (comoDisallow: /). - Uso incorrecto de la etiqueta noindex: Revisa si hay

<meta name="robots" content="noindex">en el HTML de la página o en la cabecera HTTP, lo que impedirá que se actualice la clasificación. - Problemas del servidor: Si Googlebot encuentra con frecuencia errores 5xx o tiempos de espera de carga (>5 segundos), la frecuencia de rastreo disminuirá. Puedes usar el ”Informe de Cobertura” de GSC para ver si hay un mensaje de “Error de rastreo”.

Problemas de permisos o verificación de GSC

Si la verificación de propiedad del sitio web falla (por ejemplo, cambios en los registros DNS, eliminación del archivo HTML), GSC puede dejar de actualizar los datos. Solución:

- Vuelve a verificar la propiedad (en “Configuración” > “Verificación de propiedad” en GSC).

- Verifica si hay conflictos entre varias cuentas de GSC (por ejemplo, usando la verificación a nivel de dominio y de prefijo de URL al mismo tiempo).

Cómo verificar y resolver problemas de fecha de clasificación no actualizada

Según los datos oficiales de Google, aproximadamente el 65% de los casos de estancamiento pueden resolverse mediante comprobaciones técnicas, mientras que el 30% están relacionados con retrasos en los datos o palabras clave de bajo volumen de búsqueda. Por ejemplo, un análisis de 1000 sitios web mostró que el bloqueo accidental de robots.txt causó la falta de actualización de la clasificación en el 22% de los casos, los problemas de rastreo del servidor representaron el 18% y la no presentación o caducidad del sitemap afectó al 15% de los casos.

A continuación, se proporcionan pasos de solución de problemas específicos para ayudarte a localizar el problema rápidamente.

Revisa el “Informe de Cobertura” de GSC

Ve a ”Cobertura” en el menú izquierdo de GSC para ver si hay mensajes de error (como “Enviada pero no indexada” o “Excluida”). Por ejemplo, si el estado de una página se muestra como ”Enviada, pero no indexada”, es posible que Googlebot no haya podido rastrearla correctamente. En este momento, debes verificar:

- Si robots.txt permite el rastreo (visita

example.com/robots.txtpara confirmar que no hay reglas deDisallowque bloqueen accidentalmente). - Si la página tiene configurada incorrectamente la etiqueta noindex (verifica

noindexen el HTML o en la cabecera de respuesta HTTP). - Si los registros del servidor muestran que Googlebot accede con frecuencia, pero devuelve errores 4xx/5xx (como 404 o 503).

Prueba manualmente el estado de rastreo de la URL

Utiliza la ”Herramienta de inspección de URL” de GSC (ingresa la URL específica) para ver el último resultado de rastreo de Google. Por ejemplo:

- Si la herramienta muestra ”La URL no está en Google”, significa que la página no está indexada y debes enviarla para su revisión.

- Si muestra ”Error de rastreo” (como “Tiempo de espera del servidor” o “Cadena de redirección demasiado larga”), debes optimizar la velocidad de respuesta del servidor (controlarla en <2 segundos) o simplificar la ruta de redirección.

Verifica si el sitemap se ha enviado correctamente

En el ”Informe de Sitemaps” de GSC, verifica:

- Si el tiempo de envío del sitemap no se ha actualizado en más de 7 días (Google suele leer el sitemap cada 1-3 días).

- Si el número de URL en el sitemap coincide con el número real de páginas del sitio web (si el sitemap enumera un 50% o más de URL menos de las reales, es posible que se hayan omitido páginas clave).

- Si el formato del sitemap es correcto (por ejemplo, la estructura XML no tiene errores, no hay URL duplicadas).

Compara los datos con herramientas de SEO de terceros

Si los datos de GSC se estancan, pero las herramientas de terceros (como Ahrefs o SEMrush) muestran fluctuaciones en la clasificación, es posible que el volumen de búsqueda de la palabra clave sea demasiado bajo para que GSC la actualice. Por ejemplo:

- Si una palabra clave tiene una clasificación en Ahrefs, pero no hay datos en GSC, generalmente significa que su volumen de búsqueda mensual es <10 veces.

- En este caso, puedes priorizar la optimización de palabras clave con un volumen de búsqueda >100 veces o utilizar el “Planificador de palabras clave” de Google Ads para verificar el volumen de búsqueda real.

Revisa la propiedad y los permisos del sitio web

- Ve a “Configuración” > “Verificación de propiedad” en GSC y confirma que el estado de verificación no ha caducado (por ejemplo, que los registros DNS no han expirado).

- Si usas varias cuentas de GSC (como a nivel de dominio y de prefijo de URL), verifica si los datos están dispersos en diferentes cuentas.

Métodos para mantener la precisión de los datos de clasificación a largo plazo

Los sitios web que actualizan contenido regularmente tienen una frecuencia de actualización de datos de clasificación 47% más alta que los sitios que no se actualizan durante mucho tiempo, y los sitios web con SEO técnico optimizado reducen los problemas de retraso de datos en un 35%. Por ejemplo, un estudio de 500 sitios web mostró que la actualización de al menos el 30% del contenido antiguo cada mes acortó el ciclo de actualización de datos de clasificación de GSC a un promedio de 2-3 días, mientras que los sitios no optimizados podían estancarse por más de 7 días.

Aquí se ofrecen métodos específicos para garantizar que los datos de clasificación sean precisos a largo plazo.

Actualiza el contenido regularmente para mantener la actividad de la página

Google tiende a rastrear y actualizar con más frecuencia los sitios web con contenido activo. Por ejemplo:

- Actualizar al menos el 20%-30% del contenido antiguo cada mes (como agregar nuevos datos, optimizar títulos y descripciones) puede aumentar la frecuencia de rastreo de Googlebot en un 40%.

- Las páginas con nuevos enlaces externos de alta calidad suelen actualizarse un 25% más rápido que las páginas sin enlaces externos (porque Google da más importancia al contenido citado).

- Para las páginas que no han cambiado durante mucho tiempo, puedes agregar una etiqueta de “última modificación” (

<meta name="last-modified" content="2024-07-01">) para ayudar a Google a identificar la frescura del contenido.

Optimiza la estructura técnica del sitio web para reducir las barreras de rastreo

Los problemas técnicos afectarán directamente la eficiencia del rastreo de Googlebot, lo que provocará retrasos en los datos:

- Asegúrate de que el tiempo de respuesta del servidor sea <1.5 segundos (la frecuencia de rastreo de las páginas que superan los 2 segundos disminuye en un 30%).

- Reduce los saltos complejos (como cadenas de redirección que superan las 3 veces, lo que puede hacer que Googlebot abandone el rastreo).

- Utiliza una estructura de URL estandarizada (evita múltiples versiones de URL para el mismo contenido, como

example.com/pageyexample.com/page/?utm=test). - Revisa regularmente los robots.txt y las etiquetas noindex para evitar bloquear accidentalmente páginas importantes.

Envía y mantén el sitemap para guiar a Google en el rastreo

- Revisa el estado de envío del sitemap semanalmente para asegurarte de que Google haya leído correctamente la última versión (puedes verificar la última fecha de lectura en el “Informe de Sitemaps” de GSC).

- Prioriza el envío de páginas de alta prioridad (como páginas de productos principales o artículos de alto tráfico) y etiqueta

<priority>en el sitemap (rango 0.1-1.0). - Genera un sitemap dinámicamente (como con un complemento de WordPress de actualización automática) para evitar la omisión de nuevas páginas al actualizar manualmente.

Monitorea y repara problemas de indexación

- Revisa el “Informe de Cobertura” de GSC semanalmente para resolver las páginas con “errores” o “advertencias” (como 404, 404 suave o errores del servidor).

- Para las páginas no indexadas, usa la “Herramienta de inspección de URL” para enviarlas manualmente y verifica si se filtran debido a la baja calidad del contenido (como contenido duplicado o relleno de palabras clave).

- Revisa regularmente la cobertura de indexación (“Índice” > “Páginas” en GSC) para asegurarte de que el porcentaje de páginas válidas sea >90% (un porcentaje inferior puede significar problemas de rastreo o de contenido).

Verifica los datos de forma cruzada para evitar depender de una sola fuente

- Combina los datos con herramientas de terceros (como Ahrefs o SEMrush) para comparar la clasificación, especialmente para palabras clave de bajo volumen de búsqueda (<10 veces/mes).

- A través de Google Analytics (GA4), verifica las tendencias de tráfico de búsqueda orgánica; si la clasificación de GSC sube, pero el tráfico no aumenta, puede ser un problema de fluctuación de la clasificación o de la tasa de clics (CTR).

- Prueba periódicamente la clasificación real de las palabras clave (como búsquedas manuales o usando una herramienta de seguimiento de clasificación) para verificar la precisión de los datos de GSC.

Si encuentras problemas que no puedes resolver, puedes buscar ayuda a través de los canales de soporte oficial de Google.