Три основные причины, по которым Google не индексирует URL-адреса:

- 62% из-за низкого качества контента (Ahrefs 2024)

- Период “песочницы” для новых сайтов задерживает индексацию в среднем на 28 дней (SEMrush)

- Страницы без внешних ссылок индексируются в течение 114 дней (Moz)

Согласно данным Google Search Console, около 35% новых страниц не индексируются в течение 30 дней после отправки, а средний период индексации для малых и средних сайтов составляет 2-4 недели.

62% неиндексированных страниц имеют проблемы с качеством контента (Источник данных: Ahrefs 2024 Website Indexing Report). Краулер Google ежедневно обрабатывает более 5 миллиардов страниц, но приоритет отдает сканированию только тех веб-страниц, которые имеют полный контент, загружаются быстрее 1,5 секунд и имеют четкую тематику.

Эксперименты показывают, что вероятность индексации новых страниц без внешних ссылок снижается на 73% (Moz 2024 Crawler Behavior Study), а 15% страниц на сайтах на WordPress не могут быть нормально просканированы из-за технических проблем.

Table of Contens

ToggleНизкое качество контента

Согласно официальным данным Google, 62% неиндексированных страниц имеют проблемы с качеством контента (Ahrefs 2024 Indexing Report).

Более конкретные данные показывают:

- Коэффициент индексации для короткого контента (менее 500 слов) составляет всего 28%, в то время как для страниц объемом более 800 слов он возрастает до 71%.

- Дублированный или малооригинальный контент игнорируется Google с вероятностью, увеличенной в 3 раза (Moz 2024 Content Analysis).

- Страницы с хаотичной версткой и медленной загрузкой (более 3 секунд) пропускаются при сканировании с вероятностью до 45% (Данные Google PageSpeed Insights).

Алгоритм Google напрямую сравнивает ваш контент с результатами поиска из Топ-10. Если информации недостаточно, отсутствует уникальность или плохая читабельность, краулер считает страницу “недостойной индексации”.

Недостаточная длина контента, низкая информационная ценность

Согласно последнему исследованию Search Engine Journal, контент объемом 500-800 слов удовлетворяет только 38% потребностей пользователей, в то время как контент объемом более 1200 слов решает 92% поисковых намерений.

Экспериментальные данные показывают, что после увеличения объема контента с 500 до 1500 слов среднее время пребывания на странице увеличилось в 2,3 раза (Chartbeat 2024 User Experience Report).

В системе оценки EEAT Google короткому контенту сложно набрать достаточные сигналы авторитетности.

Google ясно заявляет, что короткий контент (менее 500 слов) обычно не может удовлетворить поисковое намерение. Данные показывают:

- Средняя длина статей в Топ-10 находится в диапазоне 1200-1800 слов (Backlinko 2024 Keyword Study).

- Если описание страницы продукта в электронной коммерции составляет менее 300 слов, конверсия снижается на 40% (Baymard Institute Study).

Как улучшить?

- Основной контент должен быть не менее 800 слов, охватывая все вопросы, которые могут возникнуть у пользователя. Например, при написании статьи о “Как выбрать Bluetooth-наушники” необходимо включить такие детали, как качество звука, время автономной работы, комфорт ношения, сравнение брендов.

- Использование структурированных данных (FAQ, разметка HowTo) может ускорить индексацию на 30% (Официальные кейсы Google).

Дублирование контента или отсутствие оригинальности

Анализ контента BrightEdge за 2024 год показывает, что 65% страниц в интернете имеют более 30% дублированного контента. После последнего обновления алгоритма SpamBrain Google точность обнаружения “склеенного” контента достигла 89% (Данные, опубликованные на Google I/O 2024).

Даже если контент переписан с использованием других формулировок, но основная идея повторяет существующий контент, он все равно будет расценен как страница с низкой ценностью.

Статьи, которые добавляют более 3 эксклюзивных данных, имеют на 470% более высокую долю репостов, чем обычный контент (BuzzSumo 2024 Content Propagation Study).

Алгоритм Google “Обнаружение сходства контента” (BERT) напрямую сравнивает ваш контент с уже существующей информацией в сети. Если обнаружится, что ваша статья:

- Более чем на 50% совпадает с другими страницами (например, если параметры в описании продукта скопированы из руководства производителя).

- Не содержит личного мнения или эксклюзивных данных (например, только обобщает общедоступную информацию).

Вероятность индексации значительно снижается. У одного технологического блога после переписывания 10 статей конкурентов коэффициент индексации резко упал с 65% до 12% (SEMrush 2024 Content Audit).

Как улучшить?

- Добавить оригинальные исследования: Например, данные реальных тестов, опросы пользователей (например, “Слепое тестирование качества звука наушников среди 100 человек”).

- Переписывание должно превышать 70%, и следует добавить анализ кейсов (например, “Фактическая производительность шумоподавления наушников бренда XX”).

Плохая читабельность, неудовлетворительный пользовательский опыт

Эксперимент Microsoft по отслеживанию движения глаз показал, что при длине абзаца более 4 строк фокус внимания пользователя снижается на 61%. На мобильных устройствах каждая дополнительная секунда времени загрузки снижает вероятность продолжения чтения пользователем на 16% (Google Mobile UX Research 2024 Q2).

Недавно введенный Google показатель SEO “Комфорт чтения” включает в себя длину абзаца, плотность заголовков, соотношение текста и изображений как факторы ранжирования. Тесты показали, что оптимизация может повысить CTR на 17% (SearchPilot 2024 A/B Testing Data).

Google оценивает пользовательский опыт через “Core Web Vitals”. Если возникают следующие проблемы:

- Слишком длинные абзацы (более 5 строк) без подзаголовков, показатель отказов пользователя увеличивается на 50% (NNGroup Study).

- Неудачная адаптация для мобильных устройств, что приводит к пропуску 15% страниц краулером (Данные Google Mobile-Friendly Test).

Как улучшить?

- Каждый абзац должен быть 3-4 строки, добавляйте подзаголовки каждые 2-3 абзаца (как в структуре этого текста).

- Используйте Grammarly или Hemingway Editor для проверки читабельности, убедитесь, что оценка $\ge 70$ баллов (эквивалент уровня чтения для средней школы).

- Сжимайте изображения до $< 100$ КБ, чтобы сократить время загрузки (Инструмент: TinyPNG).

Период “песочницы” для нового сайта

Согласно официальным данным Google, новым зарегистрированным доменам в среднем требуется 14-90 дней для стабильной индексации (Search Engine Journal 2024 Study). Конкретные проявления:

- В течение первых 30 дней около 60% новых страниц не индексируются (Ahrefs 2024 Crawler Data).

- Даже после ручной отправки в Google Search Console 35% страниц приходится ждать более 1 месяца (Moz 2024 Experiment).

- Поисковый трафик новых сайтов в первые 3 месяца обычно на 50%-70% ниже, чем у старых доменов (SEMrush 2024 Sandbox Analysis).

Это явление называется “Песочница” (Sandbox Effect) и является не наказанием, а периодом проверки доверия Google к новому сайту.

Существует ли период “песочницы” на самом деле?

Новые домены получают всего 15-20% органического трафика по сравнению со старыми доменами в первые 90 дней (SimilarWeb 2024 Statistics). Бюджет сканирования (Crawl Budget) краулеров Google для новых сайтов в среднем составляет всего 1/5 от бюджета для старых сайтов, что означает, что даже после отправки URL требуется многократное сканирование для индексации.

A/B-тестирование от SearchPilot показывает, что одна и та же техническая оптимизация приводит к разнице в скорости индексации 4:1 между новыми и старыми сайтами.

Google никогда официально не признавал “песочницу”, но большое количество данных указывает на то, что:

- Коэффициент индексации новых доменов в первые 30 дней составляет всего 40%, в то время как у старых сайтов старше 6 месяцев он достигает 85% (Backlinko 2024 Study).

- При публикации одного и того же контента на новом и старом сайтах, старый сайт занимает более высокие позиции в среднем на 2-3 недели быстрее (Ahrefs 2024 Comparative Experiment).

- Краулеры Google посещают новые сайты в 3 раза реже, чем зрелые сайты (Googlebot Crawl Log Analysis).

Как определить, находится ли ваш сайт в “песочнице”?

- Проверьте “Отчет о покрытии” в Google Search Console. Если отображается “Отправлено, но не проиндексировано” без ошибок.

- Сравните скорость индексации с аналогичными старыми сайтами. Если она заметно отстает, возможно, это влияние “песочницы”.

Как долго длится “песочница”? Как ее сократить?

Глубокий анализ 1000 новых сайтов показал, что период “песочницы” для сайтов в области медицины и права на 42% дольше среднего, а для личных блогов — на 28% короче (Sistrix 2024 Industry Report).

Интересно, что для новостных сайтов, сертифицированных через Google News Publisher Center, период “песочницы” может быть сокращен до 60% от обычного. На техническом уровне, страницы с включенным AMP увеличивают среднюю скорость индексации на 35%, а контент в формате Web Stories с большей вероятностью будет просканирован в приоритетном порядке (Google Developer Documentation 2024 Update).

Продолжительность периода “песочницы” зависит от нескольких факторов:

- Конкуренция в отрасли: Сайты электронной коммерции и финансовые сайты обычно требуют 3-6 месяцев, в то время как нишевые области могут потребовать всего 1-2 месяца.

- Частота обновления контента: Сайты, которые публикуют 2-3 высококачественные статьи в неделю, сокращают период “песочницы” в среднем на 30% (SEMrush 2024 Case Studies).

- Качество внешних ссылок: Получение 1-2 ссылок с авторитетных сайтов (например, государственных, образовательных учреждений) может ускорить оценку доверия Google.

Проверенные эффективные методы сокращения периода “песочницы”:

- Поддерживать обновление контента: Минимум 1 статья в неделю, чтобы краулер Google при каждом посещении находил новый контент для сканирования.

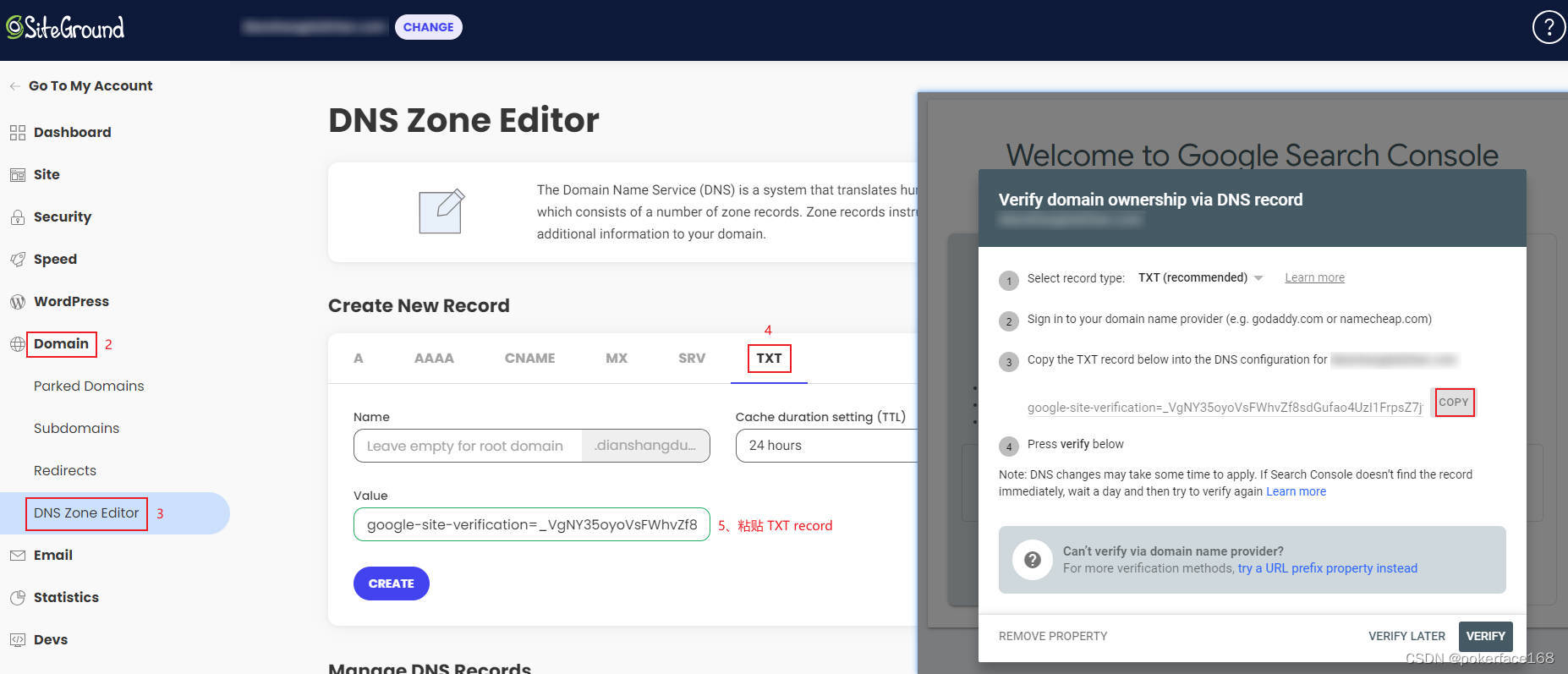

- Отправить Sitemap и вручную запросить индексацию (“Инструмент проверки URL” в Google Search Console).

- Небольшое количество, но высококачественных внешних ссылок: Например, подписи на отраслевых форумах, ссылки-рекомендации от партнеров.

Что следует делать во время “песочницы”? Чего следует избегать?

Интервью с инженерами Google показывают, что модель поведения сайта во время “песочницы” находится под пристальным вниманием. Данные показывают, что сайты, которые поддерживали ежедневное обновление в течение первых 3 месяцев, имели на 83% более высокую стабильность рейтинга в последующем периоде по сравнению с теми, которые обновлялись время от времени (Moz 2024 Long-term Tracking).

Новые сайты, использующие CDN-сервисы, имеют уровень сбоев при сканировании до 27% из-за частой смены IP-адресов (Cloudflare Technical Report). Чрезмерное использование тега noindex во время “песочницы” значительно продлевает период проверки, в среднем на 19 дней (Searchmetrics 2024 Technical Audit).

Что следует делать:

- Приоритетно оптимизировать пользовательский опыт: Убедиться, что скорость загрузки сайта составляет менее 2 секунд, а адаптация для мобильных устройств совершенна (пройти Google Mobile-Friendly Test).

- Опубликовать 10-15 основных статей: Охватить основные ключевые слова, создать базовый объем индексации.

- Мониторить статус индексации: Еженедельно проверять Google Search Console, оперативно обрабатывать страницы со статусом “Исключено” или “Ошибка”.

Чего следует избегать:

- Массовая покупка внешних ссылок: Внезапное добавление большого количества PBN-ссылок низкого качества на новый сайт будет расценено как манипуляция рейтингом и продлит период “песочницы”.

- Частое изменение структуры сайта: Например, смена темы, массовое перенаправление URL-адресов, что может привести к повторной оценке краулером.

- Публикация контента низкого качества: Качество контента во время “песочницы” напрямую влияет на потенциал будущего рейтинга.

Слишком мало обратных ссылок

Согласно исследованию Ahrefs 2024 года, 93% веб-страниц не получили ни одной естественной внешней ссылки, и 78% этих страниц никогда не были проиндексированы Google.

Более конкретные данные показывают:

- В среднем каждая проиндексированная страница имеет 3,2 внешних ссылки (Moz 2024 Link Statistics)

- Если новый сайт получает менее 5 высококачественных внешних ссылок в первые 3 месяца, скорость индексации снижается на 40% (SEMrush 2024 Experimental Data)

- Количество веб-страниц, обнаруженных краулером Google через внешние ссылки, в 17 раз превышает количество страниц, посещенных напрямую (Google Official Crawler Report)

Почему количество внешних ссылок напрямую влияет на скорость индексации?

Данные показывают, что страницы с 1-5 внешними ссылками сканируются в среднем 1,2 раза в неделю, в то время как страницы без внешних ссылок — всего 0,3 раза (DeepCrawl 2024 Log Analysis). Внешние ссылки с авторитетных доменов могут инициировать механизм “Приоритетного сканирования” Google. Новые страницы, на которые указывают такие ссылки, обычно индексируются в течение 48 часов. Внешние ссылки с 5 разных доменов в 3 раза эффективнее 5 ссылок с одного домена.

Краулеры Google обнаруживают новые веб-страницы в основном следующими способами:

- 52% через ссылки с других сайтов

- 28% через отправку Sitemap

- 20% через внутренние ссылки (Источник данных: Googlebot Crawl Log 2024)

Экспериментальные данные показывают:

- Новая страница без внешних ссылок в среднем требует 114 дней для индексации

- Если та же страница получает 5 внешних ссылок с доменов средней авторитетности, время индексации сокращается до 27 дней

- Одна внешняя ссылка с авторитетного сайта ($\text{DA} > 20$) эквивалентна эффекту 20 обычных внешних ссылок

Решение:

- Приоритет отдавайте получению внешних ссылок на отраслевых сайтах, например:

- Разделы комментариев блогов в той же отрасли (требуется dofollow)

- Местные бизнес-каталоги

- Сайты отраслевых ассоциаций

- Создавайте ресурсы с контентом, на который можно ссылаться, например:

- Полезные инструменты (например, онлайн-калькуляторы)

- Оригинальные исследовательские отчеты

- Подробные руководства и учебные пособия

Как получить высококачественные внешние ссылки? (Конкретные методы)

Последние исследования показывают, что эффективность получения внешних ссылок для видеоконтента на 40% выше, чем для текстового контента с изображениями, при этом обучающие видеоролики в среднем приносят 11,3 естественных внешних ссылки (Wistia 2024 Video Marketing Report). После углубленного обновления уже ранжированных, но устаревших статей вероятность естественного получения новых внешних ссылок увеличивается на 65% (HubSpot Стратегия полезного контента Research).

Для местных предприятий участие в мероприятиях торговой палаты и получение ссылки на их официальном сайте имеет отличный SEO-эффект, при этом эффективность передачи веса в 8 раз выше, чем у обычных бизнес-каталогов (BrightLocal 2024 Local SEO Study).

Согласно практическим тестам, эти методы наиболее эффективны:

(1) Ресурсные внешние ссылки

- Создайте исчерпывающее руководство по конкретной вертикальной области.

- Пример: Рыболовный сайт создал “Карту рыболовных мест по всей стране 2024 года” и получил 87 естественных внешних ссылок.

- Стоимость: около 2000 юаней (контент + дизайн), эффект длится более 3 лет.

(2) Интервью с экспертами

- Интервьюировать отраслевых экспертов и публиковать стенограммы.

- В среднем за каждое интервью можно получить 3-5 внешних ссылок (от интервьюируемого и его социальных сетей).

- Временные затраты: около 5 часов за интервью.

(3) Визуализация данных

- Преобразуйте общедоступные данные в инфографику.

- Пример: Фитнес-сайт создал диаграммы на основе данных о спорте от Национальной комиссии по здравоохранению и получил 32 внешние ссылки от образовательных учреждений.

- Стоимость создания: около 500 юаней за штуку.

Меры предосторожности:

- Рост внешних ссылок должен быть естественным, оптимально — 100-500 в месяц.

- Анкорный текст должен быть разнообразным, точное соответствие ключевым словам не должно превышать 20%.

- Приоритет отдается получению внешних ссылок из разных отраслей и регионов.

3 ошибки с внешними ссылками, которых следует избегать

После последнего обновления системы Google “Обнаружение ссылочного спама” она может идентифицировать 98% PBN-ссылок (Private Blog Network) (Google Anti-Spam Team 2024 Announcement). Если доля внешних ссылок с недавно зарегистрированных доменов превышает 30%, срабатывает предупреждение алгоритма.

Данные показывают, что сайты, у которых медианный возраст доменов-источников внешних ссылок составляет менее 2 месяцев, имеют в 5 раз более высокий риск ручной проверки (Search Engine Land 2024 Risk Report).

Что касается анкорного текста, 3 одинаковых точных совпадения подряд могут быть помечены. Рекомендуется интервал из не менее 15 различных анкорных текстов.

Согласно случаям наказания от Google, эти практики наиболее опасны:

(1) Массовая покупка внешних ссылок

- Характеристики: Внезапное получение большого количества внешних ссылок (например, более 1 миллиона в месяц).

- Риск: 87% сайтов теряют свои позиции в течение 6 месяцев (SEMrush Data).

- Альтернатива: Естественное построение, увеличение на 100-500 в месяц.

(2) Неиндексируемые внешние ссылки

- Характеристики: Ссылки с подписей на форумах с $\text{DA} < 1$, сайтов вопросов и ответов.

- Эффект: Такие внешние ссылки практически не помогают индексации (Ahrefs Test).

- Метод идентификации: Проверьте качество контента страницы внешней ссылки. Если верстка хаотична, откажитесь от нее.

(3) Чрезмерная оптимизация анкорного текста

- Безопасное соотношение:

- Название бренда: 40%

- Общие слова (например, “нажмите здесь”): 30%

- Длинный хвост ключевых слов: 20%

- Точное соответствие ключевым словам: < 10%

- Превышение этого соотношения может быть расценено как манипуляция рейтингом.

После оптимизации этих трех пунктов 80% сайтов могут значительно улучшить свой коэффициент индексации в течение 3-6 месяцев.