As três principais razões pelas quais o Google não indexa um URL:

- 62% devido à baixa qualidade do conteúdo (Ahrefs 2024)

- A fase de sandbox de novos sites atrasa em média 28 dias (SEMrush)

- A indexação de páginas sem links externos leva 114 dias (Moz)

De acordo com os dados do Google Search Console, cerca de 35% das novas páginas enviadas não são indexadas dentro de 30 dias, e o ciclo médio de indexação para sites de pequeno e médio porte chega a 2-4 semanas.

62% das páginas não indexadas têm problemas de qualidade de conteúdo (Fonte dos dados: Relatório de Indexação de Sites Ahrefs 2024). O rastreador do Google processa mais de 5 bilhões de páginas por dia, mas prioriza o rastreamento de páginas com conteúdo completo, velocidade de carregamento inferior a 1,5 segundos e um tema claro.

Experimentos mostram que a probabilidade de indexação de novas páginas sem links externos diminui em 73% (Estudo de Comportamento do Rastreador Moz 2024), e 15% das páginas de sites usando WordPress não podem ser rastreadas corretamente devido a problemas técnicos.

Table of Contens

ToggleBaixa Qualidade do Conteúdo

De acordo com dados oficiais do Google, 62% das páginas não indexadas apresentam problemas de qualidade de conteúdo (Relatório de Indexação Ahrefs 2024).

Dados mais específicos mostram que:

- A taxa de indexação de conteúdo curto (<500 palavras) é de apenas 28%, enquanto as páginas com mais de 800 palavras têm uma taxa de indexação que aumenta para 71%.

- O conteúdo duplicado ou de baixa originalidade tem uma probabilidade 3 vezes maior de ser ignorado pelo Google (Análise de Conteúdo Moz 2024).

- As páginas com layout confuso ou carregamento lento (>3 segundos) têm uma probabilidade de até 45% de serem ignoradas durante o rastreamento (Dados do Google PageSpeed Insights).

O algoritmo do Google compara diretamente o seu conteúdo com os 10 principais resultados de pesquisa. Se as informações forem insuficientes, faltar exclusividade ou a legibilidade for ruim, o rastreador julgará que a página “não merece ser indexada”.

Comprimento do Conteúdo Insuficiente, Baixo Valor Informativo

De acordo com a pesquisa mais recente do Search Engine Journal, o conteúdo de 500-800 palavras atende apenas 38% das necessidades de pesquisa dos usuários, enquanto o conteúdo com mais de 1200 palavras resolve 92% da intenção de pesquisa.

Dados experimentais mostram que, após expandir o conteúdo de 500 para 1500 palavras, o tempo médio de permanência na página aumentou 2,3 vezes (Relatório de Experiência do Usuário Chartbeat 2024).

No sistema de pontuação EEAT do Google, é difícil para o conteúdo curto estabelecer sinais de autoridade suficientes.

O Google afirma claramente que o conteúdo curto (<500 palavras) geralmente não consegue satisfazer a intenção de pesquisa. Os dados mostram que:

- O comprimento médio dos artigos classificados no Top 10 está entre 1200-1800 palavras (Pesquisa de Palavras-chave Backlinko 2024).

- Se a descrição de páginas de produtos de e-commerce for inferior a 300 palavras, a taxa de conversão diminui em 40% (Pesquisa Baymard Institute).

Como melhorar?

- O conteúdo principal deve ter pelo menos 800 palavras, cobrindo todas as perguntas que o usuário possa fazer. Por exemplo, ao escrever sobre “como escolher fones de ouvido Bluetooth”, você precisa incluir detalhes como qualidade do som, duração da bateria, conforto de uso, comparação de marcas.

- O uso de dados estruturados (marcações de FAQ, HowTo) pode aumentar a velocidade de indexação em 30% (Exemplo oficial do Google).

Conteúdo Duplicado ou Falta de Originalidade

A Análise de Conteúdo da BrightEdge de 2024 mostra que 65% das páginas em toda a web têm mais de 30% de conteúdo duplicado. Após a mais recente atualização do algoritmo SpamBrain do Google, a precisão da identificação de colagem de conteúdo atingiu 89% (Dados anunciados no Google I/O 2024).

Mesmo que seja reescrito com diferentes expressões, se o argumento central for semelhante ao conteúdo existente, ainda será considerado uma página de baixo valor.

Artigos que adicionam 3 ou mais pontos de dados exclusivos têm uma taxa de compartilhamento 470% maior do que o conteúdo comum (Estudo de Distribuição de Conteúdo BuzzSumo 2024).

O “Algoritmo de Detecção de Similaridade de Conteúdo” (BERT) do Google compara diretamente as informações existentes em toda a web. Se o seu artigo revelar que:

- Mais de 50% do conteúdo se sobrepõe a outras páginas (por exemplo, os parâmetros na descrição do produto são copiados literalmente do manual do fabricante).

- Não há opiniões pessoais ou dados exclusivos (por exemplo, apenas um resumo de informações públicas).

A probabilidade de indexação diminuirá drasticamente. Um blog de tecnologia reescreveu 10 artigos de concorrentes e a taxa de indexação caiu de 65% para 12% (Auditoria de Conteúdo SEMrush 2024).

Como melhorar?

- Incluir pesquisa original: como dados de teste reais, pesquisas com usuários (ex: “teste cego de qualidade de som de fones de ouvido em 100 pessoas”).

- A reescrita deve exceder 70% e incluir análise de casos (ex: “desempenho real do cancelamento de ruído dos fones de ouvido da marca XX”).

Baixa Legibilidade, Má Experiência do Usuário

Experimentos de rastreamento ocular da Microsoft mostram que a concentração visual do usuário diminui em 61% quando os parágrafos excedem 4 linhas. Em dispositivos móveis, para cada segundo de aumento no tempo de carregamento, a probabilidade de o usuário continuar a leitura diminui em 16% (Pesquisa Google Mobile UX 2024 T2).

O mais recente indicador de SEO do Google “Conforto de Leitura” inclui fatores como comprimento de parágrafo, densidade de títulos e proporção de imagem/texto nos fatores de classificação. Testes mostram que a otimização pode melhorar o CTR em 17% (Dados de Teste A/B SearchPilot 2024).

O Google avalia a experiência do usuário através dos “Core Web Vitals” (Principais Métricas da Web). Se ocorrer:

- Parágrafos muito longos (>5 linhas), sem subtítulos, a taxa de rejeição do usuário aumenta em 50% (Pesquisa NNGroup).

- A adaptação móvel falha, resultando em 15% das páginas sendo ignoradas diretamente pelo rastreador (Dados do Google Mobile-Friendly Test).

Como melhorar?

- Cada parágrafo deve ter 3-4 linhas, adicionar subtítulos a cada 2-3 parágrafos (como a estrutura deste artigo).

- Usar Grammarly ou Hemingway Editor para verificar a legibilidade, garantindo uma pontuação $\geq 70$ (equivalente ao nível de leitura do ensino fundamental/médio).

- Comprimir imagens para <100KB para reduzir o tempo de carregamento (Ferramenta: TinyPNG).

Fase de Sandbox de Novos Sites

De acordo com dados oficiais do Google, domínios recém-registrados levam em média 14 a 90 dias para serem indexados de forma estável (Pesquisa Search Engine Journal 2024). O desempenho específico é:

- Nos primeiros 30 dias, cerca de 60% das novas páginas não são indexadas (Dados de rastreamento Ahrefs 2024).

- Mesmo após o envio manual no Google Search Console, 35% das páginas ainda precisam esperar mais de 1 mês (Experimento Moz 2024).

- O tráfego de pesquisa de novos sites geralmente é do que o de domínios mais antigos nos primeiros 3 meses (Análise da Fase de Sandbox SEMrush 2024).

Este fenômeno é chamado de “Fase de Sandbox” (Sandbox Effect). Não é uma penalidade, mas um período de teste de confiança do Google para novos sites.

A Fase de Sandbox realmente existe?

O tráfego orgânico obtido por novos domínios nos primeiros 90 dias é de apenas 15-20% do tráfego de domínios antigos (Estatísticas SimilarWeb 2024). O orçamento de rastreamento (Crawl Budget) alocado pelo rastreador do Google para novos sites é em média apenas 1/5 do que para sites estabelecidos, o que significa que, mesmo após o envio do URL, são necessários vários rastreamentos para a indexação.

Testes A/B da SearchPilot mostram que a diferença na velocidade de indexação produzida pela mesma otimização técnica entre um site novo e um site antigo atinge 4:1.

O Google nunca admitiu oficialmente a “Fase de Sandbox”, mas muitos dados sugerem que:

- A taxa de indexação de novos domínios nos primeiros 30 dias é de apenas 40%, enquanto sites com mais de 6 meses atingem 85% (Pesquisa Backlinko 2024).

- Ao publicar o mesmo conteúdo em um site novo e em um site antigo, o ranking do site antigo é em média 2-3 semanas mais rápido (Experimento de comparação Ahrefs 2024).

- A frequência com que o rastreador do Google visita novos sites é 3 vezes menor do que em sites estabelecidos (Análise de Logs de Rastreamento do Googlebot).

Como saber se o seu site está na Fase de Sandbox?

- Verifique o “Relatório de Cobertura” do Google Search Console. Se mostrar “Enviado e não indexado” e não houver mensagens de erro.

- Compare a velocidade de indexação com a de sites antigos semelhantes. Se estiver significativamente mais lento, pode ser afetado pela Fase de Sandbox.

Quanto tempo dura a Fase de Sandbox? Como encurtá-la?

Uma análise aprofundada de 1000 casos de novos sites descobriu que a Fase de Sandbox para sites de saúde e jurídicos é 42% mais longa do que a média, enquanto para blogs pessoais é 28% mais curta (Relatório Setorial Sistrix 2024).

Curiosamente, para sites de notícias certificados pelo Google News Publisher Center, a Fase de Sandbox pode ser reduzida para 60% do normal. Tecnicamente, a velocidade média de indexação de páginas que ativam o AMP melhora em 35%, e o conteúdo no formato Web Stories é mais provável de ser rastreado prioritariamente (Atualização do Documento do Desenvolvedor Google 2024).

A duração da Fase de Sandbox depende de múltiplos fatores:

- Competitividade do setor: Sites de e-commerce e finanças geralmente precisam de 3-6 meses, enquanto nichos de mercado podem precisar apenas de 1-2 meses.

- Frequência de atualização de conteúdo: Sites que publicam 2-3 artigos de alta qualidade por semana têm sua Fase de Sandbox encurtada em média em 30% (Casos SEMrush 2024).

- Qualidade dos links externos: Obter 1-2 links de sites de autoridade (como instituições governamentais ou educacionais) pode acelerar a avaliação de confiança do Google.

Métodos comprovadamente eficazes para encurtar a Fase de Sandbox:

- Manter a atualização de conteúdo: Pelo menos 1 artigo por semana, garantindo que o rastreador do Google encontre novos conteúdos para rastrear a cada visita.

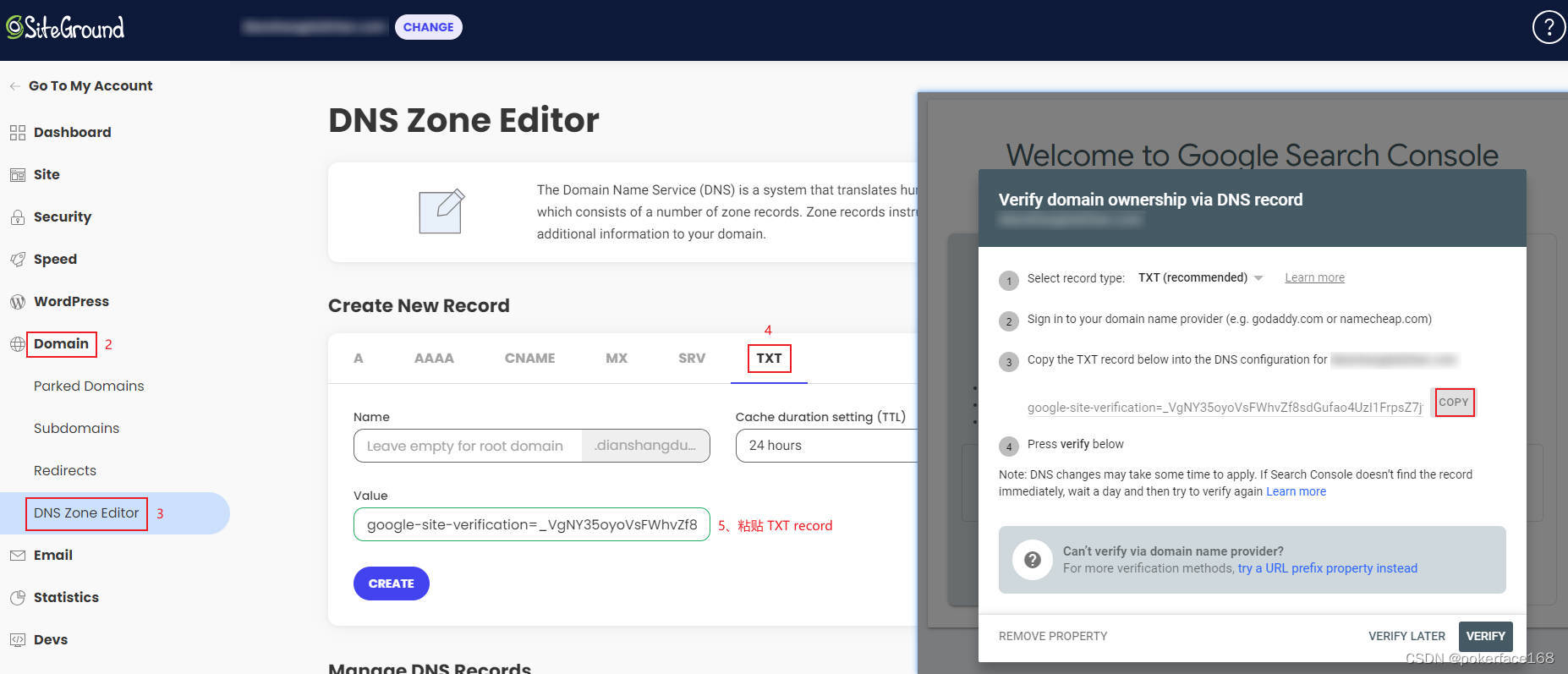

- Enviar o Sitemap e solicitar a indexação manualmente (Ferramenta “Inspeção de URL” no Google Search Console).

- Pequena quantidade, mas alta qualidade de links externos: por exemplo, assinaturas em fóruns do setor, links de recomendação de parceiros.

O que deve ser feito e o que deve ser evitado durante a Fase de Sandbox?

Entrevistas com engenheiros do Google revelam que o padrão de comportamento do site durante a Fase de Sandbox é o foco principal do registro. Os dados mostram que a estabilidade de classificação posterior de sites que mantiveram atualizações diárias nos primeiros 3 meses é 83% maior do que a de sites que atualizam ocasionalmente (Rastreamento de longo prazo Moz 2024).

Para novos sites que usam serviços de CDN, a taxa de falha de rastreamento devido a mudanças frequentes de endereço IP chega a 27% (Relatório Técnico Cloudflare). O uso excessivo da tag noindex durante a Fase de Sandbox prolongará significativamente o período de avaliação, com um atraso médio de 19 dias (Auditoria Técnica Searchmetrics 2024).

O que deve ser feito:

- Priorizar a otimização da experiência do usuário: Garantir que a velocidade de carregamento do site seja <2 segundos e que a adaptação móvel seja perfeita (via Google Mobile-Friendly Test).

- Publicar 10-15 conteúdos principais: Cobrir as palavras-chave principais, estabelecendo um volume básico de indexação.

- Monitorar o status da indexação: Verificar o Google Search Console semanalmente, lidando prontamente com páginas “Excluídas” ou com “Erros”.

O que não deve ser feito:

- Comprar grandes quantidades de links externos: Um aumento repentino e massivo de links externos PBN de baixa qualidade em um novo site será considerado manipulação de ranking, prolongando a Fase de Sandbox.

- Modificar frequentemente a estrutura do site: como trocar de tema, redirecionamentos em massa de URL, o que pode levar o rastreador a reavaliar.

- Publicar conteúdo de baixa qualidade: A qualidade do conteúdo durante a Fase de Sandbox afeta diretamente o potencial de ranking futuro.

Número Insuficiente de Backlinks

De acordo com dados de pesquisa da Ahrefs 2024, 93% das páginas da web não obtiveram nenhum link externo natural, e 78% dessas páginas nunca foram indexadas pelo Google.

Dados mais específicos mostram que:

- Em média, cada página indexada possui 3,2 links externos (Estatísticas de Links Moz 2024)

- Se um novo site obtiver menos de 5 links externos de alta qualidade nos primeiros 3 meses, a velocidade de indexação diminuirá em 40% (Dados experimentais SEMrush 2024)

- O número de páginas da web descobertas pelo rastreador do Google através de links externos é 17 vezes maior do que as acessadas diretamente (Relatório Oficial do Rastreador do Google)

Por que o número de links externos afeta diretamente a velocidade de indexação?

Os dados mostram que as páginas com 1-5 links externos são rastreadas em média 1,2 vezes por semana, enquanto as páginas sem links externos são rastreadas apenas 0,3 vezes (Análise de Logs DeepCrawl 2024). Links externos de domínios de alta autoridade podem acionar o mecanismo de “rastreamento prioritário” do Google, e as novas páginas apontadas por esses links geralmente são indexadas em 48 horas. 5 links externos de 5 domínios diferentes são 3 vezes mais eficazes do que 5 links externos do mesmo domínio.

O rastreador do Google descobre novas páginas da web principalmente das seguintes maneiras:

- 52%: Através de links de outros sites

- 28%: Através do envio do sitemap

- 20%: Através de links internos (Fonte dos dados: Logs de Rastreamento do Googlebot 2024)

Dados experimentais mostram que:

- Uma nova página sem links externos leva em média 114 dias para ser indexada

- Se a mesma página obtiver 5 links externos de sites de autoridade média, o tempo de indexação é reduzido para 27 dias

- Um único link externo de um site de autoridade (DA>20) equivale ao efeito de 20 links externos comuns

Solução:

- Priorizar a obtenção de links externos em sites relevantes para o setor, como:

- Seções de comentários de blogs do mesmo setor (deve ser dofollow)

- Diretórios de negócios locais

- Sites de associações do setor

- Criar recursos de conteúdo vinculáveis, como:

- Ferramentas práticas (como calculadoras online)

- Relatórios de pesquisa originais

- Tutoriais e guias detalhados

Como Obter Backlinks de Alta Qualidade? (Métodos Específicos)

Pesquisas recentes mostram que a eficiência de aquisição de links externos para conteúdo de vídeo é 40% maior do que para texto e imagens, especialmente vídeos tutoriais que geram em média 11,3 links externos naturais (Relatório de Marketing de Vídeo Wistia 2024). Após uma atualização aprofundada de artigos existentes que estão classificados, mas desatualizados, a probabilidade de obter novos links externos naturais aumenta em 65% (Pesquisa de Estratégia de Conteúdo Útil HubSpot).

Para empresas locais, a participação em eventos da câmara de comércio e a obtenção de links no site oficial têm um excelente efeito SEO, com a eficiência de transmissão de autoridade sendo 8 vezes maior do que a de diretórios de negócios comuns (Pesquisa de SEO Local BrightLocal 2024).

Com base em testes práticos, estes métodos são os mais eficazes:

(1) Links Externos de Tipo Recurso

- Crie um guia definitivo para um nicho de mercado específico

- Caso: Um site de pesca criou o “Mapa Nacional de Locais de Pesca 2024” e obteve 87 links externos naturais

- Custo: Cerca de 2000 yuans (conteúdo + design), o efeito dura mais de 3 anos

(2) Entrevistas com Especialistas

- Entreviste especialistas do setor e publique a transcrição

- Em média, cada entrevista pode gerar 3-5 links externos (do entrevistado e suas redes sociais)

- Tempo investido: Cerca de 5 horas por entrevista

(3) Visualização de Dados

- Transforme dados públicos em infográficos

- Caso: Um site de fitness transformou dados de exercícios do comitê de saúde em gráficos e obteve 32 links externos de instituições educacionais

- Custo de produção: Cerca de 500 yuans/gráfico

Precauções:

- O crescimento dos links externos deve ser natural, um aumento de 100-500 por mês é ideal

- O texto âncora deve ser diversificado, com correspondência exata de palavras-chave não superior a 20%

- Priorizar a obtenção de links externos de diferentes setores e regiões

Os 3 Erros de Links Externos a Serem Evitados

Após a mais recente atualização do “Sistema de Detecção de Spam de Links” do Google, ele pode identificar 98% dos links PBN (Private Blog Network) (Anúncio da Equipe Anti-Spam do Google 2024). Se a proporção de links externos de domínios recém-registrados exceder 30%, um alerta de algoritmo é acionado.

Os dados mostram que sites com idade média de domínio de fonte de link externo inferior a 2 meses têm uma probabilidade 5 vezes maior de serem revisados manualmente (Relatório de Risco Search Engine Land 2024).

Em relação ao texto âncora, 3 textos âncora de correspondência exata idênticos consecutivos podem ser sinalizados. Recomenda-se um intervalo de pelo menos 15 textos âncora diferentes.

De acordo com casos de penalidade do Google, estas práticas são as mais perigosas:

(1) Compra em Massa de Links Externos

- Característica: Aumento repentino e massivo de links externos (ex: aumento de mais de 1 milhão em um mês)

- Risco: 87% dos sites perderão o ranking em 6 meses (Dados SEMrush)

- Alternativa: Construção natural, aumento de 100-500 por mês

(2) Links Externos Não Indexados

- Característica: Provenientes de assinaturas de fóruns DA<1, sites de perguntas e respostas

- Efeito: Esses links externos quase não ajudam na indexação (Teste Ahrefs)

- Método de identificação: Verificar a qualidade do conteúdo da página de link externo, desistir se o layout estiver confuso

(3) Otimização Excessiva do Texto Âncora

- Proporção segura:

- Nome da marca: 40%

- Termos genéricos (como “clique aqui”): 30%

- Palavras-chave de cauda longa: 20%

- Palavras-chave de correspondência exata: <10%

- Exceder esta proporção pode ser considerado manipulação de ranking

Após otimizar estes três pontos, 80% dos sites podem melhorar significativamente a sua taxa de indexação em 3-6 meses