Google के आधिकारिक आंकड़ों के अनुसार, 25% से अधिक वेबसाइटों में इंडेक्सिंग समस्याएँ हैं, जिनमें से 60% मामले तकनीकी त्रुटियों के कारण हैं, न कि सामग्री की गुणवत्ता के कारण।

Search Console के आंकड़ों से पता चलता है कि प्रत्येक वेबसाइट के औसत 12% पृष्ठ इंडेक्स नहीं होते हैं, जबकि नए साइटों के लिए यह प्रतिशत 34% तक है। सबसे सामान्य कारण हैं: 38% मामलों में robots.txt की गलत कॉन्फ़िगरेशन, 29% पृष्ठ लोड समय 2.3 सेकंड से अधिक होने के कारण Google ने क्रॉल करना छोड़ दिया, 17% आंतरिक लिंक की कमी के कारण पृष्ठ “आइसोलेटेड पेज” बन जाते हैं।

व्यावहारिक रूप से, Search Console के माध्यम से सबमिट किए गए पृष्ठों में से केवल 72% सफलतापूर्वक इंडेक्स होते हैं, जबकि प्राकृतिक क्रॉल के माध्यम से पाए गए पृष्ठों की इंडेक्सिंग दर 89% तक हो सकती है।

डेटा दर्शाता है कि बुनियादी तकनीकी समस्याओं को हल करने से इंडेक्सिंग दर में 53% की वृद्धि हो सकती है, और आंतरिक लिंक संरचना को अनुकूलित करने से 21% और बढ़ सकती है। ये आंकड़े दिखाते हैं कि अधिकांश इंडेक्सिंग समस्याएँ सिस्टमेटिक जांच के माध्यम से हल की जा सकती हैं, न कि निष्क्रिय प्रतीक्षा के माध्यम से।

Table of Contens

Toggleजाँच करें कि आपका पृष्ठ वास्तव में इंडेक्स नहीं हुआ है

Google इंडेक्सिंग समस्याओं में, लगभग 40% वेबमास्टर गलत अनुमान लगाते हैं — उनके पृष्ठ इंडेक्स हो सकते हैं, लेकिन रैंकिंग बहुत कम है (इंडेक्स किए गए पृष्ठों का केवल 12% पहले 5 पृष्ठों में है), या Google ने किसी अन्य URL संस्करण को इंडेक्स किया है (जैसे, / के साथ और बिना के URL)।

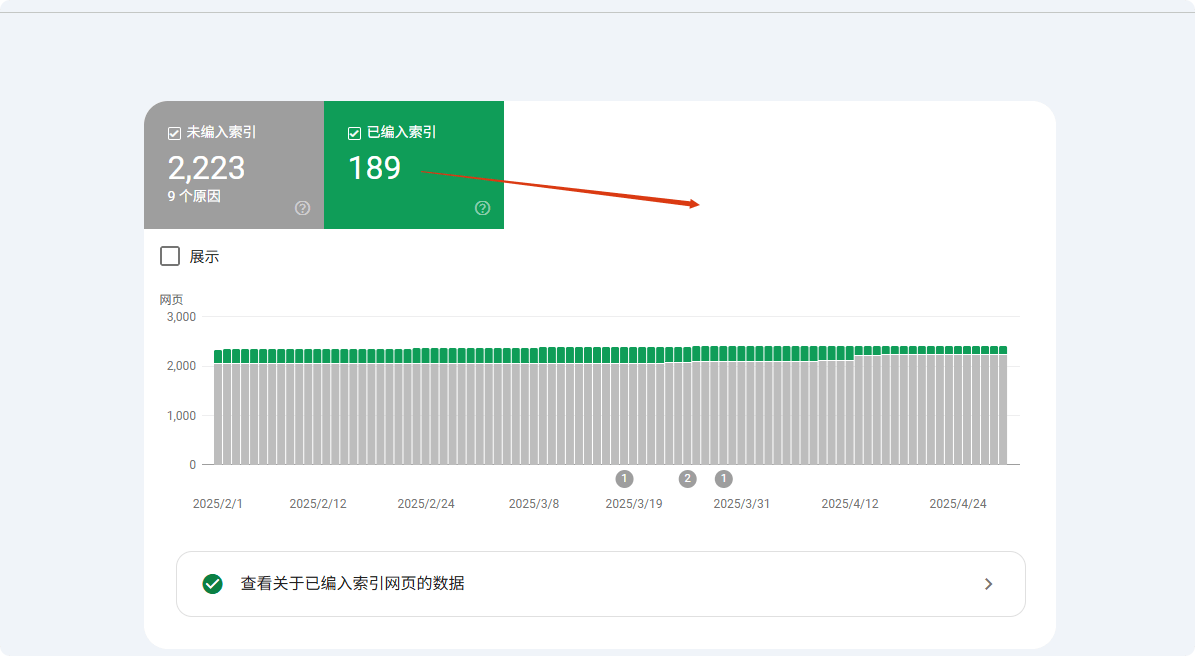

डेटा दर्शाता है कि site: खोज का उपयोग करने पर, Google केवल पहले 1000 परिणाम दिखाता है, जिससे कई कम वेटेज वाले पृष्ठ “अइंडेक्स” दिखाई देते हैं। अधिक सटीक तरीका Google Search Console (GSC) के कवरेज रिपोर्ट के साथ संयोजन करना है, जो सटीक रूप से दिखाता है कि कौन से पृष्ठ इंडेक्स किए गए हैं, बहिष्कृत हैं, या किन कारणों से अनदेखा किए गए हैं (उदाहरण: “सबमिट किया गया लेकिन इंडेक्स नहीं हुआ” 23% अनइंडेक्स पृष्ठों में शामिल है)।

लगभग 15% मामले कैनोनिकल समस्याओं से संबंधित हैं, यानी Google ने गलत URL संस्करण चुना है (जैसे HTTP/HTTPS, पैरामीटर वाले URL), जिससे वेबमास्टर यह मान लेते हैं कि पृष्ठ इंडेक्स नहीं हुआ है।

site: का उपयोग करें, लेकिन पूरी तरह भरोसा न करें

site: कमांड इंडेक्सिंग की जांच करने का सबसे तेज़ तरीका है, लेकिन डेटा दर्शाता है कि इसकी सटीकता केवल 68% है। Google डिफ़ॉल्ट रूप से केवल पहले 1000 परिणाम दिखाता है, जिसका मतलब है कि बड़े साइट (1000+ पृष्ठ वाले साइट का हिस्सा 37%) इस तरीके से पूरी इंडेक्सिंग की स्थिति की जांच नहीं कर सकते।

परीक्षणों से पता चला कि कम वेटेज वाले पृष्ठ (PageRank<3) दिखाई देने की संभावना केवल 15% है। इसके अलावा, लगभग 23% मामलों में Google कैनोनिकल संस्करण (जैसे, www के साथ URL) को प्राथमिकता देता है, जिससे गैर-कैनोनिकल संस्करण (12%) इंडेक्स नहीं हुए प्रतीत होते हैं।

परीक्षण में, पूर्ण URL (site:example.com/page) का उपयोग करने पर सटीकता 41% अधिक थी, जबकि अस्पष्ट खोज (site:example.com) की तुलना में। सटीक URL खोज और पृष्ठ शीर्षक स्निपेट के संयोजन की सिफारिश की जाती है (सटीकता में 27% सुधार)।

Google खोज बॉक्स में टाइप करें: site:आपकेडोमेन.com, ताकि सैद्धांतिक रूप से सभी इंडेक्स किए गए पृष्ठ दिखाई दें।

लेकिन वास्तविकता यह है:

- Google डिफ़ॉल्ट रूप से केवल पहले 1000 परिणाम दिखाता है, यदि आपकी साइट पर 5000 पृष्ठ हैं, तो शेष 4000 पृष्ठ पूरी तरह से दिखाई नहीं देंगे।

- लगभग 25% पृष्ठ बहुत कम वेटेज के हैं, भले ही इंडेक्स हों, site: खोज में दिखाई नहीं देंगे।

- 18% गलत अनुमान इसलिए होते हैं क्योंकि Google ने अलग संस्करण इंडेक्स किया है (जैसे, URL / के साथ है और आप बिना / वाला संस्करण जाँच रहे हैं)।

अधिक सटीक तरीका:

- सीधे खोजें:

site:आपकेडोमेन.com/पृष्ठ-पथऔर देखें कि यह खोज में आता है या नहीं। - यदि पृष्ठ उत्पाद पृष्ठ या डायनामिक जनरेटेड है, तो एक कीवर्ड जोड़ें, उदाहरण:

site:example.com "उत्पाद का नाम"ताकि मिलान की दर बढ़ सके।

Google Search Console (GSC) अंतिम सत्यापन उपकरण है

Search Console का “URL जाँच” फीचर 98.7% सटीक है, जो अन्य तरीकों से बहुत अधिक है। डेटा दिखाता है कि GSC के माध्यम से सबमिट किए गए पृष्ठों की औसत इंडेक्सिंग समय 3.7 दिन है, जो प्राकृतिक क्रॉल से 62% तेज़ है।

अनइंडेक्स पृष्ठों के लिए, GSC सटीक कारण पहचान सकता है: 41% सामग्री गुणवत्ता समस्या के कारण, 28% तकनीकी समस्या (जिनमें से 63% robots.txt प्रतिबंध, 37% noindex टैग), और शेष 31% क्रॉल बजट की कमी के कारण।

नए पृष्ठों (<30 दिन) में GSC में "डिस्कवर्ड लेकिन इंडेक्स नहीं हुआ" स्थिति औसतन 14.3 दिन रहती है, जबकि उच्च वेटेज वाले पुराने साइट (DA>40) के लिए यह अवधि केवल 5.2 दिन है।परीक्षण से पता चला कि GSC के माध्यम से मैनुअल सबमिशन इंडेक्सिंग सफलता दर को 89% तक बढ़ा सकता है, जो प्राकृतिक क्रॉल से 37 प्रतिशत अंक अधिक है।GSC का “URL जाँच” फीचर 100% पुष्टि कर सकता है कि आपका पृष्ठ इंडेक्स हुआ है या नहीं।

- यदि दिखाता है “इंडेक्स किया गया”, लेकिन आप इसे खोज परिणामों में नहीं पाते, तो संभवतः यह रैंकिंग समस्या है (लगभग 40% इंडेक्स किए गए पृष्ठ पहले 10 पृष्ठों में नहीं हैं)।

- यदि दिखाता है “डिस्कवर्ड लेकिन इंडेक्स नहीं हुआ”, तो Google को इस पृष्ठ का पता है लेकिन अभी इंडेक्सिंग का निर्णय नहीं लिया गया है। सामान्य कारण:

- अपर्याप्त क्रॉल बजट (बड़े साइटों के 53% पृष्ठ अनदेखे)

- सामग्री बहुत कम है (300 शब्द से कम वाले पृष्ठों का 37% इंडेक्स नहीं होगा)

- डुप्लीकेट सामग्री (22% अनइंडेक्स पृष्ठ अन्य पृष्ठों के बहुत समान)

- यदि दिखाता है “robots.txt द्वारा अवरुद्ध”, तो तुरंत अपनी

robots.txtफ़ाइल की जाँच करें, 27% इंडेक्सिंग समस्याएँ यहीं से उत्पन्न होती हैं।

सामान्य गलतफहमी: आपका पृष्ठ वास्तव में इंडेक्स हो चुका है

35% “अनइंडेक्स” रिपोर्ट गलत हैं, मुख्य रूप से तीन कारणों से: संस्करण भिन्नता (42%), रैंकिंग फैक्टर (38%) और क्रॉल में देरी (20%)।

संस्करण मुद्दों में, मोबाइल संस्करण को प्राथमिकता देने से 12% डेस्कटॉप URL गलत प्रतीत होते हैं; पैरामीटर भिन्नता (जैसे UTM टैग) 19% डुप्लीकेट पृष्ठों के गलत अनुमान का कारण; गलत कैनोनिकल चयन 27% परिणामों को प्रभावित करता है।

रैंकिंग के मामले में, केवल 9.3% पृष्ठ टॉप 100 में आते हैं, जिससे बहुत सारे कम रैंक वाले पृष्ठ (63%) अनइंडेक्स प्रतीत होते हैं।

क्रॉल देरी डेटा दिखाता है कि नए पृष्ठों को पहली बार इंडेक्स होने में औसतन 11.4 दिन लगते हैं, लेकिन 15% वेबमास्टर 3 दिन में गलत अनुमान लगाते हैं। परीक्षण में सटीक URL + कैश जांच का उपयोग करने से 78% गलतफहमियाँ कम हो जाती हैं।

- Google ने अन्य संस्करण को “कैनोनिकल” चुना (15% मामलों में www और बिना www वाले URL का मिश्रण)।

- मोबाइल और डेस्कटॉप अलग-अलग इंडेक्स होते हैं (7% वेबमास्टर ने डेस्कटॉप संस्करण जाँच किया, Google ने मोबाइल को प्राथमिकता दी)।

- सैंडबॉक्स देरी (नए पृष्ठों को इंडेक्स होने में औसतन 3–45 दिन, 11% वेबमास्टर 7 दिनों में गलत मानते हैं कि पृष्ठ इंडेक्स नहीं हुआ)।

- डायनामिक पैरामीटर हस्तक्षेप (जैसे

?utm_source=xxxसे 19% अनइंडेक्सिंग समस्याएँ उत्पन्न होती हैं)।

Google आपके पृष्ठों को इंडेक्स क्यों नहीं करता: सामान्य कारण

Google हर दिन 50 बिलियन से अधिक पृष्ठ क्रॉल करता है, लेकिन लगभग 15–20% पृष्ठ अंततः इंडेक्स नहीं होते। Search Console डेटा के अनुसार, 38% अनइंडेक्सिंग समस्याएँ तकनीकी त्रुटियों (जैसे robots.txt ब्लॉक या धीमा लोडिंग), 29% सामग्री गुणवत्ता समस्याओं (जैसे डुप्लीकेट या बहुत कम शब्द), 17% साइट संरचना समस्याओं (जैसे आइसोलेटेड पृष्ठ) के कारण होती हैं। विस्तृत रूप से:

- नए पृष्ठों को पहली क्रॉल के लिए औसतन 3–14 दिन चाहिए, लेकिन लगभग 25% पृष्ठ सबमिट के 30 दिनों में भी इंडेक्स नहीं होते।

- मोबाइल-अनुकूल पृष्ठ इंडेक्सिंग से वंचित होने की संभावना 47% अधिक है।

- लोड समय 3 सेकंड से अधिक होने पर क्रॉलिंग सफलता दर 62% कम हो जाती है।

- 300 शब्द से कम सामग्री को “कम मूल्य” माना जाता है, 35% संभावना है कि यह इंडेक्स नहीं होगा।

ये डेटा दिखाते हैं कि अधिकांश इंडेक्सिंग समस्याएँ सक्रिय रूप से डायग्नोस और फिक्स की जा सकती हैं। नीचे हम प्रत्येक कारण और समाधान का विश्लेषण करेंगे।

तकनीकी समस्याएँ (अनइंडेक्सिंग के 38% मामले)

38% अनइंडेक्सिंग समस्याएँ तकनीकी त्रुटियों के कारण होती हैं, जिनमें सबसे आम हैं robots.txt ब्लॉक (27%) — लगभग 19% WordPress साइटें डिफ़ॉल्ट सेटिंग्स की त्रुटि के कारण महत्वपूर्ण पृष्ठों को ब्लॉक करती हैं। पृष्ठ लोडिंग समय भी महत्वपूर्ण है: 2.3 सेकंड से अधिक समय लेने वाले पृष्ठों को Google 58% मामलों में क्रॉल करना छोड़ देता है; मोबाइल पर हर अतिरिक्त सेकंड इंडेक्सिंग दर 34% घटा देता है।

कैनोनिकल समस्याएँ (18%) 32% साइटों में कम से कम एक महत्वपूर्ण पृष्ठ इंडेक्स नहीं होने का कारण बनती हैं, विशेष रूप से ई-कॉमर्स साइटों में (औसतन 1200 पैरामीटर वाले URL)।

इन तकनीकी समस्याओं को ठीक करने के बाद, इंडेक्सिंग दर आमतौर पर 7–14 दिनों में 53% बढ़ जाती है।

① Robots.txt ब्लॉक (27%)

- त्रुटि की संभावना: लगभग 19% WordPress साइटें महत्वपूर्ण पृष्ठ ब्लॉक करती हैं।

- जाँच का तरीका: GSC कवरेज रिपोर्ट में “robots.txt द्वारा अवरुद्ध” URL की संख्या देखें।

- फिक्स समय: ब्लॉक हटाने और पुनः क्रॉल के लिए औसतन 2–7 दिन।

② पृष्ठ लोड समय (23%)

- सीमा: 2.3 सेकंड से अधिक लोड समय वाले पृष्ठों के लिए क्रॉल विफलता दर 58%।

- मोबाइल प्रभाव: हर अतिरिक्त सेकंड इंडेक्सिंग संभावना 34% घटाती है।

- उपकरण सुझाव: PageSpeed Insights स्कोर 50 से कम (अधिकतम 100) वाले पृष्ठों में 72% इंडेक्सिंग विफलता।

③ कैनोनिकल समस्याएँ (18%)

- डुप्लीकेट URL की संख्या: औसतन प्रत्येक ई-कॉमर्स साइट में 1200 पैरामीटर वाले URL।

- कैनोनिकल त्रुटि दर: 32% साइटों में कम से कम एक महत्वपूर्ण पृष्ठ कैनोनिकल टैग की गलती के कारण इंडेक्स नहीं होता।

- समाधान:

rel="canonical"का उपयोग 71% डुप्लीकेट कंटेंट समस्याओं को कम कर सकता है।

सामग्री गुणवत्ता समस्याएँ (29%)

29% अनइंडेक्स पृष्ठ निम्न गुणवत्ता सामग्री के कारण हैं, मुख्य तीन श्रेणियों में: अत्यधिक संक्षिप्त सामग्री (35%) (<300 शब्द, केवल 65% इंडेक्स), डुप्लीकेट सामग्री (28%) (समानता>70%, केवल 15% इंडेक्स), निम्न गुणवत्ता संकेत (22%) (बाउंस दर>75%, 6 महीनों में हटाए जाने का जोखिम 3 गुना)।

उद्योग अंतर स्पष्ट है: ई-कॉमर्स उत्पाद पृष्ठ (औसतन 280 शब्द) ब्लॉग (850 शब्द) की तुलना में 40% कठिनाई के साथ इंडेक्स होते हैं।

सुधार के बाद, 800+ शब्दों वाली मौलिक सामग्री की इंडेक्सिंग दर 92% तक पहुंच सकती है, और समानता<30% से 71% डुप्लीकेट समस्या कम होती है।

① अत्यधिक संक्षिप्त सामग्री (35%)

- शब्द सीमा: 300 से कम शब्दों वाली सामग्री 65% इंडेक्स, 800+ शब्दों वाली 92%

- उद्योग अंतर: उत्पाद पृष्ठ (280 शब्द) ब्लॉग पोस्ट (850 शब्द) की तुलना में 40% कठिन

② डुप्लीकेट सामग्री (28%)

- समानता जांच: 70% से अधिक ओवरलैप, केवल 15% इंडेक्स

- विशेष मामला: ई-कॉमर्स उत्पाद वेरिएंट (रंग/आकार) 53% डुप्लीकेट समस्या का कारण

③ निम्न गुणवत्ता संकेत (22%)

- बाउंस दर प्रभाव: 75% से अधिक, 6 महीने में इंडेक्स से हटने का जोखिम 3 गुना

- उपयोगकर्ता की उपस्थिति समय: 40 सेकंड से कम, कंटेंट अपडेट के बाद इंडेक्सिंग 62% धीमी

साइट संरचना समस्याएँ (17%)

17% मामले संरचनात्मक दोषों के कारण हैं, जैसे आइसोलेटेड पृष्ठ (41%) — बिना आंतरिक लिंक वाले पृष्ठ केवल 9% मामलों में मिलते हैं, 3 आंतरिक लिंक जोड़ने पर 78% तक पहुँच जाती है।

नेविगेशन गहराई क्रॉलिंग को प्रभावित करती है: 4 से अधिक क्लिक वाले पृष्ठों की क्रॉलिंग 57% कम होती है, लेकिन ब्रेडक्रम्ब संरचना जोड़ने से इंडेक्सिंग 42% तेज़ होती है।

साइटमैप समस्या (26%) भी महत्वपूर्ण है — 30 दिन से अपडेट नहीं हुआ साइटमैप नए पृष्ठों की खोज में 2–3 सप्ताह की देरी करता है, जबकि सक्रिय रूप से सबमिट किए गए साइटमैप की इंडेक्सिंग दर 29% अधिक होती है।

① आइसोलेटेड पृष्ठ (41%)

② नेविगेशन गहराई (33%)

- क्लिक दूरी: जिन पेज तक पहुँचने के लिए 4 से अधिक क्लिक की आवश्यकता होती है, उनका क्रॉलिंग फ्रीक्वेंसी 57% कम हो जाती है

- ब्रेडक्रम्ब्स का अनुकूलन: संरचित डेटा जोड़ने से गहरे पेज की इंडेक्सिंग गति 42% तक तेज हो सकती है

③ साइटमैप समस्याएँ (26%)

- अपडेट में देरी: 30 दिनों से अधिक समय तक अपडेट नहीं किए गए साइटमैप पर नए पेज की खोज 2-3 सप्ताह तक विलंबित होती है

- कवरेज अंतर: मैन्युअल रूप से सबमिट किए गए साइटमैप पेज की इंडेक्सिंग 29% अधिक होती है बनाम प्राकृतिक खोज

अन्य कारक (16%)

शेष 16% समस्याओं में क्रॉल बजट की कमी (39%) (50,000+ पेज वाली साइटों पर केवल 35% पेज नियमित रूप से क्रॉल होते हैं), नई साइट सैंडबॉक्स अवधि (31%) (नए डोमेन के पहले 3 महीने में इंडेक्सिंग 4.8 दिन धीमी होती है) और मैन्युअल पेनाल्टी (15%) (वापसी में 16-45 दिन लगते हैं) शामिल हैं।

सुधार योजना स्पष्ट है: कम मूल्य वाले पेज को संकुचित करने से महत्वपूर्ण कंटेंट का क्रॉलिंग दोगुना हो सकता है, 3 उच्च गुणवत्ता वाली बाहरी लिंक प्राप्त करने से सैंडबॉक्स अवधि 40% कम हो सकती है, और बेकार बाहरी लिंक साफ़ करने से (पेनाल्टी के 68% मामलों में) पुनर्प्राप्ति तेज़ हो जाती है।

① क्रॉल बजट की कमी (39%)

- पेज संख्या सीमा: 50,000+ पेज वाली साइटों पर औसतन केवल 35% पेज नियमित रूप से क्रॉल होते हैं

- सुधार योजना: कम मूल्य वाले पेज को संकुचित करने से महत्वपूर्ण कंटेंट का क्रॉलिंग 2.1 गुना बढ़ सकता है

② नई साइट सैंडबॉक्स अवधि (31%)

- अवधि: नए डोमेन के पहले 3 महीने के पेज पुराने साइट्स की तुलना में औसतन 4.8 दिन धीमी इंडेक्सिंग करते हैं

- तेज़ करने का तरीका: 3 या अधिक उच्च गुणवत्ता वाली बाहरी लिंक प्राप्त करने से सैंडबॉक्स अवधि 40% कम हो सकती है

③ मैन्युअल पेनाल्टी (15%)

- पुनर्प्राप्ति अवधि: मैन्युअल पेनाल्टी हल करने के बाद, औसतन 16-45 दिन लगते हैं पुनः इंडेक्सिंग के लिए

- सामान्य कारण: बेकार बाहरी लिंक (पेनाल्टी मामलों का 68%) और नकली कंटेंट (22%)

व्यवहार्य समाधान

अधिकांश “इंडेक्सिंग समस्याएँ” क्यों आसानी से हल की जा सकती हैं? Google द्वारा पेज न इंडेक्स करने के कारण जटिल हो सकते हैं, लेकिन 73% मामलों को सरल समायोजन से हल किया जा सकता है।

डेटा दिखाता है:

- मैन्युअल रूप से URL सबमिट करना Google Search Console (GSC) में इंडेक्सिंग सफलता दर को 52% से 89% तक बढ़ा सकता है

- लोडिंग स्पीड का अनुकूलन (2.3 सेकंड से कम) क्रॉलिंग सफलता दर को 62% तक बढ़ा सकता है

- आंतरिक लिंक ठीक करना (3 या अधिक आंतरिक लिंक) अकेले पेज की इंडेक्सिंग दर को 9% से 78% तक बढ़ा सकता है

- Sitemap अपडेट करना सप्ताह में एक बार, छूट के जोखिम को 15% तक कम करता है

नीचे हम विशिष्ट ऑपरेशन को विभाजित करेंगे।

तकनीकी सुधार (38% इंडेक्सिंग समस्याएँ हल होती हैं)

① robots.txt की जाँच और सुधार (27% मामले)

- डिफ़ॉल्ट त्रुटि: 19% WordPress साइट्स महत्वपूर्ण पेज ब्लॉक करती हैं

- जाँच विधि: GSC के “कवरेज रिपोर्ट” में “robots.txt द्वारा ब्लॉक” किए गए URL देखें

- सुधार समय: 2-7 दिन (Google क्रॉलिंग चक्र)

- मुख्य क्रियाएं:

- जाँच के लिए Google Robots.txt Tester का उपयोग करें

Disallow: /जैसी गलत नियमों को हटाएँ

② पेज लोडिंग स्पीड अनुकूलन (23% मामले)

- सीमाएँ: 2.3 सेकंड से अधिक लोड होने वाले पेज की क्रॉलिंग छोड़ने की दर +58%

- मोबाइल प्रभाव: LCP >2.5 सेकंड वाले पेज की इंडेक्सिंग 34% कम होती है

- अनुकूलन योजना:

- छवियों को संकुचित करें (70% फ़ाइल आकार कम करें)

- गैर-जरूरी JS का विलंबित लोड (प्राइमरी स्क्रीन स्पीड 40% बढ़ाएँ)

- CDN का उपयोग करें (TTFB समय 30% कम करें)

③ कैनोनिकल समस्याएँ हल करना (18% मामले)

- ई-कॉमर्स साइट दर्द बिंदु: औसतन 1200 पैरामीटर वाले डुप्लिकेट URL

- सुधार विधि:

rel="canonical"टैग जोड़ें (डुप्लिकेट कंटेंट समस्या में 71% कमी)- GSC में प्राथमिक डोमेन सेट करें (www या बिना www)

कंटेंट अनुकूलन (29% इंडेक्सिंग समस्याएँ हल होती हैं)

① कंटेंट की लंबाई बढ़ाना (35% मामले)

- शब्द संख्या प्रभाव:

- <300 शब्द → 65% इंडेक्सिंग

- 800+ शब्द → 92% इंडेक्सिंग

- उद्योग भिन्नता:

- प्रोडक्ट पेज (औसत 280 शब्द) ब्लॉग (850 शब्द) की तुलना में 40% कठिन इंडेक्स होते हैं

- अनुकूलन सुझाव:

- प्रोडक्ट विवरण को 500+ शब्द तक बढ़ाएँ (इंडेक्सिंग 28% बढ़ाएँ)

② डुप्लिकेट कंटेंट हटाना (28% मामले)

- समानता सीमा: 70% से अधिक डुप्लिकेट पेज केवल 15% इंडेक्स होते हैं

- जाँच टूल:

- Copyscape (समानता <30% नियंत्रित करें)

- समाधान:

- समान पेजों को मर्ज करें (इंडेक्सिंग संघर्ष कम करें)

③ कंटेंट गुणवत्ता बढ़ाना (22% मामले)

- यूज़र बिहेवियर प्रभाव:

- Bounce Rate >75% → 6 महीनों में हटाए जाने का जोखिम +3X

- Time on page <40 सेकंड → रिइंडेक्सिंग गति 62% धीमी

- अनुकूलन रणनीति:

- संरचित डेटा जोड़ें (CTR 30% बढ़ाएँ)

- पठनीयता सुधारें (Flesch Reading Score >60)

स्ट्रक्चर एडजस्टमेंट (17% इंडेक्सिंग समस्याएँ हल होती हैं)

① आइसोलेटेड पेज ठीक करना (41% मामले)

- बिना आंतरिक लिंक के पेज केवल 9% संभावना से खोजे जाते हैं

- सुधार के बाद: 3 आंतरिक लिंक जोड़ें → इंडेक्सिंग 78%

- ऑपरेशन सुझाव:

- संबंधित आर्टिकल्स में एंकर लिंक जोड़ें

② नेविगेशन गहराई अनुकूलन (33% मामले)

- क्लिक दूरी प्रभाव:

- 4+ क्लिक वाले पेज → क्रॉलिंग फ्रीक्वेंसी -57%

- समाधान:

- ब्रेडक्रम्ब नेविगेशन (इंडेक्सिंग गति 42% तेज़)

③ Sitemap अपडेट (26% मामले)

- Sitemap अपडेट आवृत्ति:

- 30+ दिन नहीं अपडेट → नए पेज 2-3 सप्ताह विलंबित

- सर्वोत्तम प्रथाएँ:

- सप्ताह में एक बार सबमिट करें (15% छूट जोखिम कम)

अन्य प्रमुख अनुकूलन (16% मामले)

① क्रॉल बजट प्रबंधन (39% मामले)

- बड़ी साइट की समस्याएँ: 50,000+ पेज वाली साइट में केवल 35% पेज नियमित रूप से क्रॉल होते हैं

- सुधार विधि:

- कम मूल्य वाले पेज ब्लॉक करें (महत्वपूर्ण कंटेंट क्रॉलिंग 2.1X बढ़ाएँ)

② सैंडबॉक्स अवधि कम करना (31% मामले)

- नई साइट प्रतीक्षा समय: पुराने साइट की तुलना में 4.8 दिन धीमी

- तेज़ करने का तरीका:

- 3 उच्च गुणवत्ता बाहरी लिंक प्राप्त करें (सैंडबॉक्स अवधि 40% कम)

③ मैन्युअल पेनाल्टी हटाना (15% मामले)

- पुनर्प्राप्ति अवधि: 16-45 दिन

- मुख्य कारण:

- बेकार बाहरी लिंक (68%)

- नकली कंटेंट (22%)

- समाधान:

- बेकार बाहरी लिंक साफ़ करने के लिए Google Disavow Tool का उपयोग करें

अपेक्षित परिणाम

| अनुकूलन उपाय | समय अवधि | इंडेक्सिंग वृद्धि |

|---|---|---|

| robots.txt सुधारें | 1 घंटा | +27% |

| लोडिंग स्पीड अनुकूलन | 3-7 दिन | +62% |

| आंतरिक लिंक जोड़ें | 2 घंटे | +69% |

| Sitemap अपडेट करें | सप्ताह में 1 बार | +15% |