Les trois raisons principales pour lesquelles Google n’indexe pas une URL :

- 62% sont dues à la faible qualité du contenu (Ahrefs 2024)

- La période d’incubation (sandbox) pour les nouveaux sites retarde en moyenne de 28 jours (SEMrush)

- L’indexation des pages sans liens externes prend 114 jours (Moz)

Selon les données de la Google Search Console, environ 35% des nouvelles pages soumises ne sont pas indexées dans les 30 jours, et le cycle d’indexation moyen pour les sites Web de taille moyenne à petite atteint 2 à 4 semaines.

62% des pages non indexées présentent des problèmes de qualité de contenu (Source des données : Rapport d’indexation de sites Web Ahrefs 2024). Le robot d’exploration de Google traite plus de 5 milliards de pages par jour, mais il donne la priorité à l’exploration des pages Web dont le contenu est complet, dont la vitesse de chargement est inférieure à 1,5 seconde et qui ont un sujet clair.

Des expériences montrent que la probabilité d’indexation d’une nouvelle page sans lien externe diminue de 73% (Étude sur le comportement des robots d’exploration Moz 2024), et 15% des pages des sites utilisant WordPress ne peuvent pas être correctement explorées en raison de problèmes techniques.

Table of Contens

ToggleQualité du contenu faible

Selon les données officielles de Google, 62% des pages non indexées présentent des problèmes de qualité de contenu (Rapport d’indexation Ahrefs 2024).

Des données plus spécifiques indiquent que :

- Le taux d’indexation du contenu court (<500 mots) n’est que de 28%, tandis que le taux d’indexation des pages de plus de 800 mots passe à 71%.

- Le contenu dupliqué ou de faible originalité a une probabilité accrue de 3 fois d’être ignoré par Google (Analyse de contenu Moz 2024).

- Les pages avec une mise en page confuse ou un chargement lent (>3 secondes) ont une probabilité allant jusqu’à 45% d’être ignorées lors de l’exploration (Données Google PageSpeed Insights).

L’algorithme de Google compare directement votre contenu avec les 10 meilleurs résultats de recherche. Si les informations sont insuffisantes, manquent d’unicité ou la lisibilité est mauvaise, le robot d’exploration jugera que la page « ne mérite pas d’être indexée ».

Longueur du contenu insuffisante, faible valeur informative

Selon la dernière étude de Search Engine Journal, le contenu de 500 à 800 mots ne satisfait que 38% des besoins de recherche des utilisateurs, tandis que le contenu de plus de 1200 mots résout 92% des intentions de requête.

Les données expérimentales montrent qu’après avoir étendu le contenu de 500 mots à 1500 mots, le temps de séjour moyen sur la page a augmenté de 2,3 fois (Rapport d’expérience utilisateur Chartbeat 2024).

Dans le système de notation EEAT de Google, il est difficile pour le contenu court d’établir suffisamment de signaux d’autorité.

Google indique clairement que le contenu court (<500 mots) ne peut généralement pas satisfaire l’intention de recherche. Les données montrent que :

- La longueur moyenne des articles classés dans le Top 10 se situe entre 1200 et 1800 mots (Étude de mots-clés Backlinko 2024).

- Si la description des pages de produits dans le commerce électronique est inférieure à 300 mots, le taux de conversion diminue de 40% (Recherche Baymard Institute).

Comment améliorer ?

- Le contenu de base doit être d’au moins 800 mots, couvrant toutes les questions que les utilisateurs pourraient poser. Par exemple, lors de la rédaction sur « Comment choisir des écouteurs Bluetooth », il est nécessaire d’inclure des détails tels que la qualité sonore, l’autonomie, le confort de port, la comparaison des marques.

- L’utilisation de données structurées (balises FAQ, HowTo) peut augmenter la vitesse d’indexation de 30% (Cas officiel de Google).

Contenu dupliqué ou manque d’originalité

L’analyse de contenu de BrightEdge en 2024 montre que 65% des pages sur le Web présentent des problèmes de duplication de contenu supérieurs à 30%. Après la dernière mise à jour de l’algorithme SpamBrain de Google, la précision de l’identification des collages de contenu a atteint 89% (Données publiées à Google I/O 2024).

Même si le contenu est réécrit avec des expressions différentes, si les arguments principaux sont les mêmes que ceux du contenu existant, il sera toujours jugé comme une page de faible valeur.

Les articles qui ajoutent au moins 3 points de données exclusifs ont un taux de partage supérieur de 470% au contenu ordinaire (Étude sur la diffusion de contenu BuzzSumo 2024).

L’algorithme de “Détection de similitude de contenu” (BERT) de Google compare directement les informations existantes sur tout le Web. Si votre article révèle que :

- Plus de 50% du contenu chevauche d’autres pages (par exemple, les paramètres dans la description du produit sont copiés directement du manuel du fabricant).

- Il n’y a pas d’opinions personnelles ou de données exclusives (par exemple, seulement un résumé de l’information publique).

La probabilité d’indexation diminuera considérablement. Après la réécriture par un blog technologique de 10 articles de concurrents, le taux d’indexation a chuté de 65% à 12% (Audit de contenu SEMrush 2024).

Comment améliorer ?

- Ajouter des recherches originales : par exemple, des données de test réelles, des enquêtes auprès des utilisateurs (comme « test aveugle de la qualité sonore des écouteurs sur 100 personnes »).

- La réécriture doit dépasser 70%, et des analyses de cas doivent être ajoutées (par exemple, « performance réelle de la réduction du bruit des écouteurs de la marque XX »).

Faible lisibilité, mauvaise expérience utilisateur

L’expérience de suivi oculaire de Microsoft montre que lorsque le paragraphe dépasse 4 lignes, la concentration visuelle de l’utilisateur diminue de 61%. Sur mobile, pour chaque seconde de chargement supplémentaire, la probabilité que l’utilisateur continue à lire diminue de 16% (Recherche Google Mobile UX 2024 T2).

Le nouvel indicateur SEO de Google, « Confort de lecture », inclut la longueur des paragraphes, la densité des titres, le rapport image/texte, etc., comme facteurs de classement. Les tests montrent qu’une optimisation peut améliorer le CTR de 17% (Données de test A/B SearchPilot 2024).

Google évalue l’expérience utilisateur via les « Core Web Vitals » (Signaux Web Essentiels). Si l’une des situations suivantes se produit :

- Paragraphes trop longs (>5 lignes), absence de sous-titres, le taux de rebond de l’utilisateur augmente de 50% (Recherche NNGroup).

- L’adaptation mobile échoue, ce qui entraîne 15% des pages qui sont directement ignorées par le robot d’exploration (Données Google Mobile-Friendly Test).

Comment améliorer ?

- Chaque paragraphe doit contenir 3-4 lignes, ajouter un sous-titre toutes les 2-3 paragraphes (comme la structure de cet article).

- Utiliser Grammarly ou Hemingway Editor pour vérifier la lisibilité, s’assurer que le score est $\geq 70$ (équivalent au niveau de lecture de collège).

- Compresser les images à <100KB pour réduire le temps de chargement (Outil : TinyPNG).

Période d’incubation (Sandbox) pour les nouveaux sites

Selon les données officielles de Google, les noms de domaine nouvellement enregistrés nécessitent en moyenne 14 à 90 jours pour être indexés de manière stable (Recherche Search Engine Journal 2024). Les performances spécifiques sont les suivantes :

- Au cours des 30 premiers jours, environ 60% des nouvelles pages ne sont pas indexées (Données d’exploration Ahrefs 2024).

- Même après la soumission manuelle à la Google Search Console, 35% des pages doivent encore attendre plus d’un mois (Expérience Moz 2024).

- Le trafic de recherche des nouveaux sites est généralement inférieur de 50% à 70% à celui des anciens domaines au cours des 3 premiers mois (Analyse de la période d’incubation SEMrush 2024).

Ce phénomène est appelé « Période d’incubation » (Sandbox Effect). Ce n’est pas une pénalité, mais une période de test de confiance de Google pour les nouveaux sites Web.

La période d’incubation existe-t-elle vraiment ?

Le trafic organique obtenu par les nouveaux domaines au cours des 90 premiers jours n’est que de 15 à 20% de celui des anciens domaines (Statistiques SimilarWeb 2024). Le budget d’exploration (Crawl Budget) attribué par le robot d’exploration de Google aux nouveaux sites n’est en moyenne que d’un cinquième de celui des anciens sites, ce qui signifie que même après la soumission de l’URL, plusieurs explorations sont nécessaires pour être indexé.

Les tests A/B de SearchPilot montrent que la différence de vitesse d’indexation produite par une optimisation technique identique entre un nouveau site et un ancien site atteint 4:1.

Google n’a jamais officiellement admis l’existence de la « Période d’incubation », mais de nombreuses données suggèrent que :

- Le taux d’indexation des nouveaux domaines au cours des 30 premiers jours n’est que de 40%, tandis que celui des anciens sites de plus de 6 mois atteint 85% (Recherche Backlinko 2024).

- Lorsqu’un même contenu est publié sur un nouveau site et un ancien site, le classement de l’ancien site est en moyenne 2 à 3 semaines plus rapide (Expérience comparative Ahrefs 2024).

- La fréquence à laquelle le robot d’exploration de Google visite les nouveaux sites est 3 fois inférieure à celle des sites établis (Analyse des journaux d’exploration Googlebot).

Comment déterminer si votre site est en période d’incubation ?

- Vérifiez le « Rapport de Couverture » de la Google Search Console. S’il affiche « Soumise et non indexée » sans message d’erreur.

- Comparez la vitesse d’indexation avec celle de sites anciens similaires. Si elle est significativement en retard, cela peut être dû à l’effet d’incubation.

Combien de temps dure la période d’incubation ? Comment la raccourcir ?

Une analyse approfondie de 1000 nouveaux sites révèle que la période d’incubation des sites médicaux et juridiques est 42% plus longue que la moyenne, tandis que celle des blogs personnels est 28% plus courte (Rapport sectoriel Sistrix 2024).

Fait intéressant, pour les sites d’actualités certifiés par le Google News Publisher Center, la période d’incubation peut être réduite à 60% de la durée habituelle. Sur le plan technique, la vitesse d’indexation moyenne des pages activant AMP est améliorée de 35%, et le contenu au format Web Stories est plus susceptible d’être exploré en priorité (Mise à jour Google Developer Document 2024).

La durée de la période d’incubation dépend de plusieurs facteurs :

- Intensité de la concurrence dans le secteur : Les sites d’e-commerce et de finance nécessitent généralement 3 à 6 mois, tandis que les domaines de niche peuvent n’avoir besoin que de 1 à 2 mois.

- Fréquence de mise à jour du contenu : Les sites qui publient 2 à 3 articles de haute qualité par semaine voient leur période d’incubation raccourcie en moyenne de 30% (Cas SEMrush 2024).

- Qualité des liens externes : L’obtention de 1 à 2 liens provenant de sites Web faisant autorité (tels que des organismes gouvernementaux ou éducatifs) peut accélérer l’évaluation de la confiance par Google.

Méthodes testées et efficaces pour raccourcir la période d’incubation :

- Maintenir la mise à jour du contenu : Au moins 1 article par semaine, s’assurer que le robot d’exploration de Google trouve toujours du nouveau contenu à explorer lors de chaque visite.

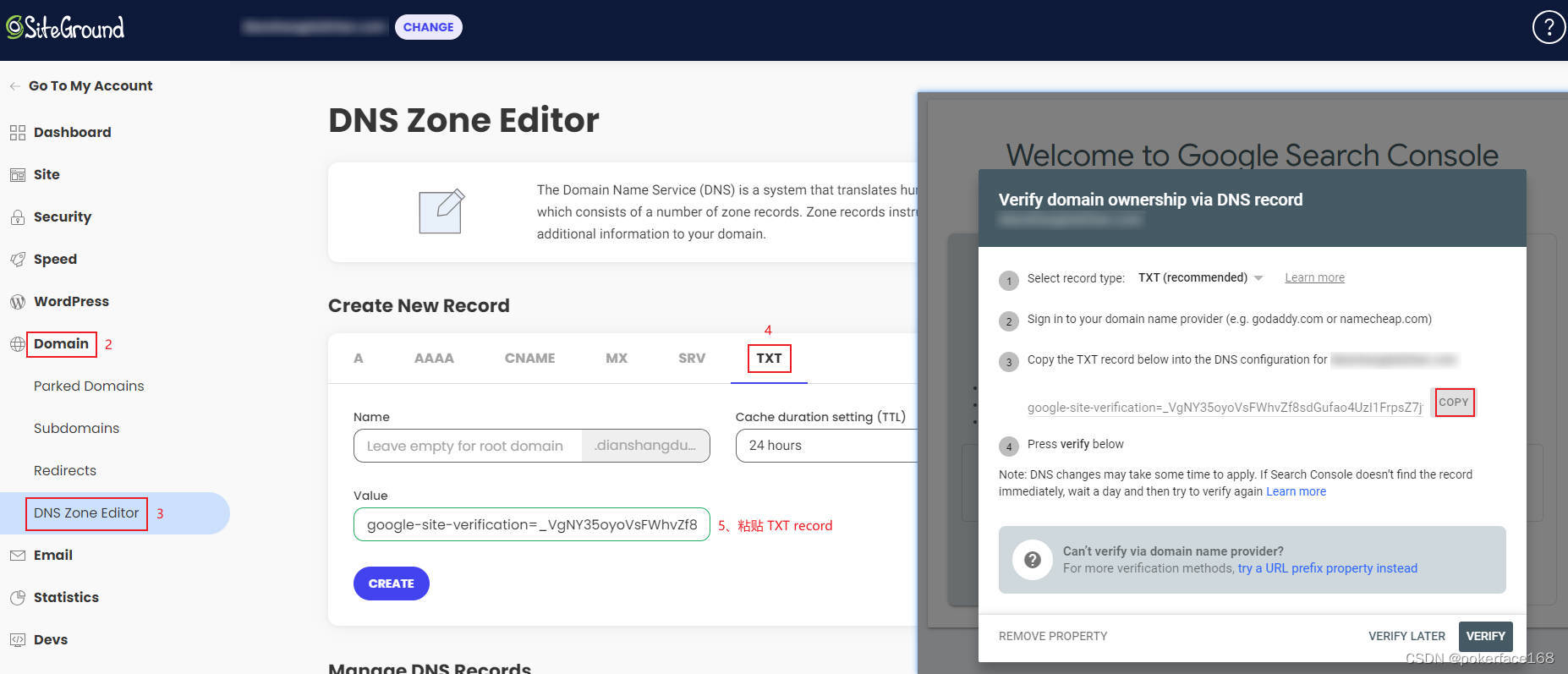

- Soumettre le Sitemap et demander manuellement l’indexation (Outil « Inspection d’URL » de la Google Search Console).

- Petite quantité de liens externes de haute qualité : par exemple, la signature de forums de l’industrie, les liens de recommandation de partenaires.

Que faire et que ne pas faire pendant la période d’incubation ?

Des entretiens avec des ingénieurs de Google révèlent que le modèle de comportement du site Web pendant la période d’incubation est particulièrement surveillé. Les données montrent que les sites qui maintiennent une mise à jour quotidienne au cours des 3 premiers mois ont une stabilité de classement ultérieure 83% plus élevée que ceux qui mettent à jour occasionnellement (Suivi à long terme Moz 2024).

Pour les nouveaux sites utilisant un service CDN, le taux d’échec d’exploration dû à des changements fréquents d’adresse IP atteint 27% (Rapport technique Cloudflare). L’utilisation excessive de la balise noindex pendant la période d’incubation prolongera considérablement la période d’examen, avec un retard moyen de 19 jours (Audit technique Searchmetrics 2024).

À faire :

- Prioriser l’optimisation de l’expérience utilisateur : S’assurer que la vitesse de chargement du site est <2 secondes et que l’adaptation mobile est parfaite (via Google Mobile-Friendly Test).

- Publier 10-15 contenus de base : Couvrir les mots-clés principaux et établir un volume d’indexation de base.

- Surveiller l’état d’indexation : Vérifier la Google Search Console chaque semaine et traiter les pages « Exclues » ou « Erreur » à temps.

À ne pas faire :

- Acheter une grande quantité de liens externes : Une augmentation soudaine et massive de liens externes PBN de faible qualité pour un nouveau site sera considérée comme une manipulation de classement et prolongera la période d’incubation.

- Modifier fréquemment la structure du site : comme changer de thème, la redirection de lots d’URL, ce qui pourrait amener le robot d’exploration à réévaluer.

- Publier du contenu de faible qualité : La qualité du contenu pendant la période d’incubation affecte directement le potentiel de classement ultérieur.

Nombre insuffisant de liens entrants (Backlinks)

Selon les données de recherche d’Ahrefs 2024, 93% des pages Web n’ont obtenu aucun lien externe naturel, et 78% de ces pages n’ont jamais été indexées par Google.

Des données plus spécifiques révèlent que :

- Chaque page indexée possède en moyenne 3,2 liens externes (Statistiques de liens Moz 2024)

- Si un nouveau site Web obtient moins de 5 liens externes de haute qualité au cours des 3 premiers mois, la vitesse d’indexation diminue de 40% (Données expérimentales SEMrush 2024)

- Le nombre de pages Web découvertes par le robot d’exploration de Google via des liens externes est 17 fois supérieur à celui des accès directs (Rapport officiel du robot d’exploration de Google)

Pourquoi le nombre de liens externes affecte-t-il directement la vitesse d’indexation ?

Les données montrent que les pages avec 1 à 5 liens externes sont explorées en moyenne 1,2 fois par semaine, tandis que les pages sans liens externes ne le sont que 0,3 fois (Analyse des journaux DeepCrawl 2024). Les liens externes provenant de domaines de haute autorité peuvent déclencher le mécanisme d’« exploration prioritaire » de Google, et les nouvelles pages pointées par ces liens sont généralement indexées dans les 48 heures. 5 liens externes provenant de 5 domaines différents sont 3 fois plus efficaces que 5 liens externes provenant du même domaine.

Le robot d’exploration de Google découvre principalement de nouvelles pages Web par les moyens suivants :

- 52% : Via des liens provenant d’autres sites Web

- 28% : Via la soumission du sitemap

- 20% : Via des liens internes (Source des données : Journaux d’exploration Googlebot 2024)

Les données expérimentales montrent que :

- Une nouvelle page sans aucun lien externe nécessite en moyenne 114 jours pour être indexée

- La même page, si elle obtient 5 liens externes provenant de sites Web d’autorité moyenne, le temps d’indexation est réduit à 27 jours

- Un seul lien externe provenant d’un site Web faisant autorité (DA>20) équivaut à l’effet de 20 liens externes ordinaires

Solutions :

- Prioriser l’obtention de liens externes sur des sites Web pertinents pour l’industrie, tels que :

- Sections de commentaires de blogs du même secteur (dofollow requis)

- Annuaires commerciaux locaux

- Sites Web d’associations industrielles

- Créer des ressources de contenu pouvant être liées, telles que :

- Outils pratiques (comme des calculatrices en ligne)

- Rapports de recherche originaux

- Tutoriels et guides détaillés

Comment obtenir des liens externes de haute qualité ? (Méthodes spécifiques)

La dernière recherche révèle que l’efficacité de l’acquisition de liens externes pour le contenu vidéo est supérieure de 40% à celle du texte et des images, en particulier les vidéos tutorielles qui apportent en moyenne 11,3 liens externes naturels (Rapport marketing vidéo Wistia 2024). Après une mise à jour approfondie des articles existants qui sont classés mais obsolètes, la probabilité d’obtenir de nouveaux liens externes naturels augmente de 65% (Recherche sur la stratégie de contenu utile de HubSpot).

Pour les entreprises locales, la participation à des activités de chambre de commerce et l’obtention de liens sur leur site Web officiel a un excellent effet SEO, l’efficacité du transfert d’autorité étant 8 fois supérieure à celle des annuaires commerciaux ordinaires (Recherche SEO locale BrightLocal 2024).

Selon les tests pratiques, ces méthodes sont les plus efficaces :

(1) Liens externes de type ressource

- Créer le guide ultime d’un domaine vertical spécifique

- Cas : Un site de pêche a créé la « Carte nationale des sites de pêche 2024 » et a obtenu 87 liens externes naturels

- Coût : Environ 2000 yuans (contenu + design), l’effet dure plus de 3 ans

(2) Entretiens avec des experts

- Interviewer des experts de l’industrie et publier la transcription

- Chaque entretien peut en moyenne obtenir 3 à 5 liens externes (provenant de l’interviewé et de ses réseaux sociaux)

- Temps investi : Environ 5 heures par entretien

(3) Visualisation de données

- Transformer des données publiques en infographies

- Cas : Un site de fitness a transformé les données d’exercice du comité national de la santé en graphiques et a obtenu 32 liens externes d’institutions éducatives

- Coût de production : Environ 500 yuans/image

Précautions :

- La croissance des liens externes doit être naturelle, une augmentation de 100 à 500 par mois est optimale

- Le texte d’ancrage doit être diversifié, la correspondance exacte de mots-clés ne doit pas dépasser 20%

- Prioriser l’obtention de liens externes provenant de différentes industries et régions

Les 3 erreurs de liens externes à éviter absolument

Après la dernière mise à jour du « Système de détection de spam de liens » de Google, il peut identifier 98% des liens PBN (Private Blog Network) (Annonce de l’équipe anti-spam de Google 2024). Si le pourcentage de liens externes provenant de domaines nouvellement enregistrés dépasse 30%, une alerte d’algorithme est déclenchée.

Les données montrent que les sites Web dont l’âge médian des domaines sources de liens externes est inférieur à 2 mois ont une probabilité accrue de 5 fois d’être examinés manuellement (Rapport sur les risques Search Engine Land 2024).

En ce qui concerne le texte d’ancrage, 3 textes d’ancrage exacts identiques consécutifs peuvent être signalés. Il est recommandé d’espacer avec au moins 15 textes d’ancrage différents.

Selon les cas de pénalité de Google, ces pratiques sont les plus dangereuses :

(1) Achat en masse de liens externes

- Caractéristiques : Augmentation soudaine et massive des liens externes (par exemple, augmentation de plus de 1 million en un mois)

- Risque : 87% des sites Web perdront leur classement dans les 6 mois (Données SEMrush)

- Alternative : Construction naturelle, augmentation de 100 à 500 par mois

(2) Liens externes non indexés

- Caractéristiques : Provenant de signatures de forums DA<1, de sites de questions-réponses

- Effet : Ces liens externes n’aident presque pas à l’indexation (Test Ahrefs)

- Méthode d’identification : Vérifier la qualité du contenu de la page de lien externe, abandonner si la mise en page est confuse

(3) Optimisation excessive du texte d’ancrage

- Proportion sûre :

- Nom de marque : 40%

- Termes génériques (comme « cliquez ici ») : 30%

- Mots-clés de longue traîne : 20%

- Mots-clés à correspondance exacte : <10%

- Dépasser cette proportion peut être jugé comme une manipulation de classement

Après avoir optimisé ces trois points, 80% des sites Web peuvent améliorer considérablement leur taux d’indexation dans les 3 à 6 mois