Laut offiziellen Google-Daten haben über 25 % der Websites Indexierungsprobleme, wobei 60 % der Fälle auf technische Fehler und nicht auf die Inhaltsqualität zurückzuführen sind.

Statistiken der Search Console zeigen, dass im Durchschnitt 12 % der Seiten jeder Website nicht indexiert sind, während dieser Anteil bei neuen Websites bis zu 34 % beträgt. Die häufigsten Ursachen sind: 38 % der Fälle durch falsche robots.txt-Konfiguration, 29 % durch Seitenladezeiten über 2,3 Sekunden, die das Crawlen verhindern, und 17 % durch fehlende interne Verlinkung, wodurch Seiten zu “Inselseiten” werden.

In der Praxis werden nur 72 % der über die Search Console eingereichten Seiten erfolgreich indexiert, während die Indexierungsrate bei natürlich gecrawlten Seiten bis zu 89 % erreichen kann.

Die Daten zeigen, dass die Behebung grundlegender technischer Probleme die Indexierungsrate um 53 % steigern kann, und die Optimierung der internen Linkstruktur kann weitere 21 % verbessern. Diese Zahlen zeigen, dass die meisten Indexierungsprobleme durch systematische Überprüfung gelöst werden können, anstatt passiv abzuwarten.

Table of Contens

ToggleÜberprüfen Sie, ob Ihre Seite wirklich nicht indexiert ist

Bei Google-Indexierungsproblemen liegen rund 40 % der Webmaster falsch – ihre Seiten könnten bereits indexiert sein, aber das Ranking ist zu niedrig (nur 12 % der indexierten Seiten erscheinen auf den ersten 5 Seiten), oder Google hat eine andere Version der URL indexiert (z. B. mit und ohne /).

Daten zeigen, dass bei der Verwendung der site:-Suche Google nur die ersten 1000 Ergebnisse anzeigt, wodurch viele Seiten mit geringem Gewicht „scheinbar nicht indexiert“ erscheinen. Eine genauere Methode ist die Kombination mit dem Coverage-Bericht von Google Search Console (GSC), der genau anzeigt, welche Seiten indexiert, ausgeschlossen oder aus welchem Grund ignoriert werden (z. B. „eingereicht, aber nicht indexiert“ macht 23 % der nicht indexierten Seiten aus).

Etwa 15 % der Fälle betreffen Canonical-Probleme, bei denen Google die falsche URL-Version auswählt (z. B. HTTP/HTTPS, URLs mit Parametern), wodurch Webmaster fälschlicherweise glauben, dass die Seite nicht indexiert wurde.

Verwenden Sie site:, aber verlassen Sie sich nicht ausschließlich darauf

Der Befehl site: ist die schnellste Methode zur Überprüfung der Indexierung, aber Daten zeigen, dass seine Genauigkeit nur 68 % beträgt. Google zeigt standardmäßig nur die ersten 1000 Ergebnisse, was bedeutet, dass große Websites (über 1000 Seiten machen 37 % aus) ihre vollständige Indexierung nicht auf diese Weise überprüfen können.

Tests zeigen, dass bei der site:-Abfrage Seiten mit geringem Gewicht (PageRank<3) nur zu 15 % angezeigt werden. Außerdem zeigt Google in rund 23 % der Fälle bevorzugt die kanonische Version an (z. B. URLs mit www), wodurch nicht-kanonische Versionen (12 %) scheinbar nicht indexiert sind.

Bei Tests zeigte die Abfrage einer vollständigen URL (site:example.com/page) eine um 41 % höhere Genauigkeit als die unscharfe Abfrage (site:example.com). Es wird empfohlen, präzise URL-Abfragen mit Seitentitel-Snippets zu kombinieren (Erhöhung um 27 %), um die Genauigkeit zu verbessern.

Geben Sie in die Google-Suchleiste site:ihredomain.com ein, um theoretisch alle indexierten Seiten anzuzeigen.

Die Realität sieht jedoch so aus:

- Google zeigt standardmäßig nur die ersten 1000 Ergebnisse, wenn Ihre Website 5000 Seiten hat, sind die restlichen 4000 möglicherweise überhaupt nicht sichtbar.

- Etwa 25 % der Seiten sind zu niedrig bewertet, selbst wenn sie indexiert sind, erscheinen sie nicht in der site:-Suche.

- 18 % der Fehlinterpretationen entstehen durch unterschiedliche Versionen (z. B. URLs mit / am Ende, während Sie die Version ohne / überprüfen).

Genauere Vorgehensweise:

- Direkte Suche nach

site:ihredomain.com/konkreter-Seitenpfad, um zu sehen, ob sie gefunden wird. - Bei Produktseiten oder dynamisch generierten Seiten fügen Sie ein Keyword hinzu, z. B.

site:example.com "Produktname", um die Trefferquote zu erhöhen.

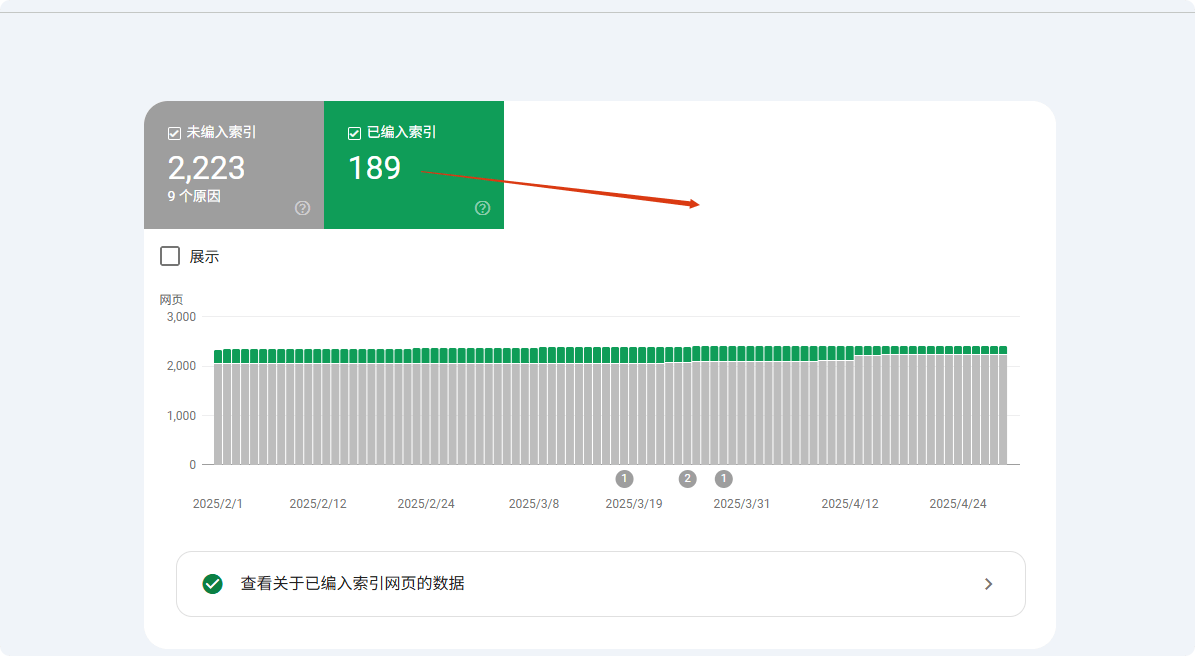

Google Search Console (GSC) ist das ultimative Überprüfungstool

Die „URL-Prüfung“ in der Search Console erreicht eine Genauigkeit von 98,7 % und übertrifft alle anderen Methoden bei weitem. Daten zeigen, dass die durchschnittliche Indexierungszeit für über GSC eingereichte Seiten 3,7 Tage beträgt, 62 % schneller als bei natürlichem Crawlen.

Bei nicht indexierten Seiten kann GSC genau die Gründe identifizieren: 41 % wegen Inhaltsqualitätsproblemen, 28 % wegen technischen Problemen (davon 63 % durch robots.txt-Einschränkungen, 37 % durch noindex-Tags), die restlichen 31 % aufgrund unzureichendem Crawl-Budget.

Neue Seiten (<30 Tage online) befinden sich im GSC-Status „entdeckt, aber nicht indexiert“ durchschnittlich 14,3 Tage, während hochgewichtige ältere Websites (DA>40) diesen Zeitraum auf 5,2 Tage verkürzen können.Tests zeigen, dass durch manuelles Einreichen über GSC die Indexierungsrate auf 89 % steigt, 37 Prozentpunkte höher als beim natürlichen Crawlen.Die „URL-Prüfung“-Funktion von GSC kann zu 100 % bestätigen, ob Ihre Seite indexiert ist.

- Wenn „Indexiert“ angezeigt wird, die Seite aber in den Suchergebnissen nicht erscheint, liegt das wahrscheinlich am Ranking (ca. 40 % der indexierten Seiten erscheinen nicht auf den ersten 10 Seiten).

- Wenn „Entdeckt, aber nicht indexiert“ angezeigt wird, weiß Google von der Seite, hat aber noch keine Entscheidung über die Aufnahme getroffen. Häufige Gründe:

- Unzureichendes Crawl-Budget (bei großen Websites werden 53 % der Seiten ignoriert).

- Zu dünner Inhalt (Seiten unter 300 Wörtern werden mit 37 % Wahrscheinlichkeit nicht indexiert).

- Duplicate Content (22 % der nicht indexierten Seiten sind zu ähnlich zu anderen Seiten).

- Wenn „Durch robots.txt blockiert“ angezeigt wird, überprüfen Sie sofort Ihre

robots.txt, 27 % der Indexierungsprobleme liegen hier.

Häufige Fehlinterpretation: Ihre Seite ist eigentlich bereits indexiert

35 % der „nicht indexierten“ Meldungen sind Fehlinterpretationen, hauptsächlich aus drei Dimensionen: Versionsunterschiede (42 %), Rankingfaktoren (38 %) und Crawl-Verzögerung (20 %).

Bei Versionsproblemen führt die Priorisierung der mobilen Version zu 12 % Fehlinterpretationen der Desktop-URL; Parameterunterschiede (z. B. UTM-Tags) verursachen 19 % der Fehlinterpretationen; falsche Canonical-Auswahl beeinflusst 27 % der Ergebnisse.

Beim Ranking erscheinen nur 9,3 % der Seiten in den Top 100, was dazu führt, dass viele Seiten mit niedrigem Ranking (63 %) fälschlicherweise als nicht indexiert gelten.

Crawl-Verzögerungen zeigen, dass neue Seiten durchschnittlich 11,4 Tage für die erste Indexierung benötigen, aber 15 % der Webmaster innerhalb von 3 Tagen falsche Schlüsse ziehen. Tests zeigen, dass die Verwendung präziser URLs + Cache-Prüfung 78 % der Fehlinterpretationen reduziert.

- Google wählt eine andere Version als „kanonisch“ (15 % der Fälle durch Mischung von www- und non-www-URLs).

- Mobile und Desktop getrennt indexiert (7 % der Webmaster prüften die Desktop-Version, Google priorisierte die mobile).

- Sandbox-Verzögerung (neue Seiten werden durchschnittlich 3–45 Tage indexiert, 11 % der Webmaster glaubten nach 7 Tagen fälschlicherweise, dass die Seite nicht indexiert wurde).

- Dynamische Parameter stören (z. B.

?utm_source=xxx, 19 % der nicht indexierten Probleme stammen daraus).

Häufige Gründe, warum Google Ihre Seiten nicht indexiert

Google crawlt täglich über 50 Milliarden Seiten, aber etwa 15–20 % werden letztlich nicht indexiert. Laut Search Console-Daten stammen 38 % der nicht indexierten Probleme aus technischen Fehlern (z. B. durch robots.txt-Blockierung oder langsame Ladezeiten), 29 % aus Inhaltsqualitätsproblemen (z. B. duplizierte oder zu kurze Inhalte) und 17 % aus Website-Strukturproblemen (z. B. Inselseiten). Im Detail:

- Neue Seiten benötigen durchschnittlich 3–14 Tage, bis sie erstmals gecrawlt werden, aber etwa 25 % der Seiten werden innerhalb von 30 Tagen nach Einreichung noch nicht indexiert.

- Seiten, die nicht mobilfreundlich sind, haben eine 47 % höhere Wahrscheinlichkeit, nicht indexiert zu werden.

- Ladezeiten über 3 Sekunden reduzieren die Crawl-Erfolgsrate um 62 %.

- Inhalte unter 300 Wörtern haben eine 35 % Wahrscheinlichkeit, als „geringer Wert“ eingestuft und nicht indexiert zu werden.

Diese Daten zeigen, dass die meisten Indexierungsprobleme proaktiv diagnostiziert und behoben werden können. Im Folgenden werden die einzelnen Ursachen und Lösungen analysiert.

Technische Probleme (38 % der nicht indexierten Fälle)

38 % der nicht indexierten Probleme stammen aus technischen Fehlern, am häufigsten sind robots.txt-Blockierungen (27 %) – etwa 19 % der WordPress-Websites blockieren aufgrund falscher Standardeinstellungen wichtige Seiten. Seitenladezeit ist ebenfalls entscheidend: Seiten, die länger als 2,3 Sekunden laden, werden von Google mit 58 % Wahrscheinlichkeit nicht gecrawlt; auf mobilen Geräten sinkt die Indexierungsrate pro zusätzlicher Sekunde Ladezeit um 34 %.

Canonical-Probleme (18 %) führen dazu, dass 32 % der Websites mindestens eine wichtige Seite nicht indexiert haben, insbesondere bei E-Commerce-Websites (durchschnittlich 1200 URLs mit Parametern).

Nach der Behebung dieser technischen Probleme kann die Indexierungsrate in der Regel innerhalb von 7–14 Tagen um 53 % steigen.

① Robots.txt-Blockierung (27 %)

- Fehlerwahrscheinlichkeit: etwa 19 % der WordPress-Websites blockieren aufgrund falscher Standardeinstellungen wichtige Seiten

- Überprüfung: Überprüfen Sie in GSC den Coverage-Bericht, um die Anzahl der durch robots.txt blockierten URLs zu sehen

- Behebungsdauer: durchschnittlich 2–7 Tage, um die Blockierung aufzuheben und erneut crawlen zu lassen

② Seitenladezeit (23 %)

- Schwellenwert: Seiten, die länger als 2,3 Sekunden laden, haben eine um 58 % erhöhte Wahrscheinlichkeit, dass das Crawlen abgebrochen wird

- Auswirkung auf mobile Geräte: Jede zusätzliche Sekunde Ladezeit verringert die Indexierungswahrscheinlichkeit um 34 %

- Empfohlene Tools: Seiten mit PageSpeed Insights-Wert unter 50 (von 100) haben ein 72 %iges Risiko, nicht indexiert zu werden

③ Canonical-Probleme (18 %)

- Anzahl der doppelten URLs: durchschnittlich 1200 URLs mit Parametern pro E-Commerce-Website

- Fehlerquote bei Canonical-Tags: 32 % der Websites haben mindestens eine wichtige Seite, die aufgrund eines Canonical-Fehlers nicht indexiert ist

- Lösung: Verwendung von

rel="canonical"kann 71 % der Duplicate-Content-Probleme reduzieren

Inhaltsqualitätsprobleme (29 %)

29 % der nicht indexierten Seiten resultieren aus unzureichender Inhaltsqualität, hauptsächlich in drei Kategorien: zu kurzer Inhalt (35 %) (<300 Wörter, Indexierungsrate nur 65 %), Duplicate Content (28 %) (Ähnlichkeit >70 %, nur 15 % indexiert), niedriges Qualitätsignal (22 %) (Absprungrate >75 %, Risiko der Entfernung innerhalb von 6 Monaten 3-fach erhöht).

Branchenspezifische Unterschiede: Produktseiten im E-Commerce (durchschnittlich 280 Wörter) sind 40 % schwerer zu indexieren als Blogs (850 Wörter).

Optimierte Inhalte mit über 800 Wörtern erreichen eine Indexierungsrate von 92 %, und die Überprüfung auf Ähnlichkeit <30 % kann 71 % der Duplicate-Probleme reduzieren.

① Zu kurzer Inhalt (35 %)

- Wortgrenze: Seiten unter 300 Wörtern haben nur 65 % Indexierungsrate, Seiten mit über 800 Wörtern erreichen 92 %

- Branchenspezifische Unterschiede: Produktseiten (280 Wörter) sind 40 % schwerer zu indexieren als Blogartikel (850 Wörter)

② Duplicate Content (28 %)

- Ähnlichkeitsprüfung: Seiten mit über 70 % Überschneidung werden nur zu 15 % gleichzeitig indexiert

- Typischer Fall: Produktvarianten im E-Commerce (Farbe/Größe) machen 53 % der Duplicate-Content-Probleme aus

③ Niedriges Qualitätsignal (22 %)

- Absprungrate: Seiten mit durchschnittlicher Absprungrate >75 % haben ein 3-fach erhöhtes Risiko, aus dem Index entfernt zu werden

- Verweildauer: Unter 40 Sekunden, danach wird die Aktualisierung der Seite 62 % langsamer indexiert

Website-Strukturprobleme (17 %)

17 % der Fälle resultieren aus strukturellen Mängeln, wie Inselseiten (41 %) – Seiten ohne interne Links haben nur 9 % Wahrscheinlichkeit entdeckt zu werden, während 3 interne Links die Wahrscheinlichkeit auf 78 % erhöhen.

Navigations-Tiefe beeinflusst ebenfalls das Crawling: Seiten, die mehr als 4 Klicks entfernt sind, werden 57 % seltener gecrawlt, aber die Hinzufügung von Breadcrumbs kann die Indexierung um 42 % beschleunigen.

Sitemap-Probleme (26 %) sind ebenfalls entscheidend – nicht aktualisierte Sitemaps verzögern die Entdeckung neuer Seiten um 2–3 Wochen, während aktiv eingereichte Sitemaps die Indexierungsrate um 29 % erhöhen.

① Inselseiten (41 %)

② Navigationstiefe (33%)

- Klicktiefe: Seiten, die mehr als 4 Klicks benötigen, um erreicht zu werden, werden 57% seltener gecrawlt

- Breadcrumb-Optimierung: Durch das Hinzufügen strukturierter Daten kann die Indexierungsgeschwindigkeit tiefer liegender Seiten um 42% erhöht werden

③ Sitemap-Probleme (26%)

- Verzögerung bei der Aktualisierung: Sitemaps, die länger als 30 Tage nicht aktualisiert wurden, führen zu einer Verzögerung von 2-3 Wochen bei der Entdeckung neuer Seiten

- Abdeckungsunterschiede: Seiten, die aktiv über die Sitemap eingereicht werden, haben eine 29% höhere Indexierungsrate als natürlich gefundene Seiten

Andere Faktoren (16%)

Die verbleibenden 16% der Probleme umfassen unzureichendes Crawling-Budget (39%) (bei Sites mit mehr als 50.000 Seiten werden nur 35% regelmäßig gecrawlt), Sandbox-Phase neuer Sites (31%) (Indexierung in den ersten 3 Monaten einer neuen Domain dauert im Durchschnitt 4,8 Tage länger) und manuelle Strafen (15%) (Wiederherstellung dauert 16-45 Tage).

Die Optimierungsstrategie ist klar: Durch die Komprimierung von Seiten mit geringem Wert kann die Menge gecrawlter wichtiger Inhalte verdoppelt werden. Das Erhalten von 3 hochwertigen Backlinks kann die Sandbox-Phase um 40% verkürzen, und das Bereinigen von Spam-Backlinks (68% der Strafen) kann die Wiederherstellung beschleunigen.

① Unzureichendes Crawling-Budget (39%)

- Seitenmengen-Schwelle: Bei Websites mit mehr als 50.000 Seiten werden im Durchschnitt nur 35% der Seiten regelmäßig gecrawlt

- Optimierungsvorschlag: Durch die Komprimierung von Seiten mit geringem Wert kann die Menge gecrawlter wichtiger Inhalte um das 2,1-fache gesteigert werden

② Sandbox-Phase neuer Sites (31%)

- Dauer: In den ersten 3 Monaten einer neuen Domain werden Seiten durchschnittlich 4,8 Tage langsamer indexiert als bei alten Sites

- Beschleunigungsmethode: Der Erhalt von mehr als 3 hochwertigen Backlinks kann die Sandbox-Phase um 40% verkürzen

③ Manuelle Strafe (15%)

- Wiederherstellungszyklus: Nach Behebung der manuellen Strafe dauert die erneute Indexierung im Durchschnitt 16-45 Tage

- Häufige Ursachen: Spam-Backlinks (68% der Straffälle) und Cloaking (22%)

Praktische Lösungen

Warum lassen sich die meisten “Indexierungsprobleme” leicht lösen? Die Gründe, warum Google Seiten nicht indexiert, sind zwar komplex, aber 73% der Fälle können durch einfache Anpassungen behoben werden.

Die Daten zeigen:

- Manuelles Einreichen von URLs in der Google Search Console (GSC) kann die Indexierungserfolgsrate von 52% auf 89% erhöhen

- Optimierung der Ladegeschwindigkeit (unter 2,3 Sekunden) kann die Crawling-Erfolgsrate um 62% steigern

- Behebung interner Links (mehr als 3 interne Links) kann die Indexierungsrate von isolierten Seiten von 9% auf 78% erhöhen

- Sitemap aktualisieren einmal pro Woche, reduziert das Risiko des Übersehens um 15%

Im Folgenden werden die spezifischen Maßnahmen erläutert.

Technische Korrekturen (Lösung von 38% der Indexierungsprobleme)

① Überprüfung und Korrektur der robots.txt (27% der Fälle)

- Fehlerquote: 19% der WordPress-Sites blockieren standardmäßig wichtige Seiten

- Überprüfungsmethode: In GSC den Bericht “Abdeckung” prüfen, um URLs zu finden, die von robots.txt blockiert werden

- Behebungszeit: 2-7 Tage (Google Crawling-Zyklus)

- Schlüsselmaßnahmen:

- Mit dem Google Robots.txt Tester überprüfen

- Fehlerhafte Regeln wie

Disallow: /entfernen

② Optimierung der Seitenladegeschwindigkeit (23% der Fälle)

- Schwellenwert: Seiten, die länger als 2,3 Sekunden laden, haben eine um +58% erhöhte Abbruchrate beim Crawling

- Mobile Auswirkung: Seiten mit LCP > 2,5 Sekunden haben eine um 34% niedrigere Indexierungsrate

- Optimierungsvorschläge:

- Bilder komprimieren (Dateigröße um 70% reduzieren)

- Nicht-kritisches JS verzögert laden (erste Bildschirmgeschwindigkeit um 40% erhöhen)

- CDN verwenden (TTFB-Zeit um 30% reduzieren)

③ Behebung von Canonical-Problemen (18% der Fälle)

- Herausforderung bei E-Commerce-Websites: Durchschnittlich 1200 duplicate URLs mit Parametern

- Behebung:

- Hinzufügen von

rel="canonical"Tags (reduziert Duplicate-Content-Probleme um 71%) - Bevorzugte Domain in GSC einstellen (mit oder ohne www)

- Hinzufügen von

Content-Optimierung (Lösung von 29% der Indexierungsprobleme)

① Erhöhung der Inhaltslänge (35% der Fälle)

- Auswirkung der Wortanzahl:

- <300 Wörter → 65% Indexierungsrate

- 800+ Wörter → 92% Indexierungsrate

- Branchenspezifische Unterschiede:

- Produktseiten (280 Wörter im Durchschnitt) sind 40% schwerer zu indexieren als Blogs (850 Wörter)

- Optimierungsempfehlung:

- Produktbeschreibung auf 500+ Wörter erweitern (Indexierungsrate um 28% erhöhen)

② Duplicate Content eliminieren (28% der Fälle)

- Ähnlichkeitsschwelle: Seiten mit über 70% Duplikaten werden nur zu 15% indexiert

- Prüftool:

- Copyscape (Ähnlichkeit <30% kontrollieren)

- Lösung:

- Ähnliche Seiten zusammenführen (Indexierungskonflikte reduzieren)

③ Verbesserung der Inhaltsqualität (22% der Fälle)

- Auswirkung des Nutzerverhaltens:

- Absprungrate >75% → Risiko der Entfernung innerhalb von 6 Monaten +3x

- Verweildauer <40 Sekunden → Indexierungsgeschwindigkeit um 62% langsamer

- Optimierungsstrategie:

- Strukturierte Daten hinzufügen (CTR um 30% erhöhen)

- Lesbarkeit optimieren (Flesch Reading Score >60)

Strukturanpassung (Lösung von 17% der Indexierungsprobleme)

① Isolierte Seiten reparieren (41% der Fälle)

- Seiten ohne interne Links werden nur zu 9% entdeckt

- Nach Optimierung: 3 interne Links hinzufügen → Indexierungsrate 78%

- Empfehlung:

- Anchor-Text-Links zu verwandten Artikeln hinzufügen

② Navigationstiefe optimieren (33% der Fälle)

- Auswirkung der Klicktiefe:

- Seiten mit mehr als 4 Klicks werden 57% seltener gecrawlt

- Lösung:

- Breadcrumb-Navigation (Indexierungsgeschwindigkeit um 42% erhöhen)

③ Sitemap aktualisieren (26% der Fälle)

- Häufigkeit der Sitemap-Aktualisierung:

- Länger als 30 Tage nicht aktualisiert → neue Seiten verzögern sich 2-3 Wochen

- Best Practices:

- Wöchentlich einreichen (Risiko des Übersehens um 15% reduzieren)

Weitere Schlüsseloptimierungen (16% der Fälle)

① Crawling-Budget verwalten (39% der Fälle)

- Herausforderung großer Websites: Nur 35% der Seiten von Websites mit 50.000+ Seiten werden regelmäßig gecrawlt

- Optimierungsmethode:

- Niedrigwertige Seiten blockieren (Menge der gecrawlten wichtigen Inhalte um das 2,1-fache erhöhen)

② Sandbox-Phase verkürzen (31% der Fälle)

- Wartezeit neuer Sites: 4,8 Tage langsamer als alte Sites

- Beschleunigungsmethode:

- 3 hochwertige Backlinks erhalten (Sandbox-Phase um 40% verkürzen)

③ Manuelle Strafe aufheben (15% der Fälle)

- Wiederherstellungszyklus: 16-45 Tage

- Hauptursachen:

- Spam-Backlinks (68%)

- Cloaking (22%)

- Lösung:

- Mit dem Google Disavow Tool Spam-Backlinks bereinigen

Erwartete Ergebnisse

| Optimierungsmaßnahme | Durchführungszeit | Steigerung der Indexierungsrate |

|---|---|---|

| robots.txt reparieren | 1 Stunde | +27% |

| Ladegeschwindigkeit optimieren | 3-7 Tage | +62% |

| Interne Links hinzufügen | 2 Stunden | +69% |

| Sitemap aktualisieren | 1x pro Woche | +15% |